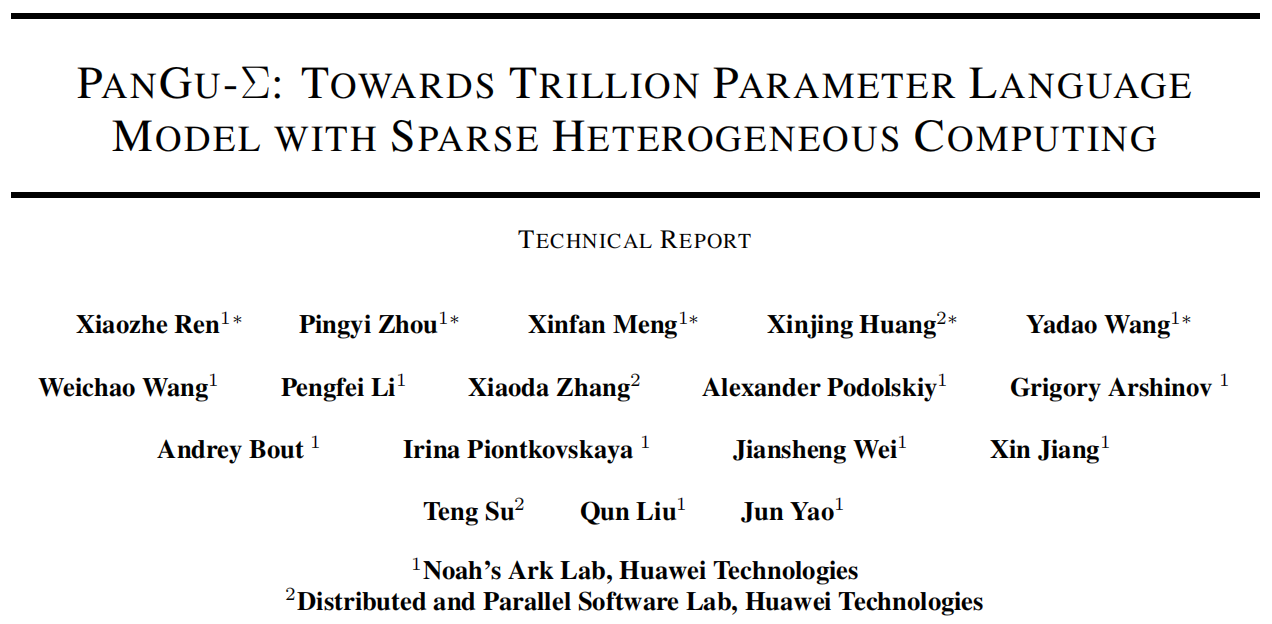

大语言模型的推进显著提升了自然语言理解、生成、推理等多项NLP研究。在本文中,来自华为诺亚试验和和分布式软件实验室的研究人员提出了名为PanGu-Σ的万亿级别模型。该模型的训练基于分布式Ascend 910AI计算芯片和MindSpore代码框架,总参数量高达1.085T。

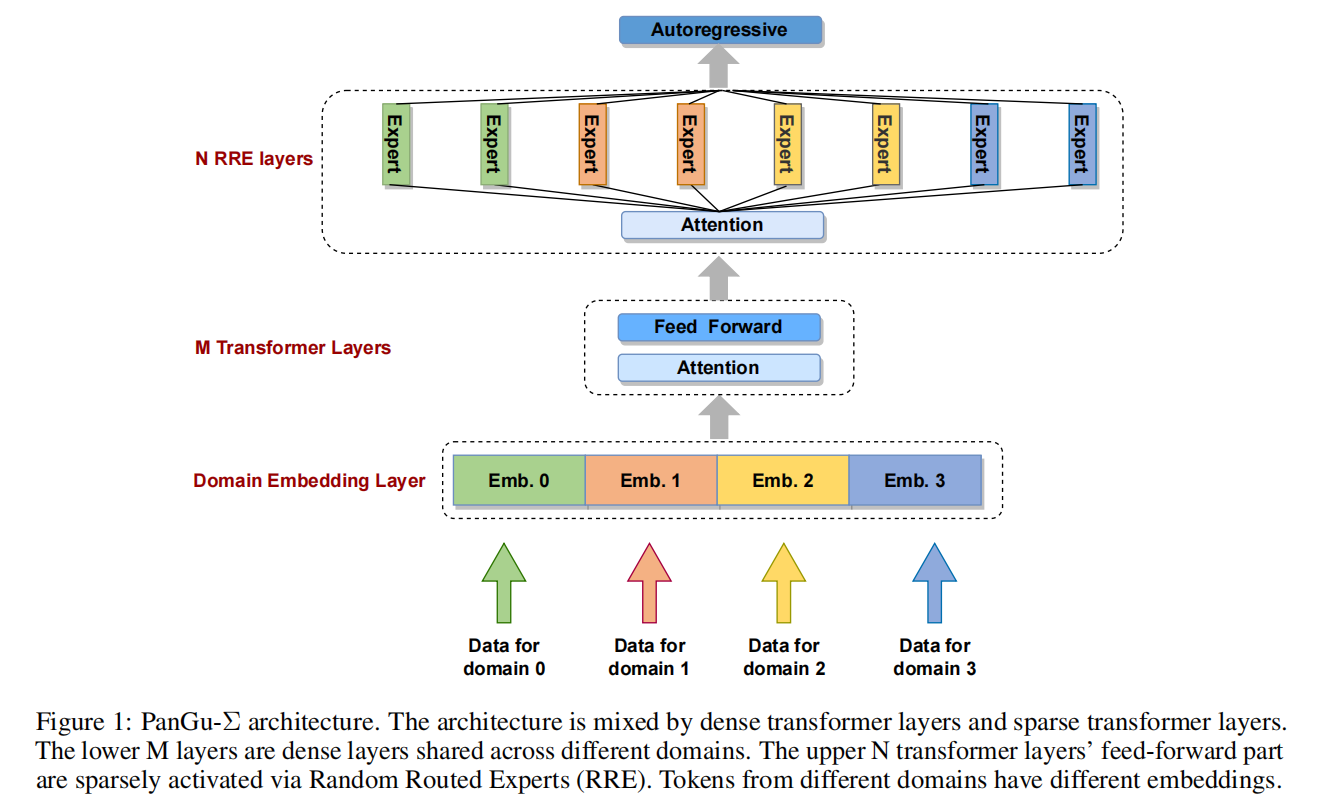

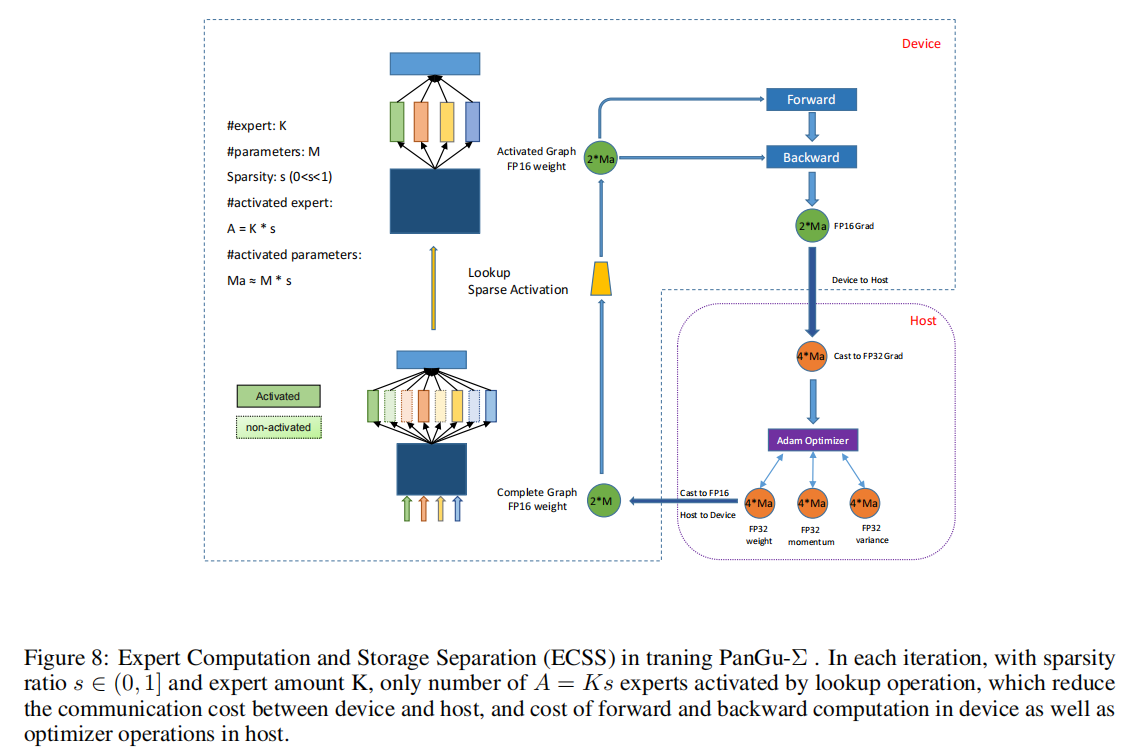

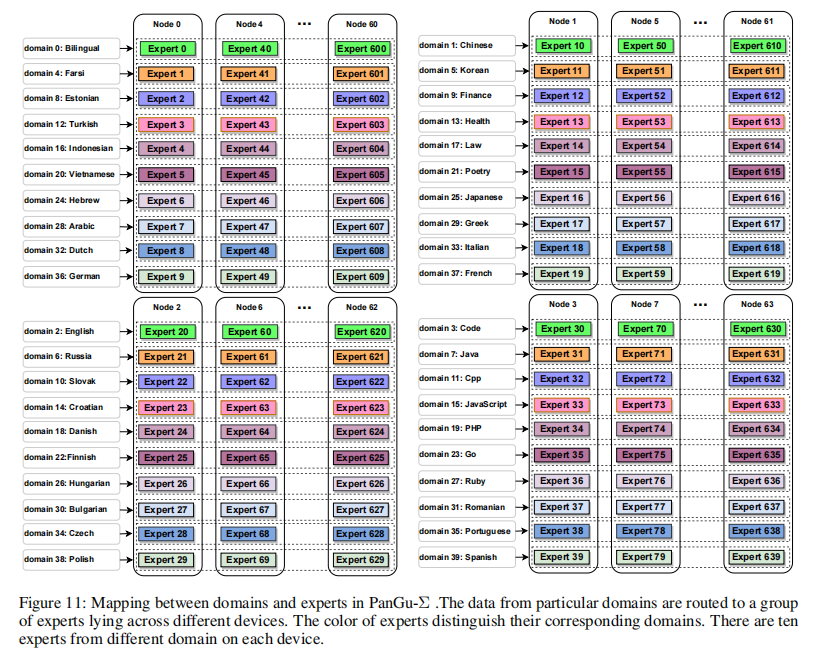

基于这一模型,作者进一步提出了Random Routed Experts(RRE)和Expert Computation and Storage Separation策略以实现参数稀疏化。结果表明上述算法能够提升6.3倍训练速度,并允许3290亿Token作为输入。实验表明,PanGu-Σ能够在多项中文NLP研究中取得一流性能,并可在问答、翻译等多项应用上进行迁移和优化。

论文地址:https://arxiv.org/pdf/2303.10845.pdf

整体框架

Random Routed Experts

Expert Computation and Storage Separation

实验

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง