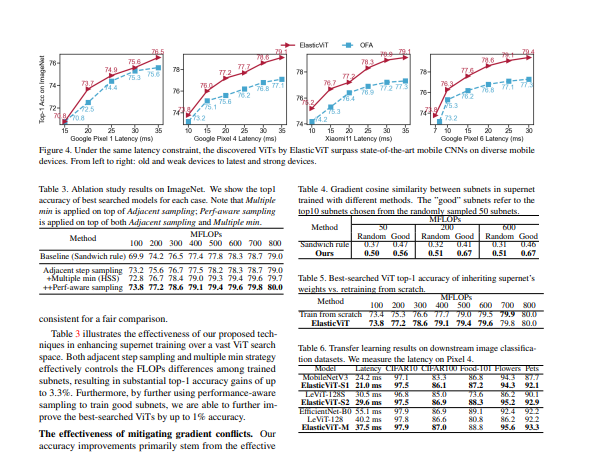

在本文中,提出了ElasticViT,这是一种两阶段的NAS方法,可以训练一个高质量的超级网,用于在不同的移动设备上部署准确和低延迟的视觉变换器。方法引入了两个关键技术来解决梯度冲突问题,通过约束采样子网之间的FLOPs差异和采样潜在的好子网,大大提高了超网训练质量。

ElasticViT: Conflict-aware Supernet Training for Deploying Fast Vision Transformer on Diverse Mobile Devices

Chen Tang, Li Lyna Zhang, Huiqiang Jiang, Jiahang Xu, Ting Cao, Quanlu Zhang, Yuqing Yang, Zhi Wang, Mao Yang

[Tsinghua University & Microsoft Research]

- 神经结构搜索(NAS)在超过1G FLOPs的视觉变压器(ViT)的自动设计中表现出良好的性能。然而,为不同的移动设备设计轻量级和低延迟的ViT模型仍然是一个很大的挑战。

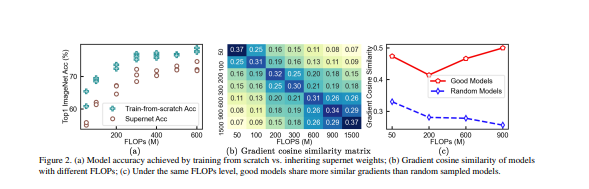

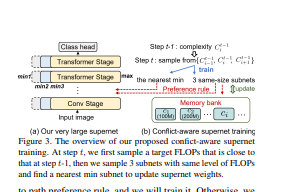

- 在这项工作中,提出了ElasticViT,一种两阶段的NAS方法,在一个非常大的搜索空间上训练一个高质量的ViT超级网,支持广泛的移动设备,然后搜索一个最佳的子网(subnet)来直接部署。然而,先前依靠统一抽样的超级网训练方法存在梯度冲突问题:抽样的子网可能具有巨大的不同的模型大小(例如,50M与2G FLOPs),导致不同的优化方向和低劣的性能。

- 为了解决这一挑战,提出了两种新的采样技术:复杂性感知采样和性能感知采样。复杂性感知采样限制了相邻训练步骤中采样的子网之间的FLOPs差异,同时覆盖了搜索空间中不同大小的子网。性能感知采样进一步选择具有良好准确性的子网,这可以减少梯度冲突并提高超网质量。

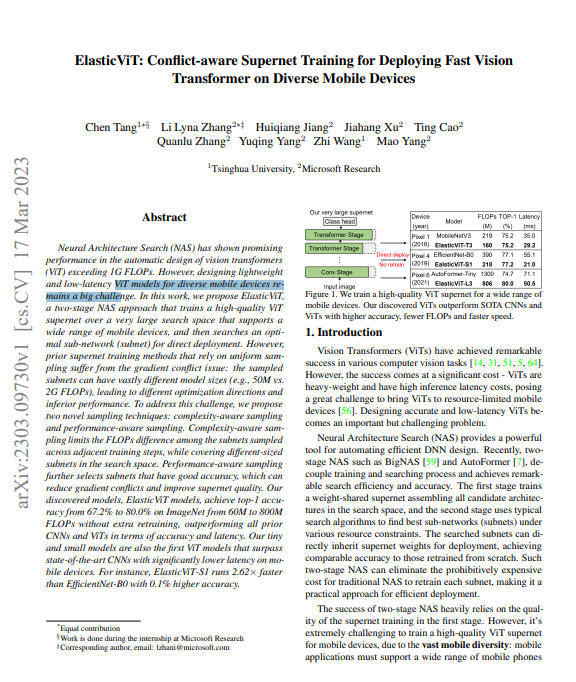

- ElasticViT模型,在ImageNet上从60M到800M的FLOPs中实现了67.2%到80.0%的顶级准确率,无需额外的再训练,在准确率和延迟方面优于之前所有的CNN和ViTs。该微小模型也是第一个超越最先进的CNN的ViT模型,在移动设备上的延迟明显降低。例如,ElasticViT-S1的运行速度是EfficientNet-B0的2.62倍,准确率却高出0.1%。

https://arxiv.org/pdf/2303.09730.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง