【推荐理由】CLIP不适合提取3D几何特征,因为它仅通过自然语言监督在图像和文本上进行了训练。本文提出了一个新的框架,称为CG3D(CLIP进入3D),其中学习了一个3D编码器以展现zero-shot能力。

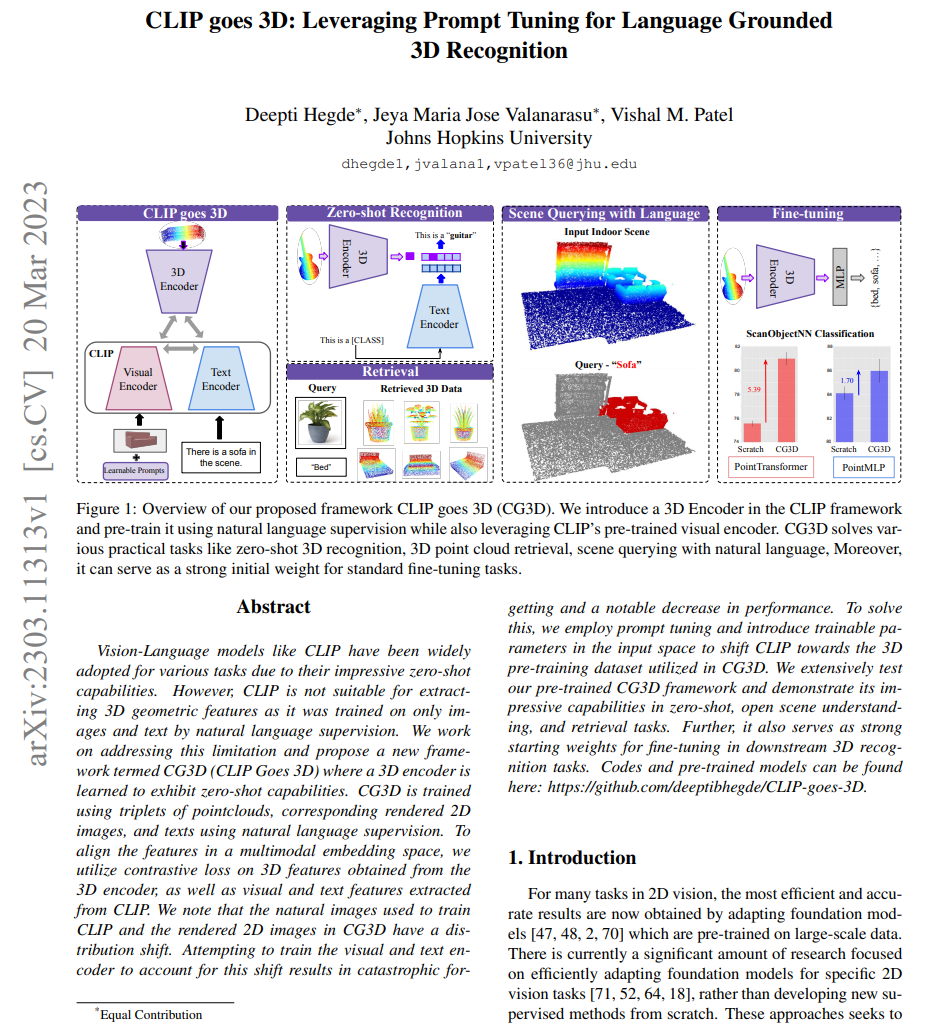

CLIP goes 3D: Leveraging Prompt Tuning for Language Grounded 3D Recognition

Deepti Hegde, Jeya Maria Jose Valanarasu, Vishal M. Patel

[Johns Hopkins University]

【论文链接】:https://arxiv.org/pdf/2303.11313.pdf

【项目链接】:https://github.com/deeptibhegde/CLIP-goes-3D

【摘要】:视觉语言模型(如CLIP)由于其令人印象深刻的zero-shot能力而被广泛应用于各种任务。但是,由于CLIP仅通过自然语言监督训练于图像和文本,因此不适合提取3D几何特征。本文致力于解决这个限制,并提出了一个新的框架,称为CG3D(CLIP进入3D),其中学习了一个3D编码器以展现zero-shot能力。CG3D使用三元组数据进行训练,包括点云、对应的渲染2D图像和文本,并使用自然语言监督。为了将特征对齐到多模态嵌入空间中,利用来自3D编码器的3D特征以及从CLIP提取的视觉和文本特征进行对比损失。由于用于训练CLIP的自然图像和CG3D中的渲染2D图像存在分布偏移。试图训练视觉和文本编码器来解决这个问题会导致灾难性的性能下降。为了解决这个问题,本文采用提示调整,引入可训练参数以将CLIP移向CG3D中使用的3D预训练数据集。实验对预训练的CG3D框架进行了广泛的测试,并展示了其在zero-shot、开放场景理解和检索任务中的卓越能力。此外,它还可作为下游3D识别任务微调的强大起点权重。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง