在这篇论文中,从理论和经验上证明了最先进的探测器在实际场景中(抄袭、假新闻等)不能可靠地检测LLM输出。

Can AI-Generated Text be Reliably Detected?

Vinu Sankar Sadasivan, Aounon Kumar, Sriram Balasubramanian, Wenxiao Wang, Soheil Feizi

[University of Maryland]

- 大型语言模型(LLMs)的快速发展使得它们能够在各种任务中表现出惊人的能力,包括文档完成和问题回答。然而,对这些模型的无节制使用有可能导致恶意的后果,如抄袭、生成假新闻、垃圾邮件等。因此,对人工智能生成的文本进行可靠的检测对于确保负责任地使用LLM至关重要。最近的工作试图解决这个问题,要么使用生成的文本输出中存在的某些模型签名,要么应用水印技术,将特定的模式印在上面。

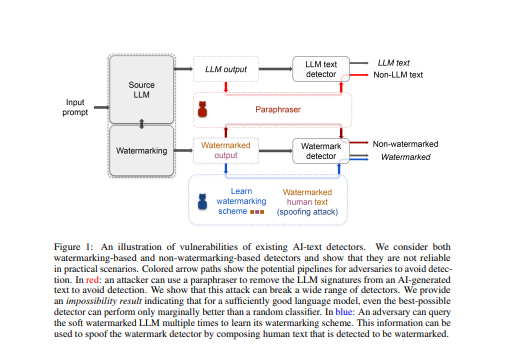

- 在本文中,无论是经验上还是理论上,都表明这些检测器在实际场景中并不可靠。从经验上看,表明转述攻击,即在生成性文本模型的基础上应用轻型转述器,可以破坏一系列的检测器,包括使用水印方案的检测器,以及基于神经网络的检测器和零点分类器。然后,提供了一个理论上不可能的结果,表明对于一个足够好的语言模型,即使是最好的检测器也只能比随机分类器的表现好一点。之后论文表明,即使是受水印方案保护的LLM也容易受到欺骗性攻击,在这种情况下,敌对的人类可以推断出隐藏的水印签名,并将其添加到其生成的文本中,以被检测出是由LLM生成的文本,有可能对其开发者造成声誉上的损害。

- 这些结果可以在社区中就人工智能生成的文本的道德和可靠使用问题展开诚实的对话。

https://arxiv.org/pdf/2303.11156.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง