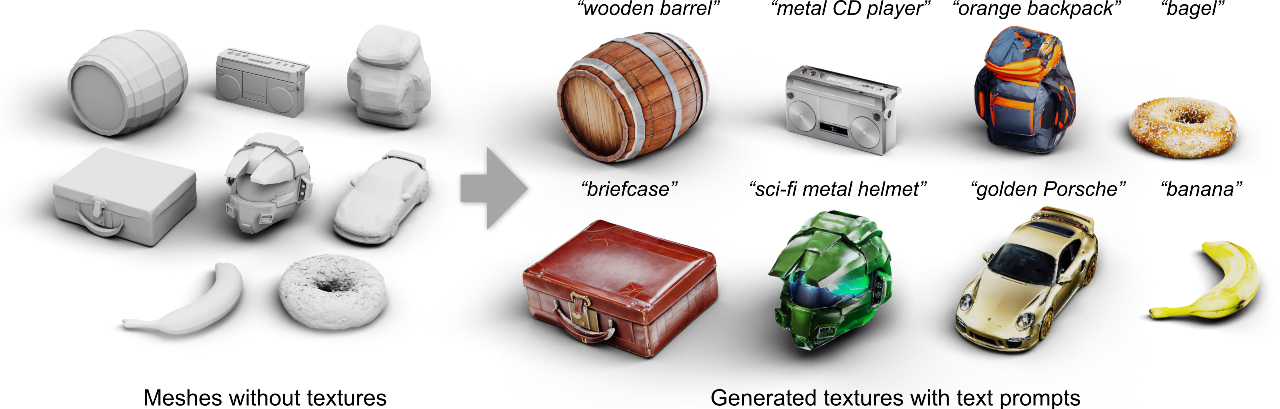

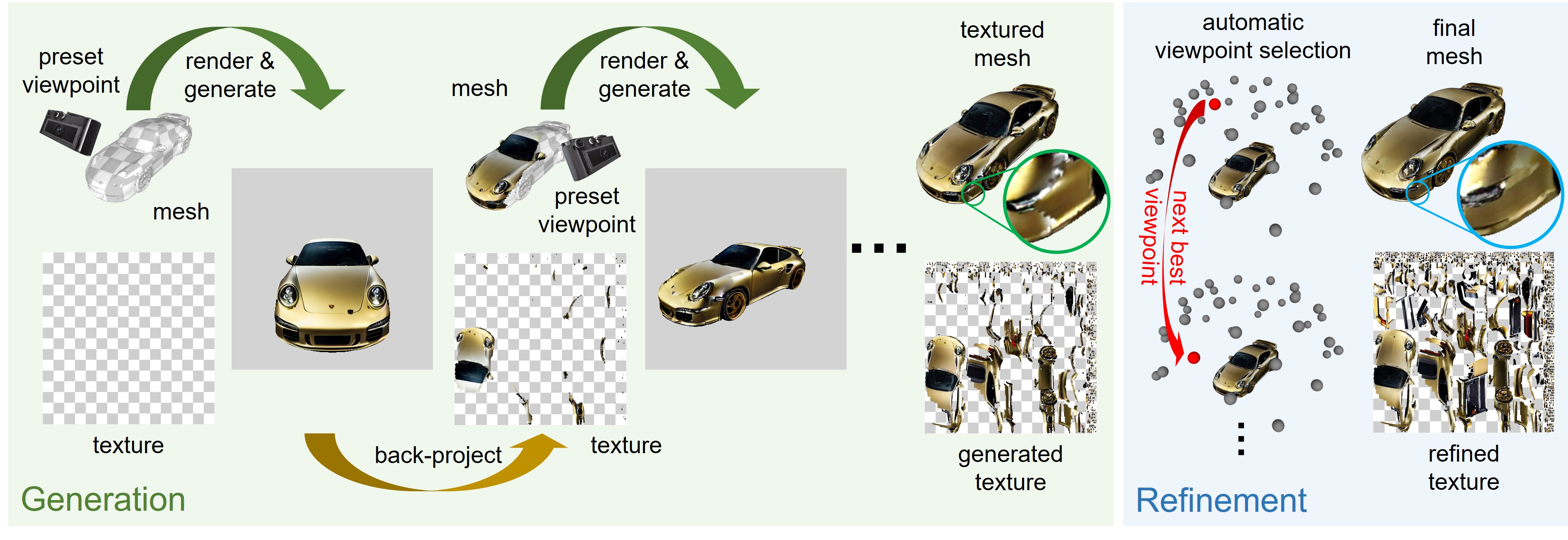

本文提出Text2Tex,一个通过文本提示和扩散模型生成高质量上下文的方法。Text2Tex根据给定的文本提示为3D网格生成高质量的纹理。作者将修补结合到预先训练的深度感知图像扩散模型中,以从多个视点渐进地合成高分辨率局部纹理。为了避免伪影,提出了一种自动视图序列生成方案来确定用于更新部分纹理的下一个最佳视图。大量实验表明,Text2Tex方法明显优于现有的文本驱动方法和基于GAN的方

论文地址:https://daveredrum.github.io/Text2Tex/static/Text2Tex.pdf

项目地址:https://daveredrum.github.io/Text2Tex/

作者:

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง