【推荐理由】文本生成图像的全球性质阻止用户将其探索范围缩小到特定对象。本文提出了一种技术,生成描绘特定对象形状变化的图像集合,实现对象级别的形状探索过程。

Localizing Object-level Shape Variations with Text-to-Image Diffusion Models

Or Patashnik, Daniel Garibi, Idan Azuri, Hadar Averbuch-Elor, Daniel Cohen-Or

[Tel-Aviv University, Independent Researcher]

【论文链接】https://arxiv.org/pdf/2303.11306v1.pdf

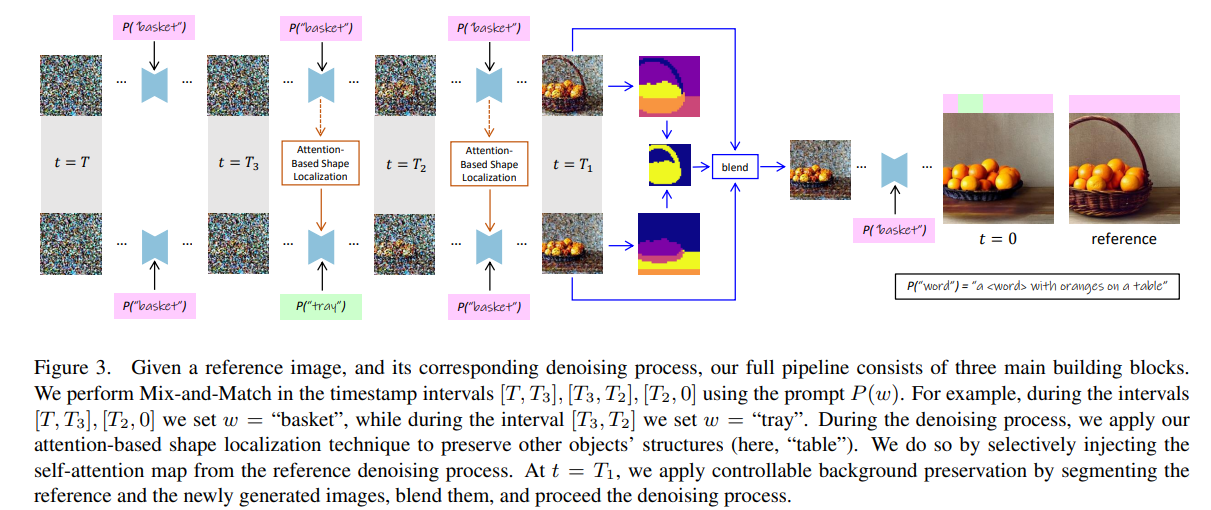

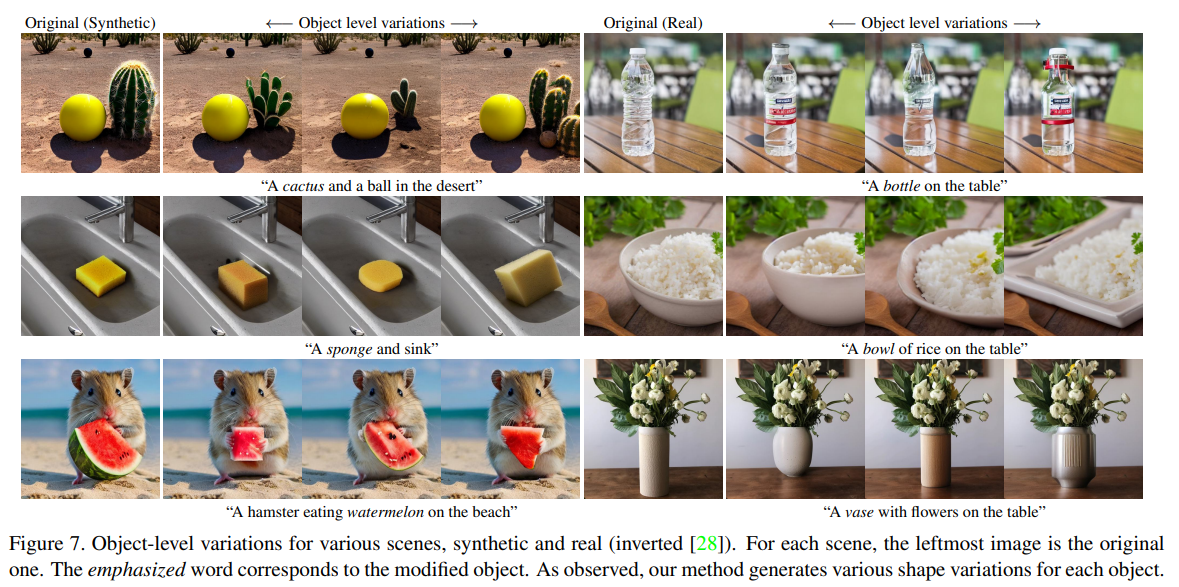

【摘要】文本到图像模型产生的工作流程通常从探索步骤开始,用户需要筛选大量生成的图像。由于文本到图像生成过程的全局性质,用户无法将其探索范围限定在图像中的特定对象上。本文介绍一种生成描绘特定对象形状变化的图像集合的技术,从而实现对象级别的形状探索过程。创建可信的变化很具有挑战性,因为需要在尊重其语义的同时控制所生成对象的形状。在生成对象变化时一个特殊的挑战是准确地定位应用于对象形状上的操作。我们介绍了一种通过在去噪过程中在提示之间切换来实现各种形状选择的提示混合技术。为了定位图像空间操作,我们提出了两种使用自注意力层和交叉注意力层的技术。此外,我们展示了这些定位技术在生成对象变化之外的范围内也是通用和有效的。广泛的结果和比较表明了我们的方法在生成对象变化方面的有效性,以及我们定位技术的竞争力。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง