设计一个云数据中心来处理生成式AI是一个巨大的挑战。一方面,理想情况下最好使用一种加速器,因为这使得数据中心具有弹性,能够处理不可预测的流量高峰和低谷;但另一方面,没有一个加速器能以最优的方式处理算法、模型、数据类型和大小的多样性。

在GTC 2023上,黄仁勋发布了四款AI推理芯片,包括针对生成式AI图像处理、大模型处理的芯片;发布了三个大模型云服务,分别适用于文本、图像和生物研究;发布了超级计算机,以及针对场景优化的应用100个、更新功能的工业元宇宙Omniverse。

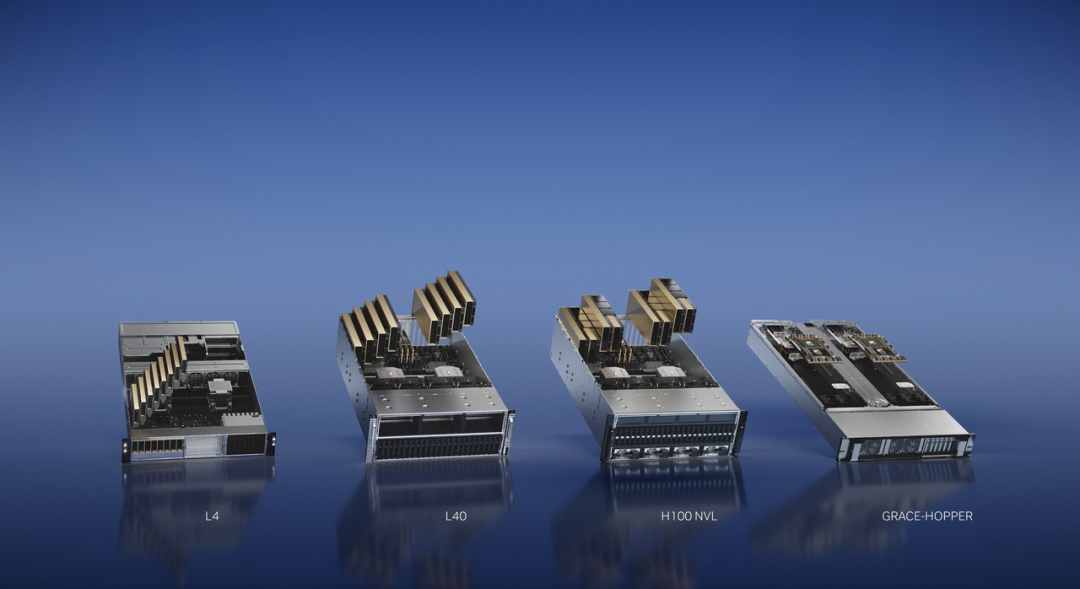

英伟达在GTC 2023上,发布了新的“兼具加速功能和弹性”的推理平台——四种配置、一个体系架构、一个软件栈。

英伟达一口气推出了四款新的芯片,第一款为AI视频芯片 L4。L4是一款针对视频的云推理芯片,功能主要集中于视频解码和转码、频内容审核、视频通话等,例如在视频通话过程中的背景替换、重新打光、增加眼神交流、语音转录和实时语言翻译等。

性能方面,在AI视频领域,一台配备 8个L4的服务器可以取代 100 多台双插槽 CPU 服务器。目前,谷歌云平台已成为首批使用英伟达 AI 云技术的企业之一。

同样是图像领域,推理芯片L40主要用于Omniverse、图形渲染和生成式AI,包括文本到图像和文本到视频等。L40的主要应用场景对标的是在2018年推出、至今仍是推理芯片主流的T4。根据英伟达的介绍,L40 的性能是 T4 的 10 倍,这让L40在处理上述任务时都更加高效。

通过L40,AI编辑软件Runway让用户可以轻松地通过几个笔触就从视频中删除一个对象,或者改变视频的背景或前景。相信目前流行的AI图片生成平台Midjourney、Stable Diffusion、DALL-E等都可以通过L40创造更多的可能性。

可以看到,虽然同为针对图像的AI推理芯片,L4关于云端的视频场景,而L40则更通用,可以实现所有与图像相关的场景优化。

针对如ChatGPT等大模型,英伟达推出了针对大模型的芯片——H100 NVL。

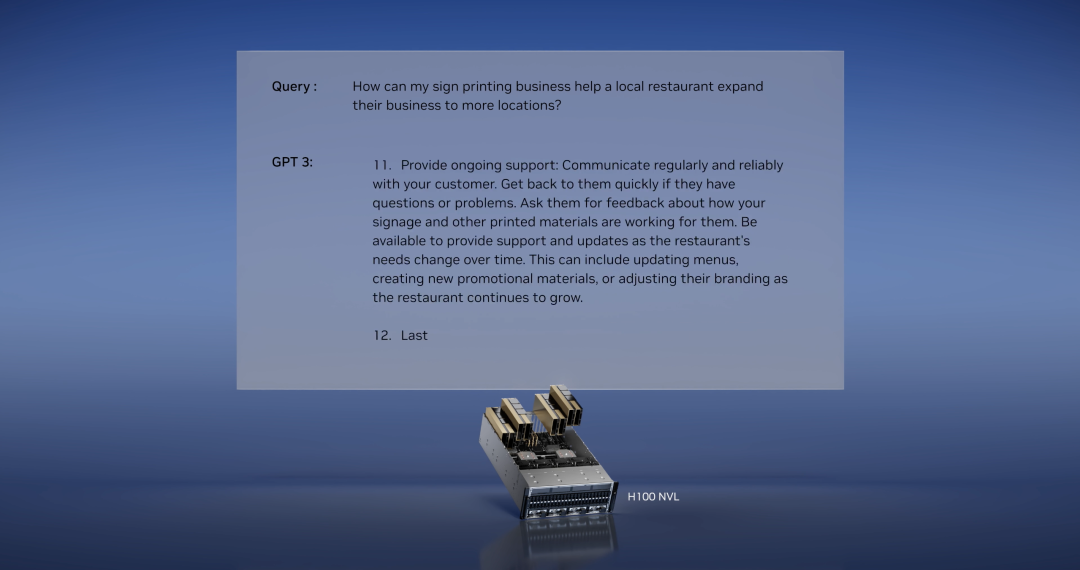

大模型对内存和计算方面的需求较高,也需要很高容量的横向扩展能力。目前,能够处理拥有1750 亿参数的 GPT-3 等大型语言模型的只有A100,而GPT-4等参数量更大的模型则需要更多A100的堆叠。性能方面,一台8卡的H100 NVL的速度是目前标配8卡A100服务器的10倍。这不仅意味着速度的提升,也将降低大模型公司在算力方面的成本。

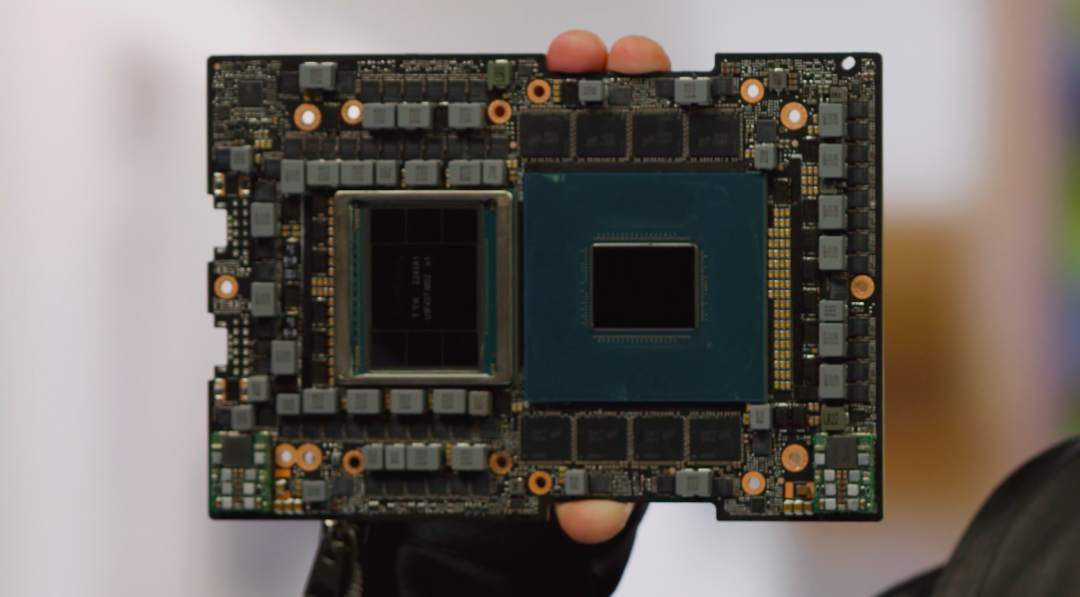

AI计算离不开大数据,针对海量数据的存储、查询与推理,英伟达推出了存算一体超级芯片Grace-Hopper。它由Grace CPU和Hopper GPU连接而成,拥有一个900GB/秒的高速接口。

目前,CPU会存储和查询巨型数据库,然后把结果传输到GPU里进行推理,这需要花费一定的时间。相较于CPU和GPU之间传统的通过PCIE连接,在Grace中查询嵌入并传输到Hopper的速度快了七倍。Grace Hopper 可以用来处理大型数据集,比如适用于推荐系统和大型语言模型的 AI 数据库。

更多内容请访问

英伟达宣布成立“NVIDIA AI Foundations(英伟达AI基础大模型)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง