在这项工作中,论文表明,与SOTA模型相比,生成式LLM在不同的任务和语言中的表现更差,即使输入被翻译成英语并作为系统的查询使用。论文发现生成式模型在高资源语言和拉丁字母语言上的表现更好。论文讨论了GPT中标记化的质量是造成这种差距的潜在原因之一。

MEGA: Multilingual Evaluation of Generative AI

Kabir Ahuja, Rishav Hada, Millicent Ochieng, Prachi Jain, Harshita Diddee, Samuel Maina, Tanuja Ganu, Sameer Segal, Maxamed Axmed, Kalika Bali, Sunayana Sitaram

[微软]

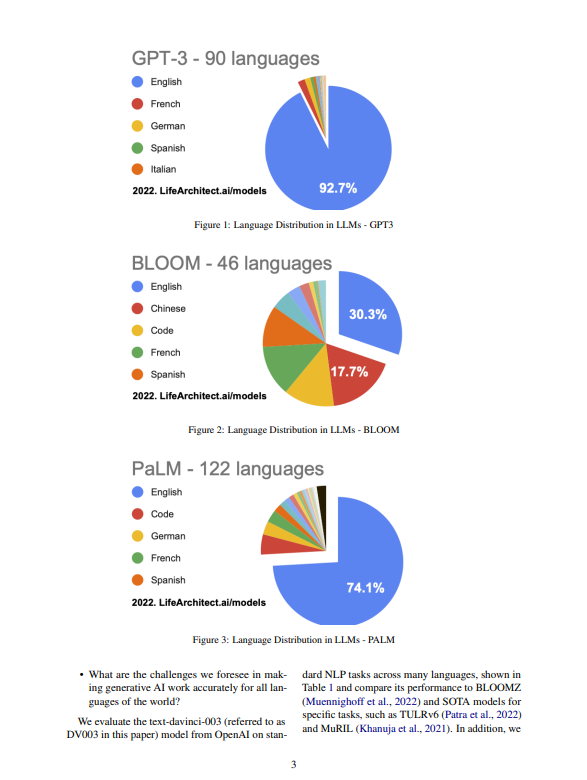

- 生成式人工智能模型在许多自然语言处理任务上有令人印象深刻的表现,如语言理解、推理和语言生成。今天,人工智能界提出的一个最重要的问题是关于这些模型的能力和限制,显然,评估生成性人工智能是非常具有挑战性的。大多数关于生成性大语言模型(LLMs)的研究仅限于英语,目前还不清楚这些模型在理解和生成其他语言方面的能力如何。

- 本文提出了第一个全面的生成性语言模型的基准测试–MEGA,它在标准的NLP基准上对模型进行评估,涵盖了8种不同的任务和33种不同类型的语言。另外还在这些任务上将生成式语言管理模型的性能与最先进的非自回归模型进行了比较,以确定生成式模型与上一代语言管理模型相比有多好的表现。

- 论文对不同语言的模型性能进行了彻底的分析,并讨论了生成式LLM目前对所有语言都不是最优的一些原因。最后,创建了一个在多语言环境中评估生成式语言管理的框架,并为该领域的未来进展提供了方向。

https://arxiv.org/pdf/2303.12528.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง