【推荐理由】视觉和语言领域已经出现了大量的预训练基础模型。本文提出了一种对比双向的图像文本生成模型,名为CoBIT。CoBIT在图像理解、图像-文本理解和基于文本的内容创作方面表现出优越的性能。

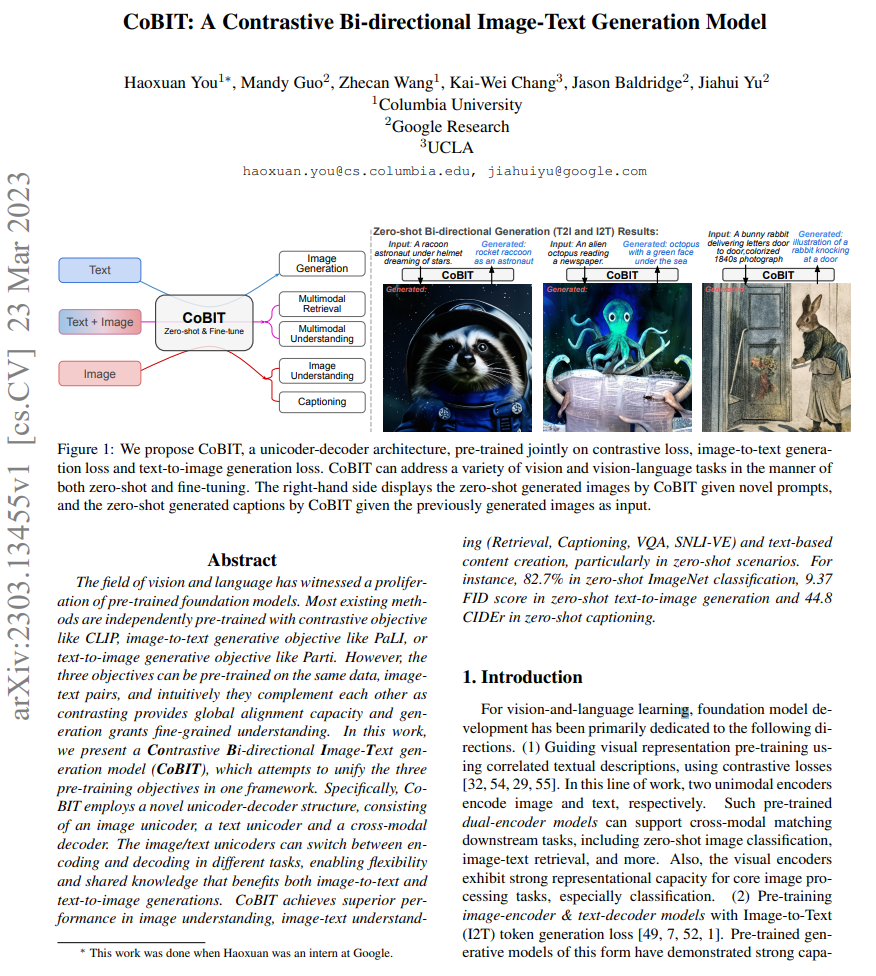

【论文标题】CoBIT: A Contrastive Bi-directional Image-Text Generation Model

【论文作者】Haoxuan You, Mandy Guo, Zhecan Wang, Kai-Wei Chang, Jason Baldridge, Jiahui Yu

【机构】Columbia University & Google Research & UCLA

【论文链接】https://arxiv.org/pdf/2303.13455.pdf

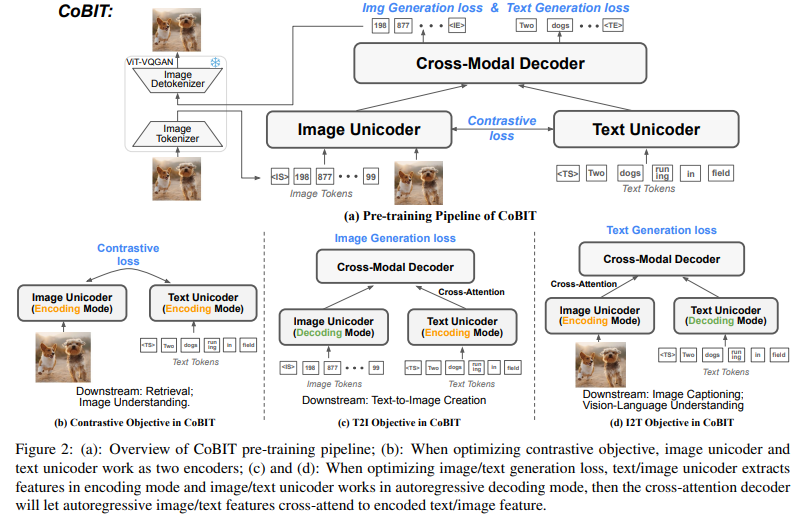

【摘要】视觉和语言领域已经出现了大量的预训练基础模型。目前大多数方法都是使用对比学习目标(如CLIP)、图像到文本生成目标(如PaLI)或文本到图像生成目标(如Parti)进行独立预训练的。然而,这三个目标都可以在同一数据集(图像-文本对)上进行预训练,直觉上它们互补,对比提供了全局对齐能力,生成则提供了细粒度理解。在本研究中,作者提出了一种对比双向的图像文本生成模型(CoBIT),试图将这三个预训练目标统一在一个框架中。具体而言,CoBIT采用了一种新颖的unicoder-decoder结构,包括一个图像unicoder、一个文本unicoder和一个跨模态decoder。图像/文本unicoder可以在不同任务中切换编码和解码,实现了灵活性和共享知识,使得图像到文本和文本到图像的生成都能够受益。CoBIT在图像理解、图像-文本理解(检索、字幕、视觉问答、SNLI-VE)和基于文本的内容创作方面表现出优越的性能,特别是在零样本情况下。例如,在零样本ImageNet分类中达到了82.7%的准确率,在零样本文本到图像生成中达到了9.37的FID得分,在零样本字幕生成中达到了44.8的CIDEr分数。

关于作者Jiahui Yu:

他是Google Brain的一名研究科学家。于2020年在伊利诺伊大学厄巴纳-香槟分校获得博士学位,导师是Thomas Huang教授。之前,他在中国科学技术大学的少年班获得了计算机科学学士学位,并毕业时获得了优异毕业生称号。在博士期间,曾在微软亚洲研究院、Face++/Megvii、Adobe研究、Snap研究、Jump Trading、百度研究、英伟达研究和Google Brain工作。

他的研究领域涵盖序列建模(语言、语音、视频、金融数据)、计算机视觉、生成模型和高性能计算。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง