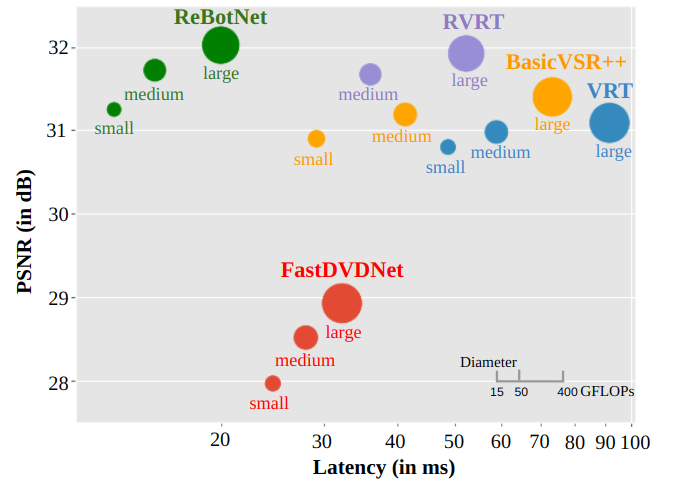

大多数视频恢复网络运行速度缓慢、计算负荷高,无法为实时视频增强等实际应用场景提供支持。在本工作中,作者设计了一种高效快速的框架,可用于实时视频增强,例如实时视频通话和视频流。本文提出的方法名为重复瓶颈混合网络(ReBotNet),采用双分支框架。第一分支通过使用ConvNext编码器,将输入帧沿空间和时间维度进行Token处理,然后使用瓶颈混合器处理这些抽象标记,从而学习时空特征。为进一步提高时间一致性,第二分支直接对从单个帧中提取的标记进行混合。然后,一个公共解码器将两个分支的特征合并以预测增强帧。此外,本文提出了一种循环训练方法,利用最后一帧的预测结果来有效增强当前帧,同时改善时间一致性。为了评估,本文策划了两个新的数据集,模拟实际的视频通话和流媒体场景,并在多个数据集上展示了广泛的结果。与现有方法相比,ReBotNet具有更低的计算负荷、更少的内存需求和更快的推理时间。

标题:ReBotNet: Fast Real-time Video Enhancement

作者:

论文:https://arxiv.org/pdf/2303.13504.pdf

平台:https://jeya-maria-jose.github.io/rebotnet-web/

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง