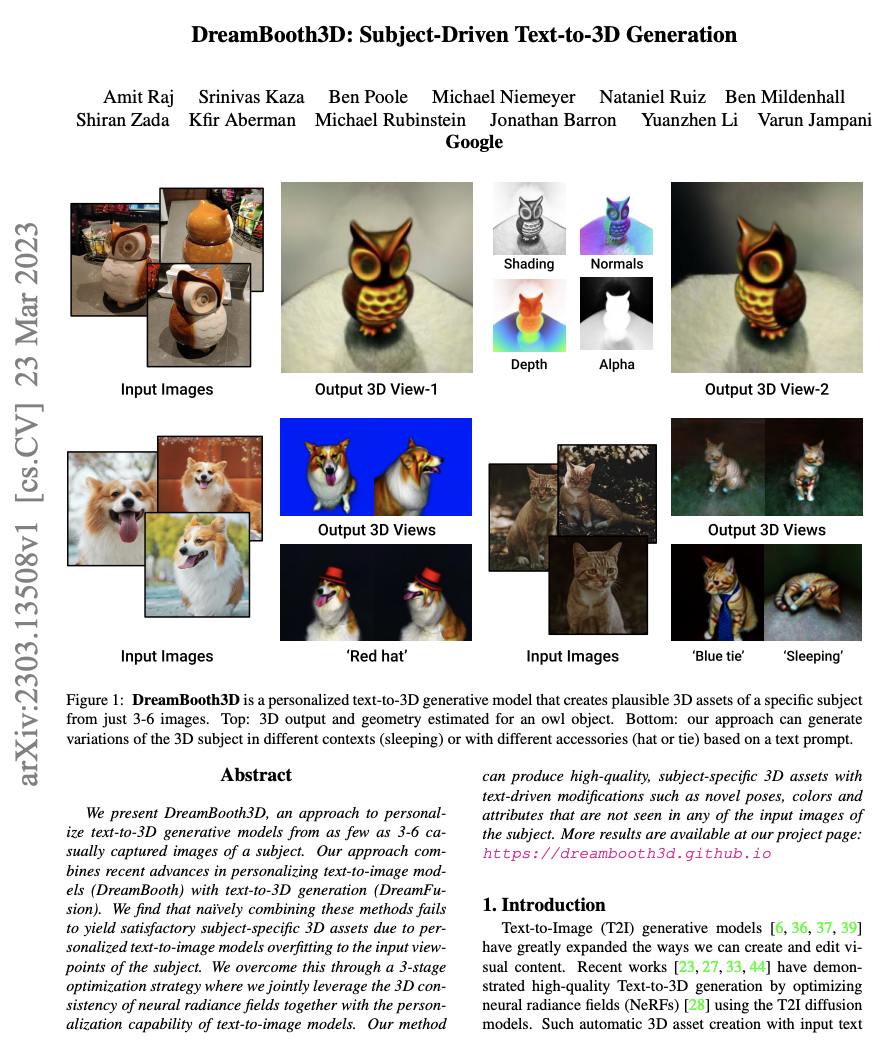

【推荐理由】本文展示了 DreamBooth3D,这是一种从 3-6 张随意拍摄的主题图像中个性化文本到 3D 生成模型的方法。 该方法可以生成具有文本驱动修改的高质量、特定于主题的 3D内容。

DreamBooth3D: Subject-Driven Text-to-3D Generation

Amit Raj, Srinivas Kaza, Ben Poole, Michael Niemeyer, Nataniel Ruiz, Ben Mildenhall, Shiran Zada, Kfir Aberman, Michael Rubinstein, Jonathan Barron, Yuanzhen Li, Varun Jampani

[Google]

【论文链接】https://arxiv.org/pdf/2303.13508.pdf

【项目链接】https://dreambooth3d.github.io/

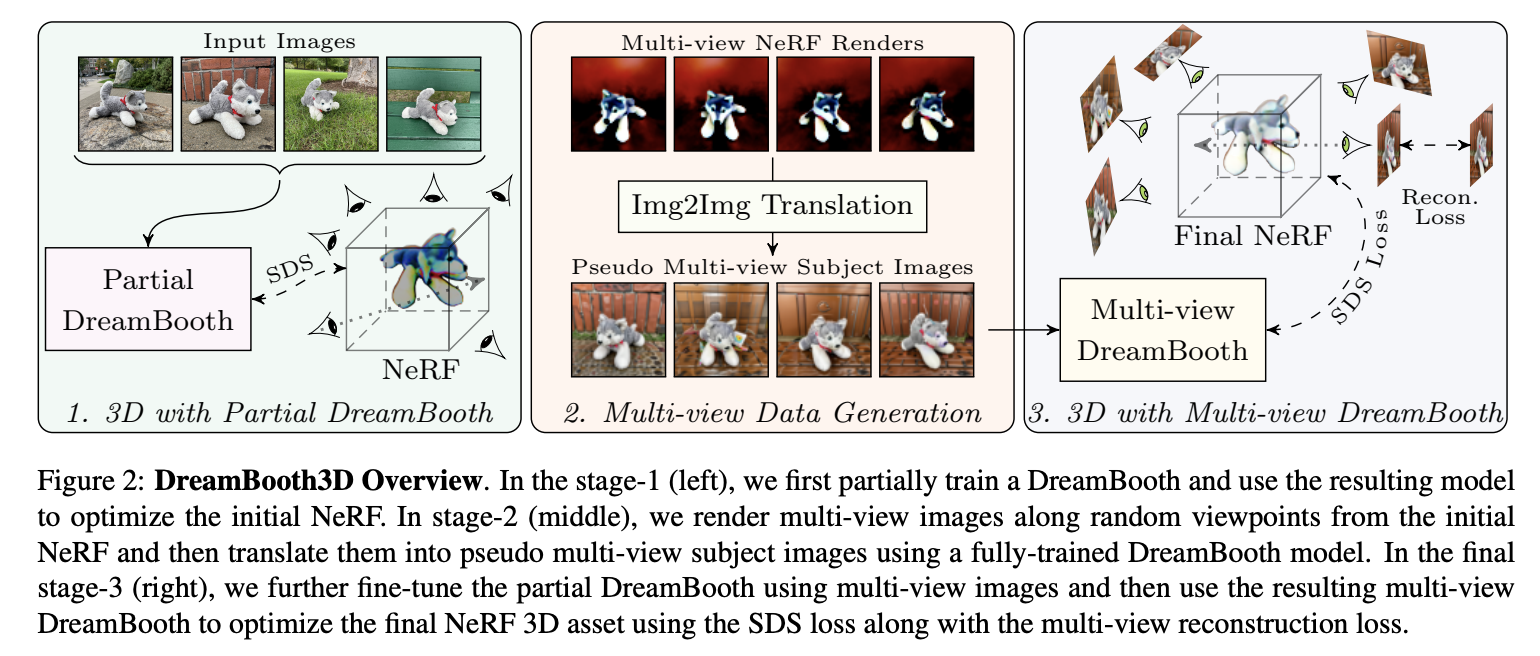

【摘要】本文提出了DreamBooth3D,这是一种从少至3-6张随手拍摄的主体图像中个性化文本到三维生成模型的方法。该方法结合了个性化文本-图像模型(DreamBooth)和文本-三维生成(DreamFusion)方面的最新进展。作者发现,由于个性化的文本-图像模型过度适应主体的输入视角,简单地结合这些方法无法产生令人满意的特定主体三维资产。本文通过3个阶段的优化策略克服了这一问题,共同利用了神经辐射场的三维一致性和文本-图像模型的个性化能力。该方法可以产生高质量的、针对特定对象的三维内容,并以文本驱动的方式进行修改,如新的姿势、颜色和属性。新的姿势、颜色和属性,这些都是在任何输入图像中都看不到的 的任何输入图像中都看不到的新颖姿势、颜色和属性。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง