【推荐理由】最近的文本到视频生成方法依赖于计算量大的训练,并且需要大规模的视频数据集。本文提出了一种低成本的方法(无需任何训练或优化),利用现有的文本到图像合成方法的力量。

Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video Generators

Levon Khachatryan, Andranik Movsisyan, Vahram Tadevosyan, Roberto Henschel, Zhangyang Wang Shant Navasardyan, Humphrey Shi

[Picsart AI Resarch (PAIR) & UT Austin & U of Oregon & UIUC]

【论文链接】https://arxiv.org/pdf/2303.13439.pdf

【项目链接】https://github.com/PicsartAI-Research/Text2Video-Zero.

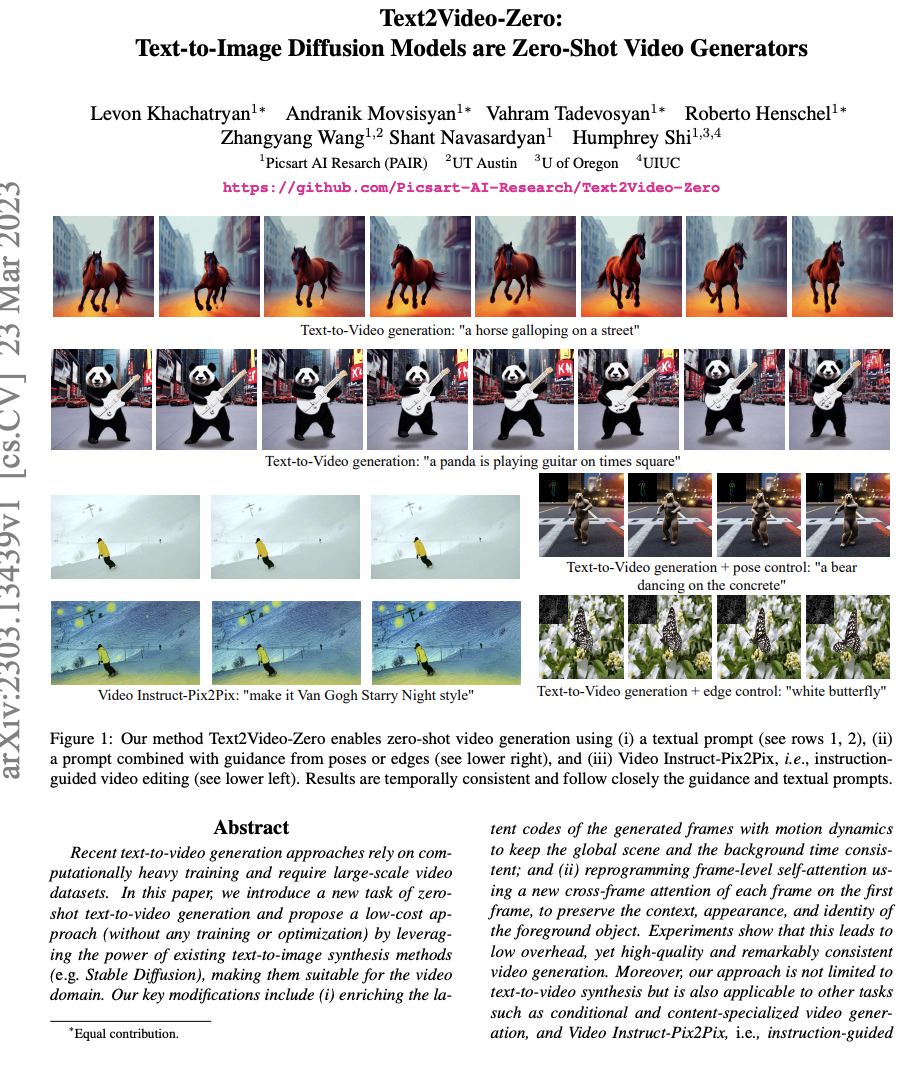

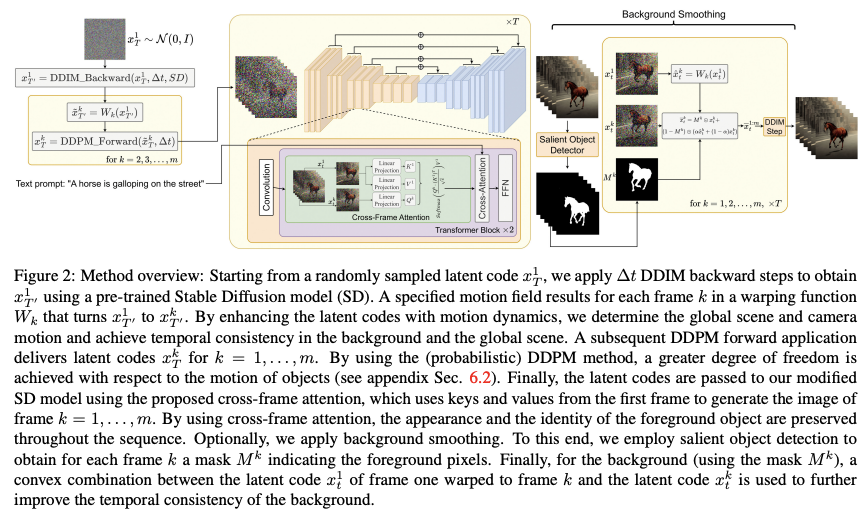

【摘要】最近的文本到视频生成方法依赖于计算量大的训练,并且需要大规模的视频数据集。 在本文中,作者介绍了零样本文本到视频生成的新任务,并通过利用现有文本到图像合成方法(例如稳定扩散)的强大功能提出了一种低成本方法(无需任何训练或优化) ), 使它们适用于视频领域。 本文的主要创新包括(i)用运动动力学丰富生成帧的潜在代码,以保持全局场景和背景时间一致; (ii) 使用第一帧上每个帧的新跨帧注意力重新编程帧级自注意力,以保留前景对象的上下文、外观和身份。 实验表明,这会导致低开销、高质量和非常一致的视频生成。 此外,该方法不仅限于文本到视频的合成,还适用于其他任务,例如条件和内容专用视频生成,以及 Video Instruct-Pix2Pix,即指令引导的视频编辑。 正如实验所示,该方法的性能与最近的方法相当,有时甚至更好,尽管没有接受额外视频数据的训练。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง