【推荐理由】本文引入了一种新的预训练视频模型 VideoTaskformer,它专注于表示教学视频的语义和结构。

Learning and Verification of Task Structure in Instructional Videos

Medhini Narasimhan, Licheng Yu, Sean Bell, Ning Zhang, Trevor Darrell

[UC Berkeley & Meta AI]

【论文链接】https://arxiv.org/pdf/2303.13519.pdf

【项目链接】https://medhini.github.io/task_structure/

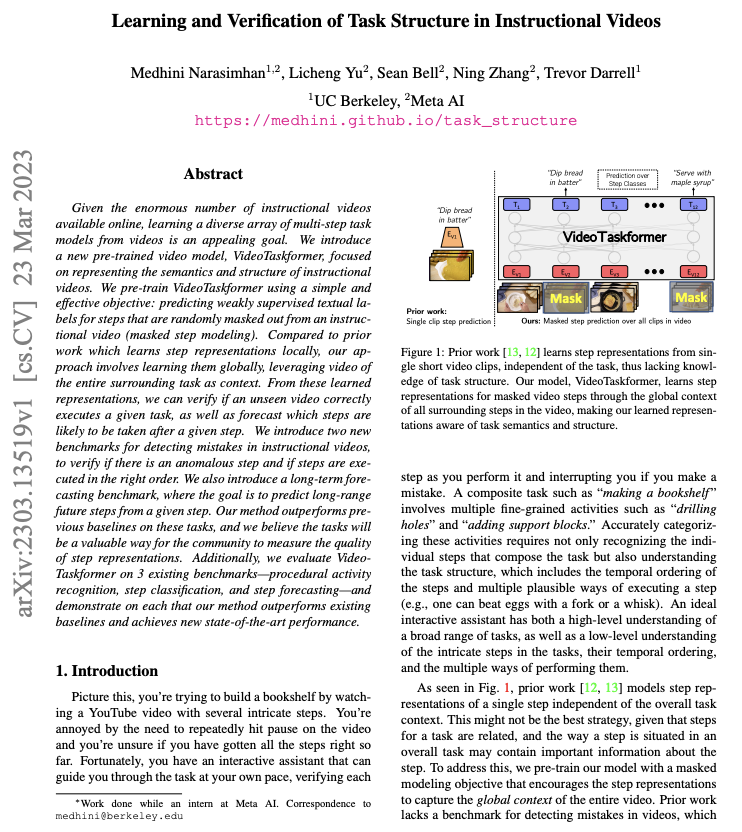

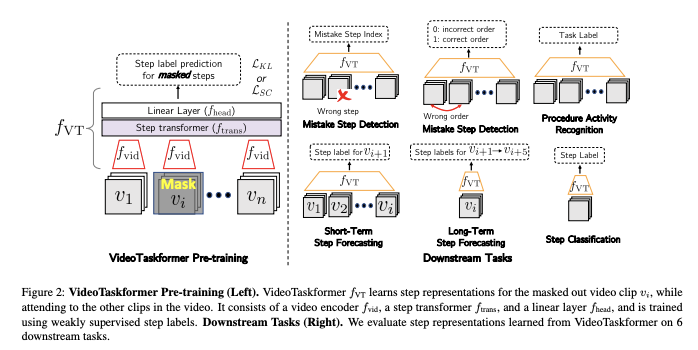

【摘要】鉴于在线提供的教学视频数量巨大,从视频中学习各种多步骤任务模型是一个有吸引力的目标。 本文引入了一种新的预训练视频模型 VideoTaskformer,它专注于表示教学视频的语义和结构。 作者使用简单有效的目标对 VideoTaskformer 进行预训练:预测从教学视频中随机屏蔽掉的步骤的弱监督文本标签(屏蔽步骤建模)。 与在本地学习步骤表示的先前工作相比,该方法涉及全局学习它们,利用整个周围任务的视频作为上下文。 从这些学习到的表示中,可以验证一个看不见的视频是否正确地执行了给定的任务,以及预测在给定的步骤之后可能采取哪些步骤。 作者引入了两个新的基准来检测教学视频中的错误,以验证是否存在异常步骤以及步骤是否以正确的顺序执行。 作者还引入了一个长期预测基准,其目标是预测给定步骤的长期未来步骤。 本文的方法在这些任务上优于以前的基线,我们相信这些任务将成为社区衡量步骤表示质量的一种有价值的方式。 此外,根据 3 个现有基准(程序活动识别、步骤分类和步骤预测)评估 VideoTaskformer,并在每个基准上证明本文的方法优于现有基线并实现了新的最先进的性能。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง