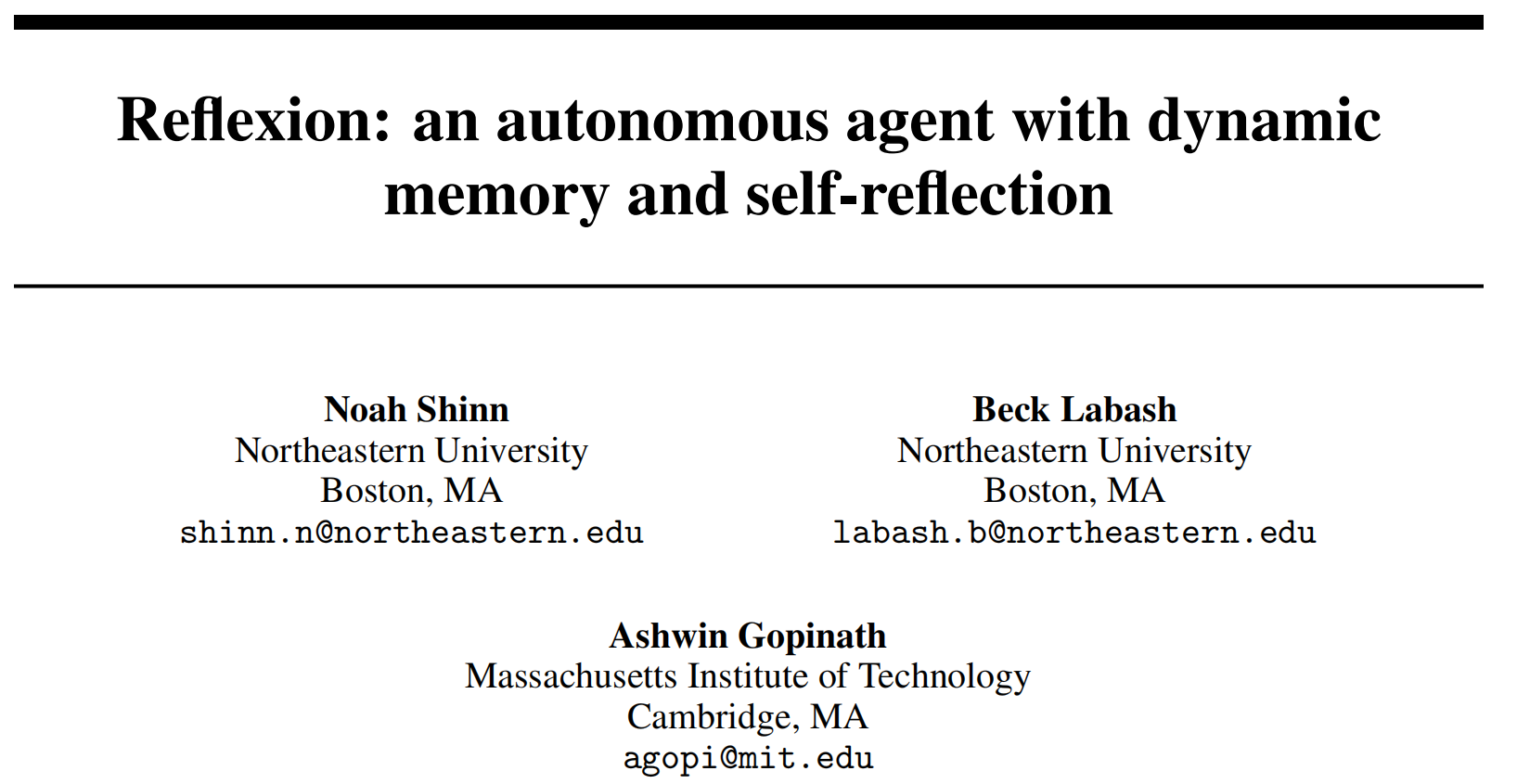

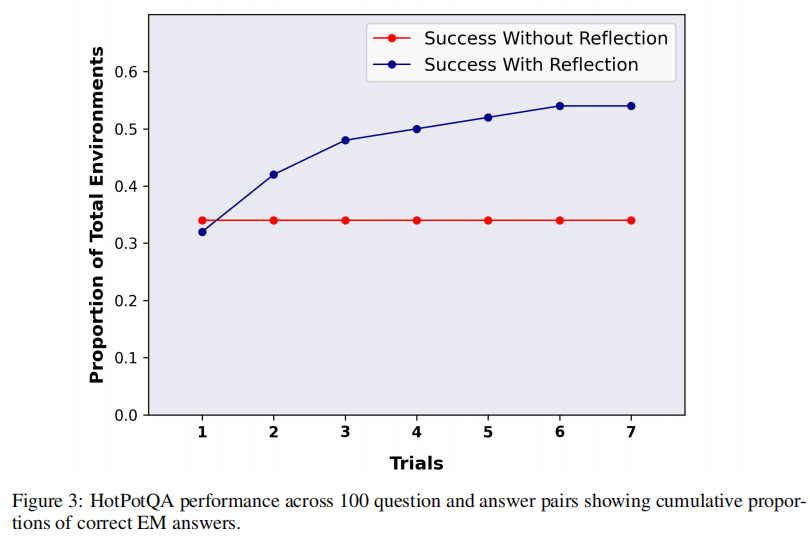

最近大语言模型(LLM)代理在决策方面取得了令人印象深刻的成绩,跨越了各种基准测试。然而,这些最先进的方法通常需要内部模型微调、外部模型微调或在定义的状态空间上进行策略优化。实施这些方法可能会因高质量的训练数据的稀缺性或缺乏明确定义的状态空间而变得具有挑战性。此外,这些代理不具备人类决策过程所固有的某些品质,特别是从错误中学习的能力。自我反思可以使人们通过试错的方式高效地解决新问题。在最近的研究基础上,本文提出了Reflexion。这种方法赋予代理动态记忆和自我反思能力,以增强其现有的推理轨迹和任务特定的行动选择能力。为了实现完全自动化,引入了一个简单而有效的启发式方法,使代理能够准确定位幻觉实例,避免在行动序列中重复,并在某些环境中构建给定环境的内部记忆映射。为了评估方法,作者评估了代理在AlfWorld环境中完成决策任务和在HotPotQA环境中完成知识密集型的基于搜索的问答任务的能力,观察到分别为97%和51%的成功率,并提供了有关自我反思的新兴属性的讨论。

标题:Reflexion: an autonomous agent with dynamic memory and self-reflection

作者:Noah Shinn, Beck Labash, Ashwin Gopinath

论文:https://arxiv.org/abs/2303.11366

代码:https://github.com/noahshinn024/reflexion

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง