【推荐理由】本文提出GestureDiffuCLIP,一个神经网络框架,用于合成具有灵活风格控制的逼真风格化共同语言手势。

GestureDiffuCLIP: Gesture Diffusion Model with CLIP Latents

TENGLONG AO, ZEYI ZHANG, LIBIN LIU

[Peking University & National Key Lab of Genaral AI]

【论文链接】https://arxiv.org/pdf/2303.14613.pdf

【Demo链接】https://www.youtube.com/watch?v=Psi1IOZGq8c

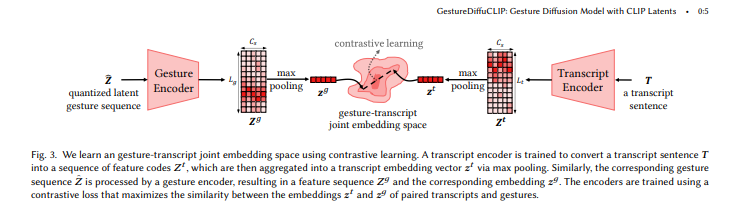

【摘要】最近,针对自动生成风格化共同语言手势的研究引起了越来越多的关注。先前的系统通常允许通过预定义的文本标签或示例动作片段进行风格控制,但这些方法通常不足以准确地传达用户的意图。本文提出GestureDiffuCLIP,一个神经网络框架,用于合成具有灵活风格控制的逼真风格化共同语言手势。我们利用大规模对比语言图像预训练(CLIP)模型的能力,并提出了一种新的CLIP引导机制,从多个输入模态中提取有效的风格表示,如文本片段、示例动作片段或视频。该系统学习了一个潜在扩散模型,以生成高质量的手势,并通过自适应实例归一化(AdaIN)层将CLIP风格表示注入到生成器中。作者还设计了手势-转录对齐机制,以确保基于对比学习的语义正确手势生成。本系统也可以扩展到允许对个体身体部位进行细粒度的风格控制。作者进行了广泛的示例,展示了该模型对各种风格描述的灵活性和普适性。在用户研究中,展示了该系统在人类相似度、适当性和风格正确性方面优于最先进的方法。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง