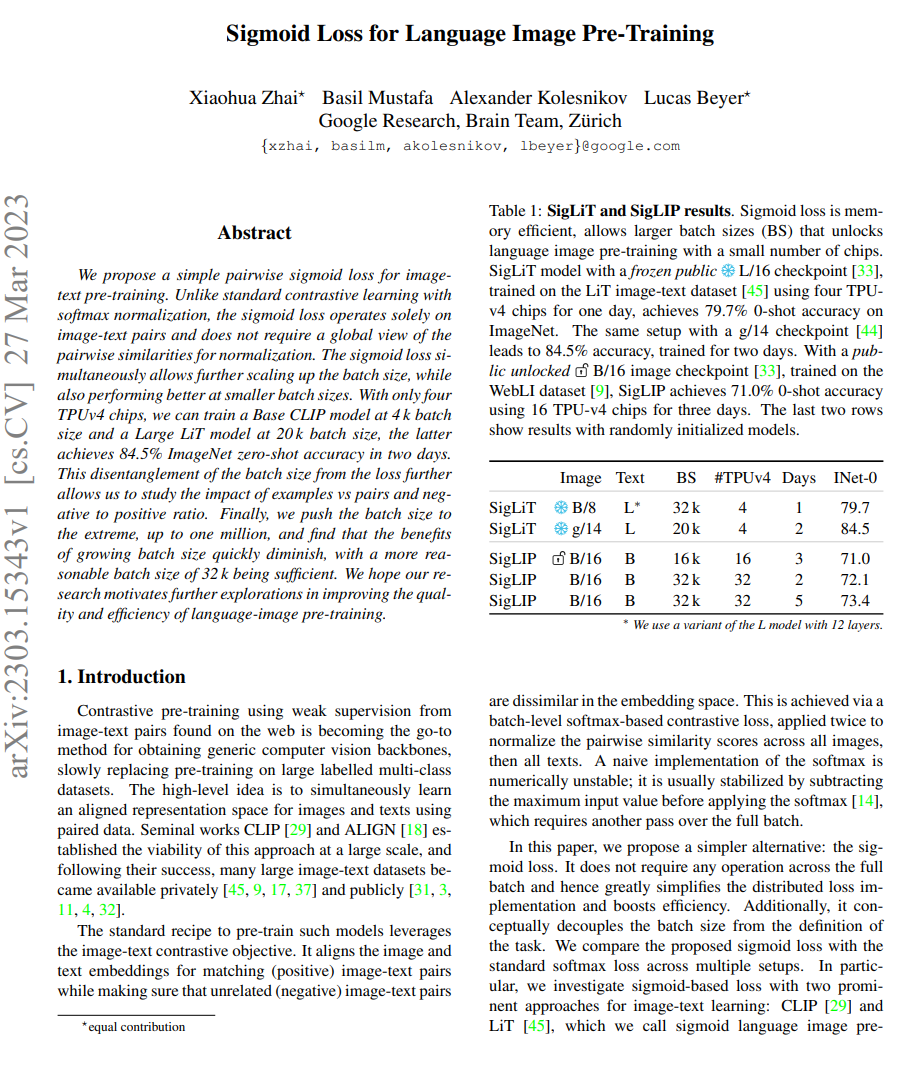

【推荐理由】本文提出了一种简单的成对sigmoid损失函数,用于图像-文本预训练。只需四个TPUv4芯片,就可以以4k批量大小训练一个基础CLIP模型。后者在两天内实现了84.5%的ImageNet zero-shot准确性。

Sigmoid Loss for Language Image Pre-Training

Xiaohua Zhai, Basil Mustafa, Alexander Kolesnikov, Lucas Beyer

[Google Research, Brain Team, Zurich]

【论文链接】https://arxiv.org/pdf/2303.15343.pdf

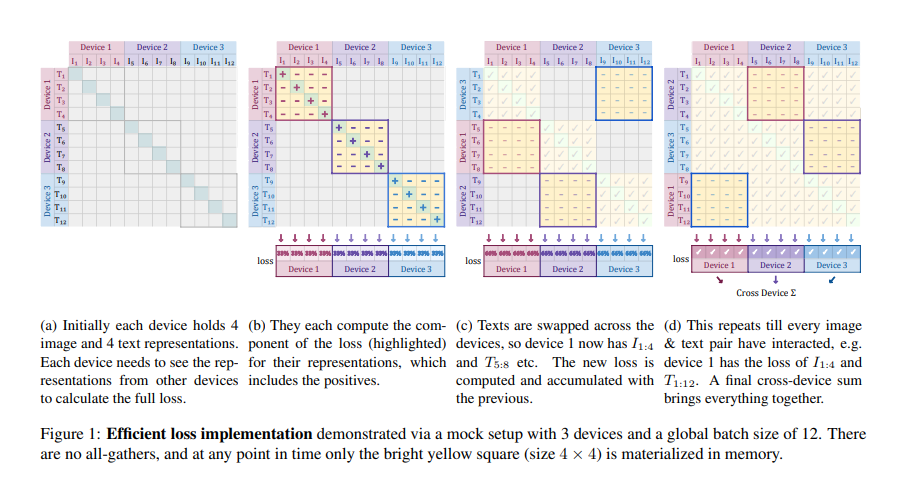

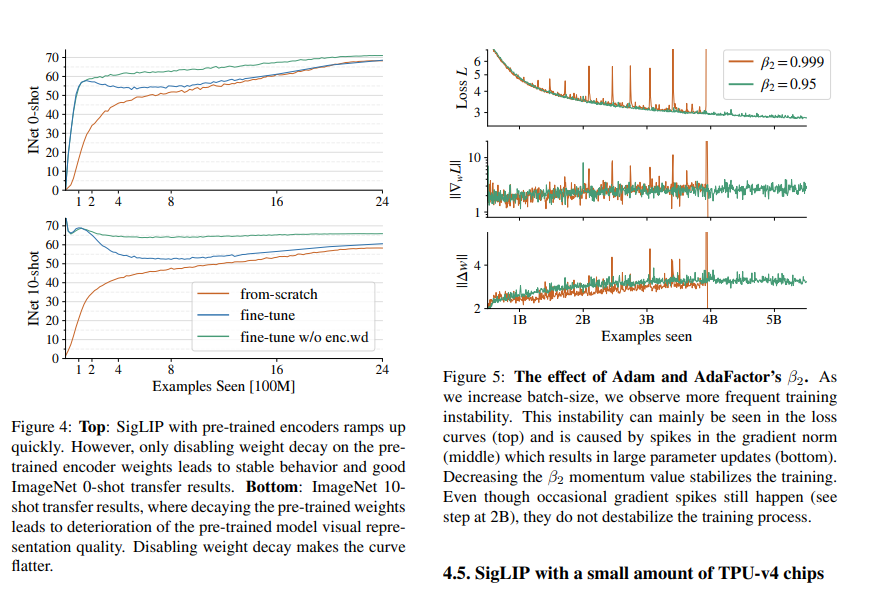

【摘要】本文提出了一种简单的成对sigmoid损失函数,用于图像文本预训练。与标准的具有softmax归一化的对比学习不同,sigmoid损失仅对图像文本对进行操作,并不需要全局查看配对相似性进行归一化。sigmoid损失可以同时允许进一步扩大批处理大小,并在较小的批处理大小下表现更好。只需四个TPUv4芯片,他们就可以在4k批处理大小下训练Base CLIP模型,在20k批处理大小下训练Large LiT模型,在两天内实现84.5%的ImageNet零射击准确性。这种批处理大小与损失的解耦进一步使我们能够研究示例与对和负到正比率的影响。最后,作者将批处理大小推到了极限,高达一百万,发现增加批处理大小的好处很快减少,32k的更合理批处理大小已足够。作者希望他们的研究能够激发进一步探索如何提高语言-图像预训练的质量和效率。

关于作者Xiaohua Zhai:

他是Google Brain的一名研究员。在此之前,他从北京大学获得了计算机科学博士学位,目前专注于深度学习和计算机视觉。他的谷歌学术引用量高达2万+,他也是Vision Transformer的作者。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง