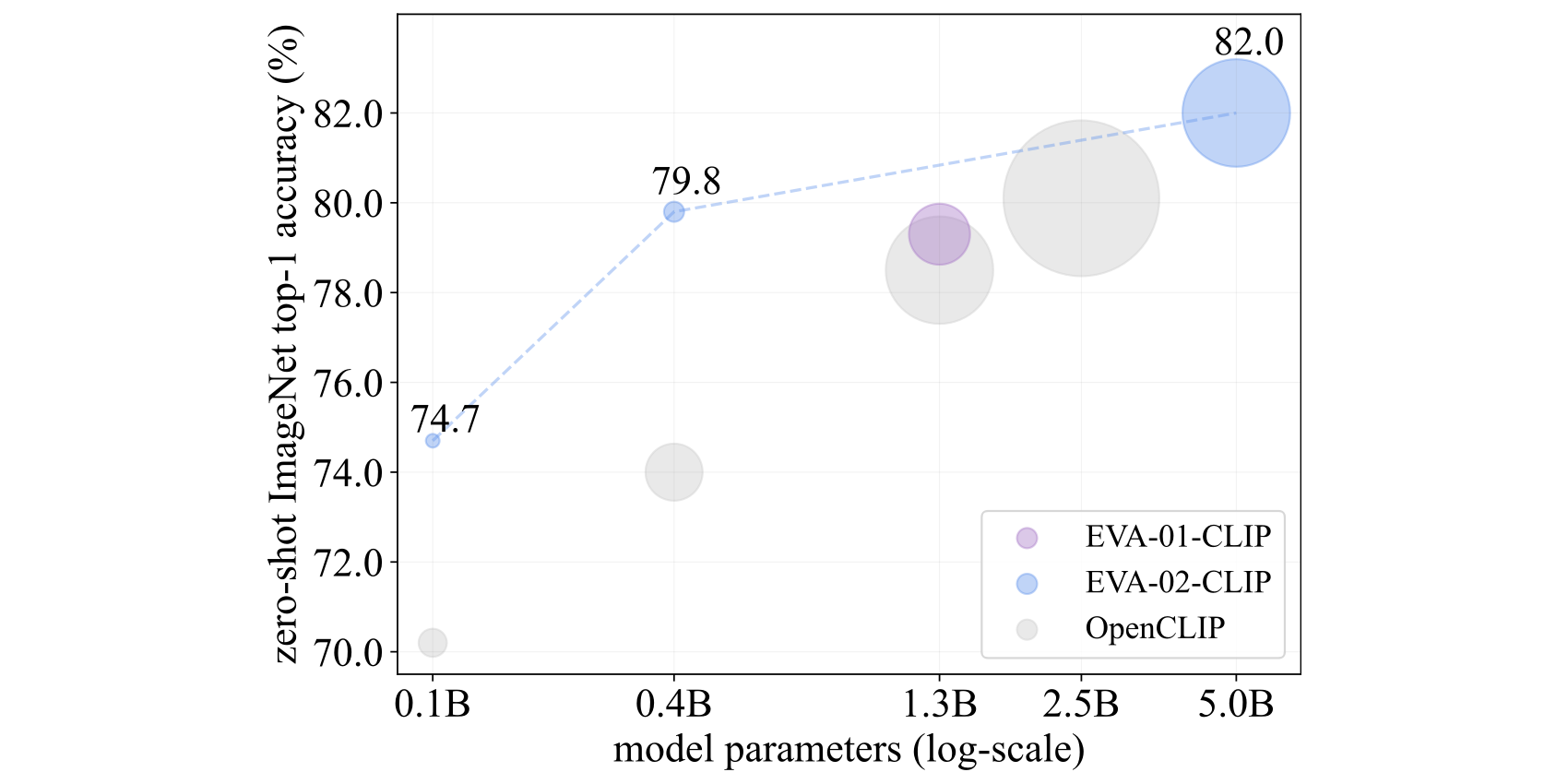

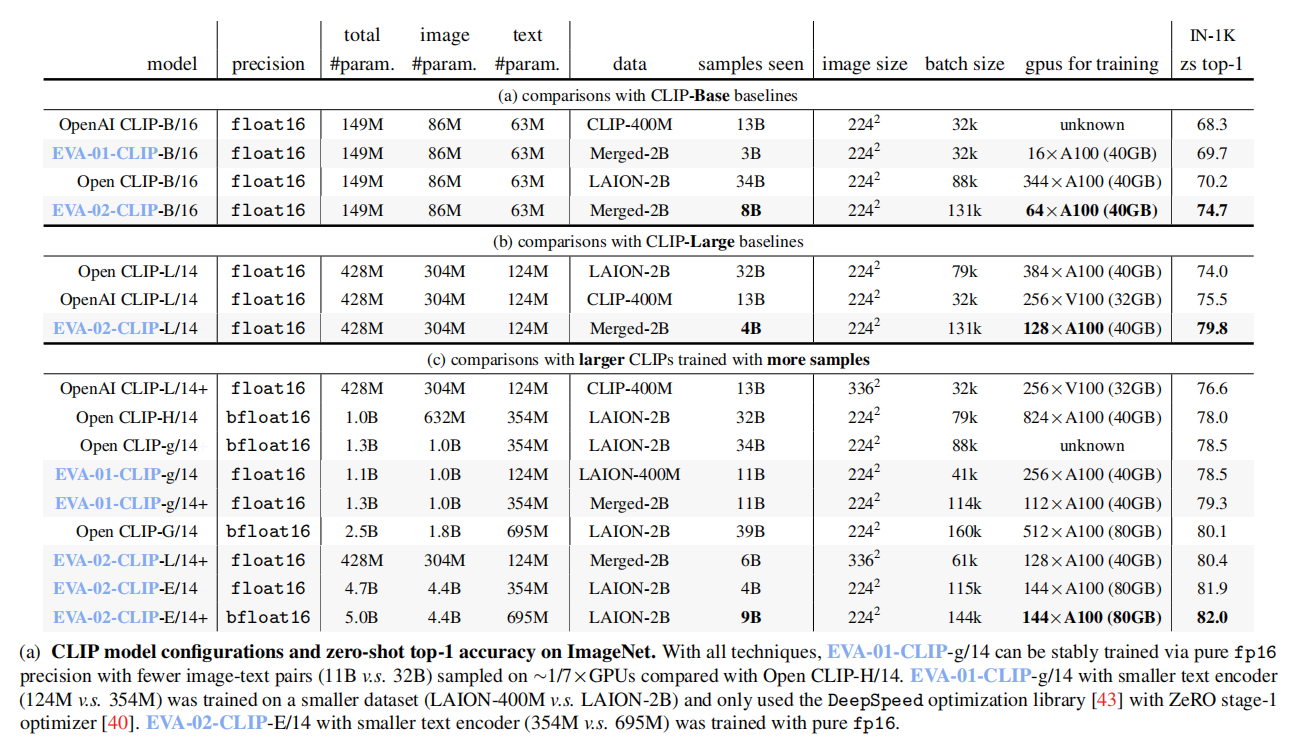

对比语言图像预训练(Contrastive language-image pre-training,简称CLIP)已经在各种场景中引起了越来越多的关注。在本文中,作者提出了EVA-CLIP,这是一系列显著提高CLIP训练效率和效果的模型。作者的方法结合了新的表示学习、优化和增强技术,使得EVA-CLIP相比于具有相同参数数量但训练成本显著较小的之前的CLIP模型具有更优异的性能。值得注意的是,作者最大的5.0B参数EVA-02-CLIP-E/14+,仅使用了90亿数据样本,就在ImageNet-1K的val数据集上达到了82.0的零样例一级准确率。较小的EVA-02-CLIP-L/14+仅使用了4.3亿参数和60亿数据样本,在ImageNet-1K val数据集上实现了80.4的零样例一级准确率。

标题:EVA-CLIP: Improved Training Techniques for CLIP at Scale

作者:Quan Sun, Yuxin Fang, Ledell Wu, Xinlong Wang, Yue Cao

论文:http://arxiv.org/abs/2303.15389

代码:https://github.com/baaivision/EVA/tree/master/EVA-CLIP

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง