【推荐理由】本文将基于stale diffsion的图像生成速度提高了高达 2 倍,并将内存消耗降低了高达 5.6 倍。

Token Merging for Fast Stable Diffusion

Daniel Bolya, Judy Hoffman

【Georgia Tech】

【论文链接】https://arxiv.org/pdf/2303.17604.pdf

【项目链接】https://github.com/dbolya/tomesd

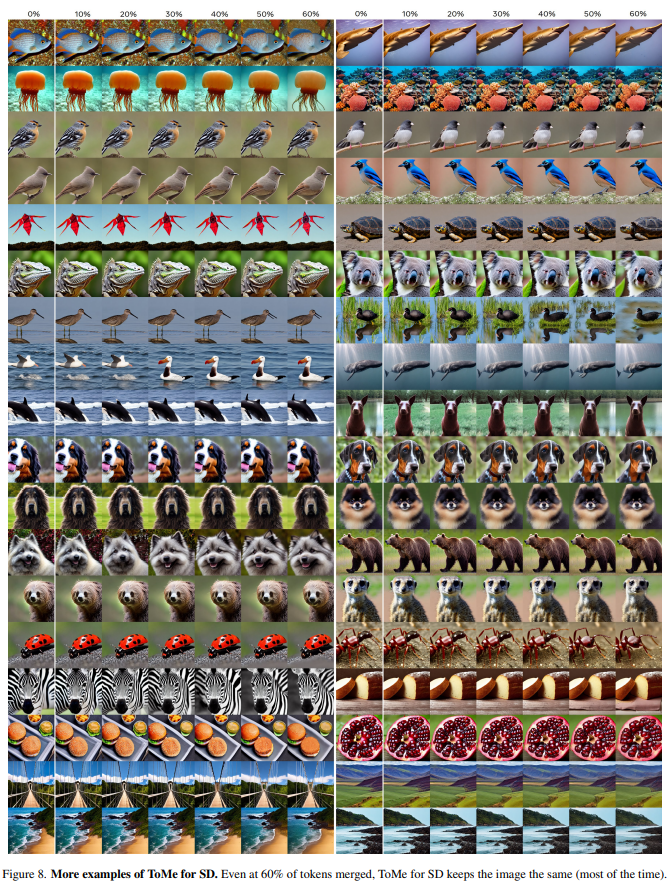

【摘要】开放词汇扩散模型改变了图像生成的景象。然而,这些模型的核心仍然是使用transformer,这使得生成速度较慢。出现了更好的实现方法以增加transformer的吞吐量,但它们仍然评估整个模型。在本文中,作者通过合并冗余令牌来利用生成图像中的自然冗余,从而加速扩散模型。在对 Token Merging(ToMe)进行一些扩散特定的改进后,文章的 ToMe for Stable Diffusion 可以将现有的 Stable Diffusion 模型中的令牌数量减少高达 60%,同时仍能产生高质量的图像,而无需进行任何额外的训练。在此过程中,作者将图像生成的速度提高了高达 2 倍,并将内存消耗降低了高达 5.6 倍。此外,这种加速与高效实现(如 xFormers)叠加,对于大型图像而言,其质量最小化的影响速度可以提高高达 5.4 倍。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง