【推荐理由】本文首次将大规模的文本到图像扩散模型用于零样本视频编辑领域,不需要对任何视频进行训练。

Zero-Shot Video Editing Using Off-The-Shelf Image Diffusion Models

Wen Wang, Kangyang Xie, Zide Liu, Hao Chen, Yue Cao, Xinlong Wang, Chunhua Shen

[Zhejiang University & Beijing Academy of Artificial Intelligence]

【论文链接】https://arxiv.org/pdf/2303.17599.pdf

【项目链接】https://github.com/baaivision/vid2vid-zero

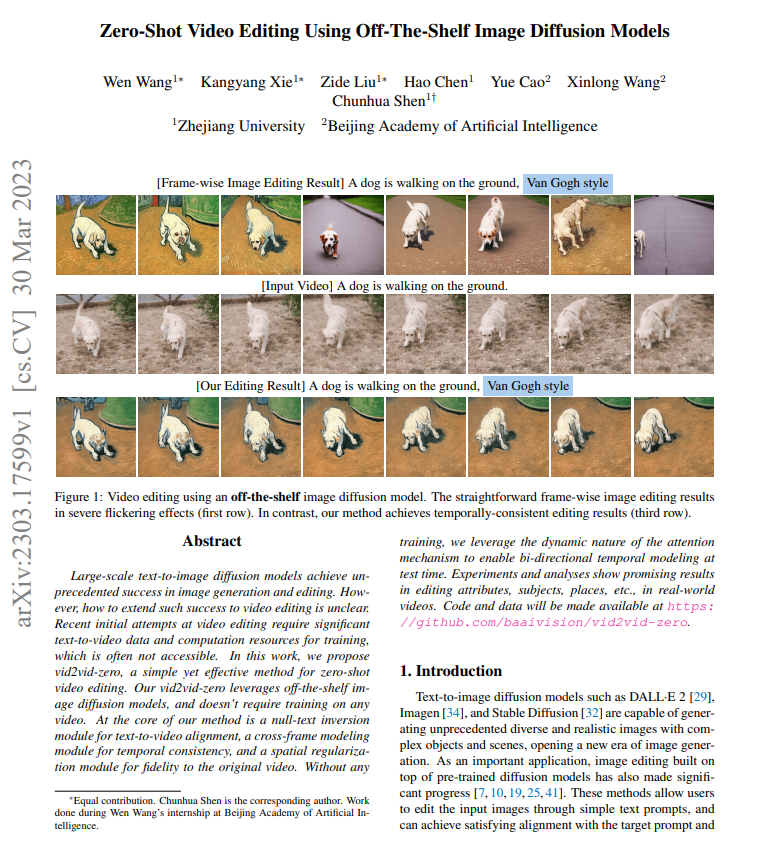

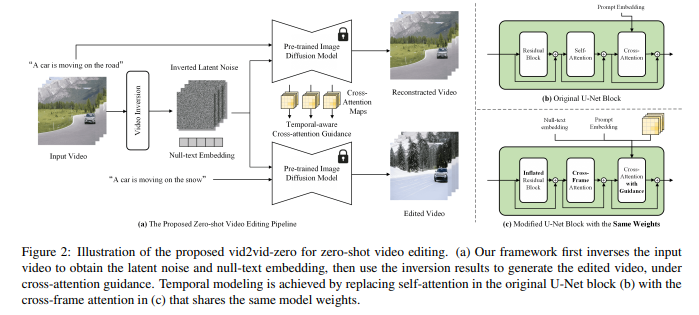

【摘要】大规模的文本到图像扩散模型在图像生成和编辑方面取得了前所未有的成功。然而,如何将这种成功扩展到视频编辑领域尚不清楚。最近的视频编辑初步尝试需要大量的文本到视频数据和计算资源进行训练,这通常是不可访问的。在这项工作中,作者提出了 vid2vid-zero,一种简单而有效的零样本视频编辑方法。 vid2vid-zero 利用现成的图像扩散模型,并且不需要对任何视频进行训练。该方法的核心是一个空文本反演模块,用于文本到视频对齐,一个跨帧建模模块,用于时态一致性,以及一个空间正则化模块,用于保持对原始视频的真实性。在没有任何训练的情况下,作者利用注意力机制的动态特性,在测试时实现双向时态建模。实验和分析显示,该方法在编辑属性、主题、地点等方面在现实世界的视频中展现了有希望的结果。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง