【推荐理由】本文构建了一个百万级合成数据集和数据生成代码库,允许生成额外的合适数据以提高视觉语言大模型的VLC理解和组合推理能力。

Going Beyond Nouns With Vision & Language Models Using Synthetic Data

Paola Cascante-Bonilla, Khaled Shehada, James Seale Smith, Sivan Doveh, Donghyun Kim, Rameswar Panda, Gül Varol, Aude Oliva, Vicente Ordonez, Rogerio Feris, Leonid Karlinsky

【Rice University & MIT】

【论文链接】https://arxiv.org/pdf/2303.17590.pdf

【项目链接】https://synthetic-vic.github.io/

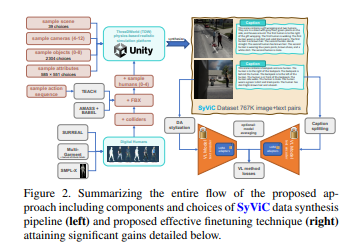

【摘要】大规模预训练的视觉语言(VL)模型在许多应用中表现出卓越的性能,使得可以用(几乎任意的)自然语言提示进行零样本开放词汇推理,取代了固定的支持类别集合。然而,最近的研究揭示了这些模型的一个根本性弱点。例如,它们难以理解超越名词的视觉语言概念(VLC),如非物体词语的含义(例如属性、动作、关系、状态等),或难以进行组合推理,如理解句子中单词顺序的重要性。在这项工作中,作者调查了纯合成数据能够在不损害零样本能力的情况下,教这些模型克服这些缺点的程度。文章提供了合成视觉概念(SyViC)-一个百万级合成数据集和数据生成代码库,允许生成额外的合适数据以提高VL模型的VLC理解和组合推理能力。此外,作者提出了一个通用的VL微调策略,以有效地利用SyViC实现这些改进。作者在VL-Checklist、Winoground和ARO基准测试上进行了广泛的实验和消融,证明可以用合成数据适应强大的预训练VL模型,显著提高它们的VLC理解能力(例如在ARO上提高了9.9%、在VLChecklist上提高了4.3%),而零样本准确度下降不到1%。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง