WavCaps: A ChatGPT-Assisted Weakly-Labelled Audio Captioning Dataset for Audio-Language Multimodal Research

Xinhao Mei, Chutong Meng, Haohe Liu, Qiuqiang Kong, Tom Ko, Chengqi Zhao, Mark D. Plumbley, Yuexian Zou, Wenwu Wang

[University of Surrey & Johns Hopkins University & ByteDance & Peking University]

- 近年来,音频语言(AL)多模态学习任务的进展非常显著。然而,由于现有的音频语言数据集的收集过程成本高,耗时长,规模有限,研究人员面临着挑战。

- 为了解决这个数据匮乏的问题,我们引入了WavCaps,这是第一个大规模的弱标签音频字幕数据集,包括大约40万个带有配对字幕的音频片段。我们从网络资源和声音事件检测数据集中获取了音频片段和它们的原始描述。

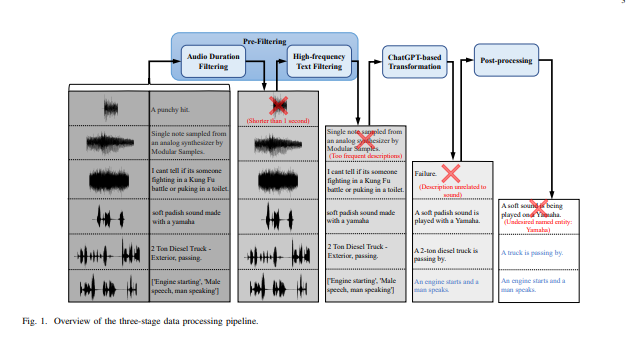

- 然而,从网上收集的原始描述是高度嘈杂的,不适合直接用于自动音频字幕等任务。为了克服这个问题,我们提出了一个过滤噪声数据和生成高质量字幕的三阶段处理管道,其中ChatGPT,一个大型语言模型,被用来自动过滤和转换原始描述。

- 我们对WavCaps数据集的特点进行了全面分析,并在多个下游的音频语言多模态学习任务中进行了评估。在WavCaps上训练的系统比以前最先进的(SOTA)模型要好得多。我们希望我们提出的WavCaps数据集能够促进音频语言多模态学习的研究,并证明利用ChatGPT来提高学术研究的潜力。

代码地址:https://github.com/XinhaoMei/WavCaps

https://arxiv.org/pdf/2303.17395.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง