【推荐理由】大多数传统技术只能在有限的摄像机运动范围内合成新视角,而本文提出一个姿态引导的扩散模型,能够从单个图像生成一致的长期新视角视频。

Consistent View Synthesis with Pose-Guided Diffusion Models

Hung-Yu Tseng, Qinbo Li, Changil Kim, Suhib Alsisan, Jia-Bin Huang, Johannes Kopf

【论文链接】https://arxiv.org/pdf/2303.17598.pdf

【项目链接】https://poseguided-diffusion.github.io/

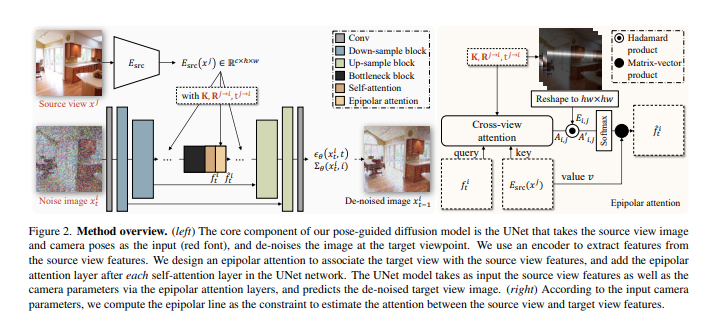

【摘要】从单个图像合成新视角是许多虚拟现实应用程序中提供沉浸式体验的基础问题。然而,大多数现有技术只能在有限的摄像机运动范围内合成新视角,或者在摄像机运动明显时无法生成一致且高质量的新视角。在本文中,作者提出了一个姿态引导的扩散模型,用于从单个图像生成一致的长期新视角视频。作者设计了一个注意力层,利用极线作为约束来促进不同视点之间的关联。对合成和真实世界数据集的实验结果表明,所提出的扩散模型相对于现有的基于Transformer和基于GAN的方法具有更好的效果。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง