【推荐理由】传统认为通过少量提示就能在复杂推理方面表现出色的惊人能力被认为仅出现在非常大规模的模型(100+亿个参数)中,而本文 针对多步推理进行小型语言模型的专门化,也可以达到强大的建模能力。本研究可以作为LLM设定的新研究范式中专门化较小模型的重要尝试。

Specializing Smaller Language Models towards Multi-Step Reasoning

Yao Fu, Hao Peng, Litu Ou, Ashish Sabharwal, Tushar Khot

[University of Edinburgh & Allen Institute for AI]

【论文链接】https://arxiv.org/pdf/2301.12726.pdf

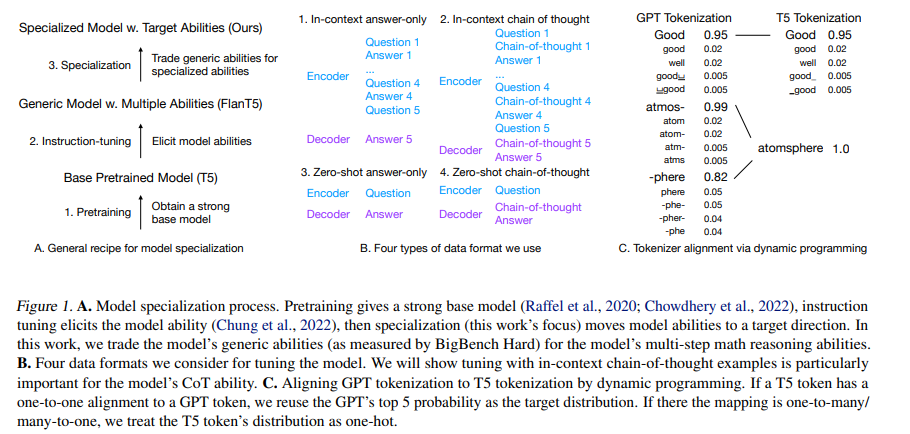

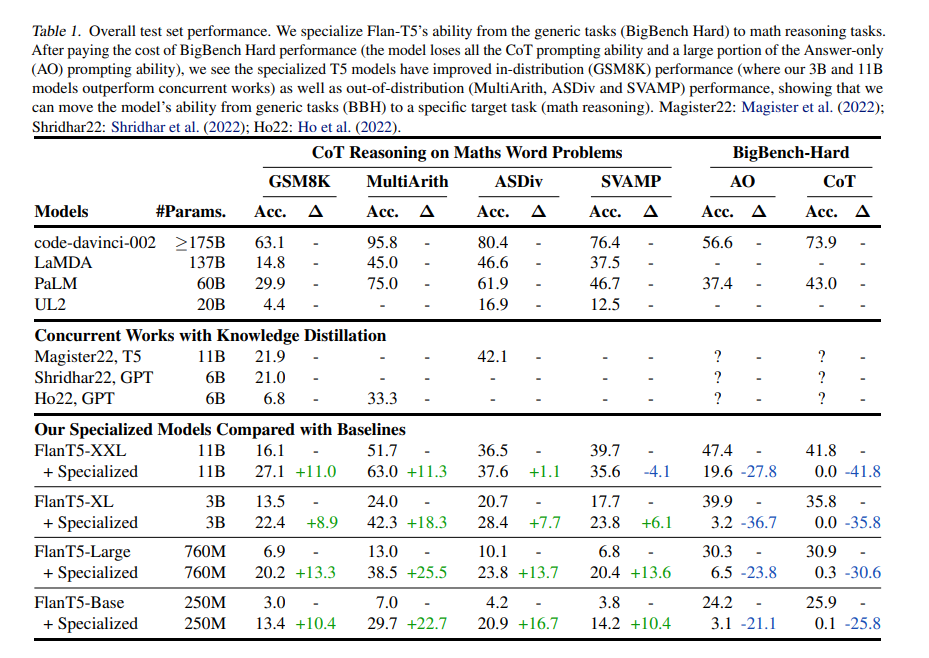

【摘要】大型语言模型(LLM)仅通过少量链式思考提示就能在复杂推理方面表现出色的惊人能力被认为仅出现在非常大规模的模型(100+亿个参数)中。文章展示了这样的能力实际上可以从GPT3.5(≥175B)精简到T5变体(≤11B)。作者提出了模型专业化,以专门针对目标任务专门化模型能力。假设大模型(通常被认为比100B大)具有强大的建模能力,但分散在大量任务的广泛领域中。小模型(通常被认为小于10B)具有有限的模型容量,但如果将它们的能力集中在特定的目标任务上,模型就可以实现相当不错的提高性能。文章以多步数学推理为测试平台,因为它是一个非常典型的新兴能力。作者展示了模型能力的两个重要方面:(1)语言模型的多维能力之间存在非常复杂的平衡/权衡;(2)通过付出减少通用能力的代价,可以明显提升小于10B的模型朝着专门化的多步数学推理能力的缩放曲线。文章进一步讨论了更好的泛化的重要设计选择,包括调整数据格式、起始模型检查点和新的模型选择方法。该实践和发现可以作为LLM设定的新研究范式中专门化较小模型的重要尝试。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง