大型语言模型是使用深度学习和自然语言处理技术训练获得的神经网络。这些模型通常基于大量文本数据进行训练,需要大量计算资源、时间和数据。最著名的大型语言模型之一是 GPT-3,可以用于多种自然语言任务,如自动摘要、机器翻译和文本分类,还可以用于生成文本。但是,这些模型仍面临多样本文介绍了大型语言模型的八个要点:

-

大型语言模型是指使用深度学习和自然语言处理技术训练得到的庞大神经网络,可用于完成多种自然语言任务,如语言生成和阅读理解。

-

大型语言模型通常基于先前的语言语料库进行训练,这些语料库可能包含来自网站、书籍和其他文本来源的大量文本数据。

-

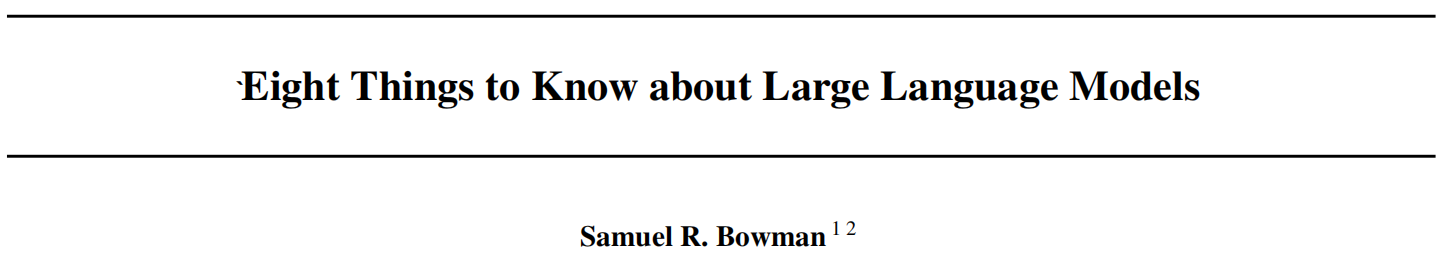

训练大型语言模型需要大量的计算资源、时间和数据。这些模型通常在拥有数千个甚至数百万个计算核心的超级计算机上进行训练。

-

最著名的大型语言模型之一是 GPT-3,它由 OpenAI 开发。GPT-3 包含了 1750 亿个参数,是迄今为止最大的语言模型之一。

-

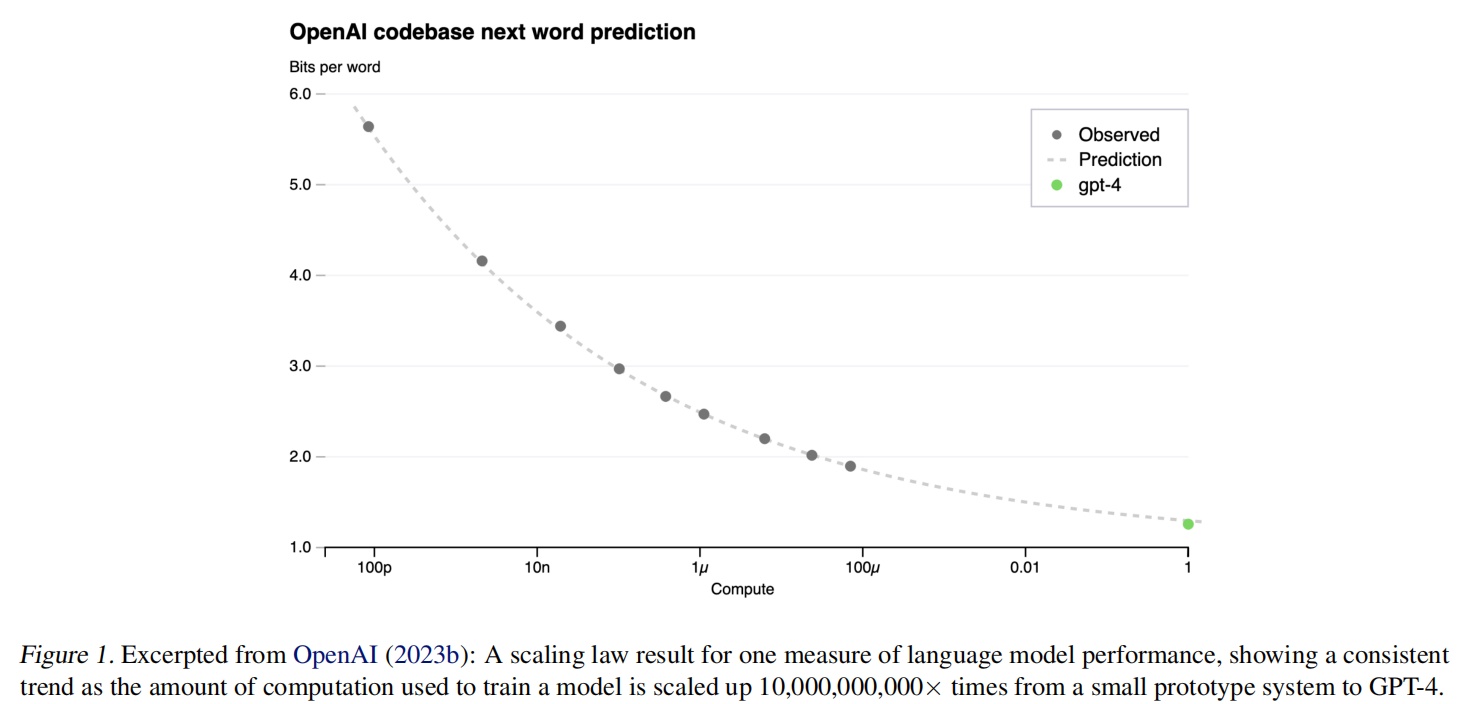

大型语言模型可以用于各种任务,例如自动摘要、机器翻译、文本分类和问题回答。这些模型还可以用于生成文本,如自然语言对话系统和新闻报道。

-

尽管大型语言模型的表现已经相当好,但它们仍然存在挑战和限制,例如对多样性和准确性的平衡。

-

大型语言模型也引发了一些关于隐私和安全的担忧,因为它们可能会被用于制作虚假信息或进行针对性的网络攻击。

-

大型语言模型的发展仍处于初级阶段,随着技术的不断发展,我们可能会看到更先进的模型产生,这些模型将进一步推动自然语言处理的发展。

论文:Eight things to know about large language models

作者:Samuel R. Bowman 是纽约大学语言学和数据科学教授,同时也是计算语言学领域的著名研究者。他的研究主要集中在自然语言处理、深度学习和语言模型等领域。

除了在学术界的贡献之外,Bowman 也是大型开源自然语言处理库 AllenNLP 的创始人之一。这个库是一个可扩展、灵活的工具箱,可以用于构建和训练自然语言处理模型。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง