【推荐理由】本文总结了当前视觉语言大模型用于视觉任务的一系列方法。

Vision-Language Models for Vision Tasks: A Survey

Jingyi Zhang, Jiaxing Huang, Sheng Jin and Shijian Lu

【论文链接】https://arxiv.org/pdf/2304.00685.pdf

【项目链接】https://github.com/jingyi0000/VLM_survey

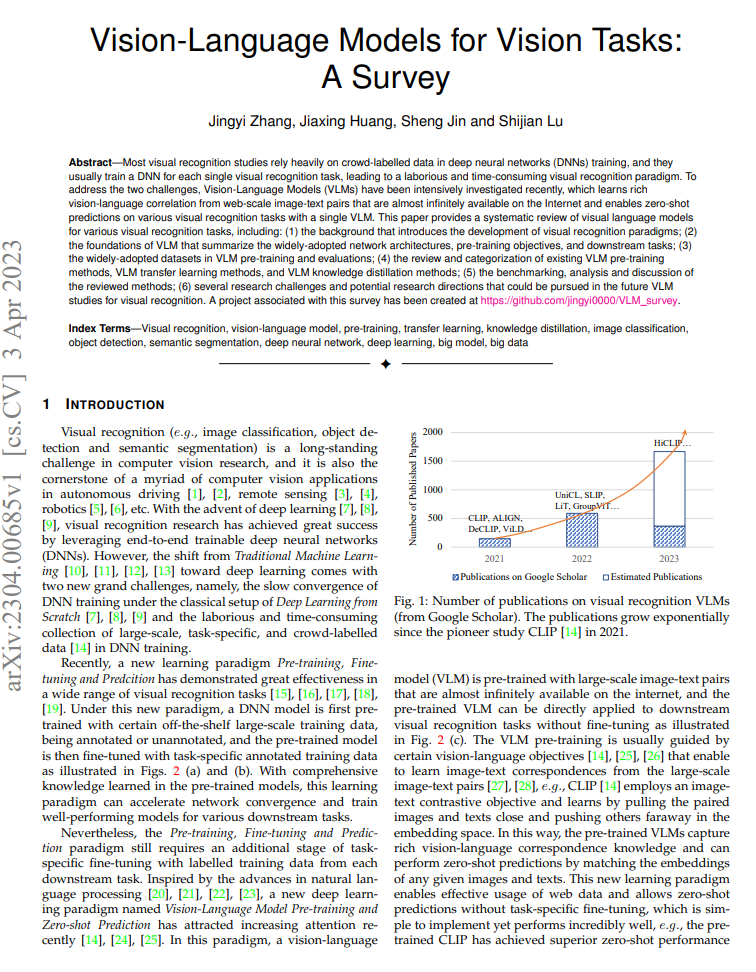

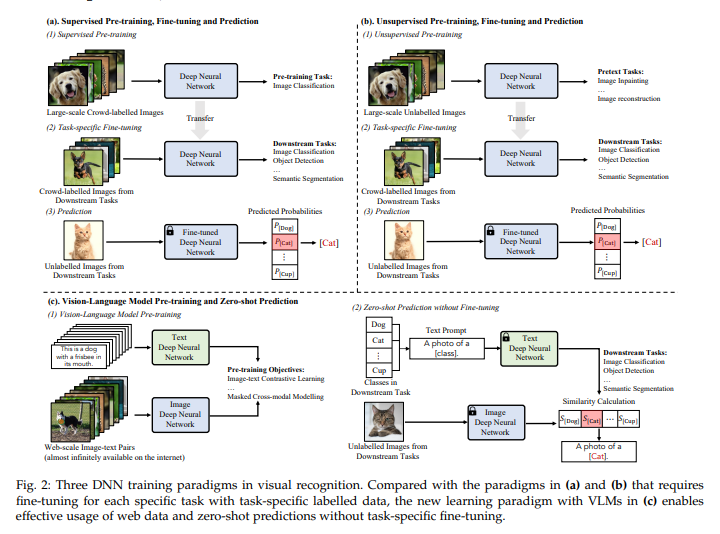

【摘要】大多数视觉识别研究在深度神经网络(DNN)训练中严重依赖于众包标注的数据,并且通常为每个单一的视觉识别任务训练一个DNN,这导致了一种费时费力的视觉识别范式。为了解决这两个挑战,最近密集研究了视觉语言模型(VLM),它从互联网上几乎无穷无尽的图像-文本对中学习丰富的视觉语言相关性,并能够通过一个单独的VLM进行各种视觉识别任务的零样本预测。本文系统地回顾了各种视觉识别任务的视觉语言模型,包括:(1)介绍视觉识别范式的发展背景;(2)总结广泛采用的网络架构、预训练目标和下游任务的VLM基础;(3)VLM预训练和评估中广泛采用的数据集;(4)现有的VLM预训练方法、VLM迁移学习方法和VLM知识蒸馏方法的回顾和分类;(5)对回顾方法进行基准测试、分析和讨论;(6)未来VLM研究中可能追求的几个研究挑战和潜在研究方向。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง