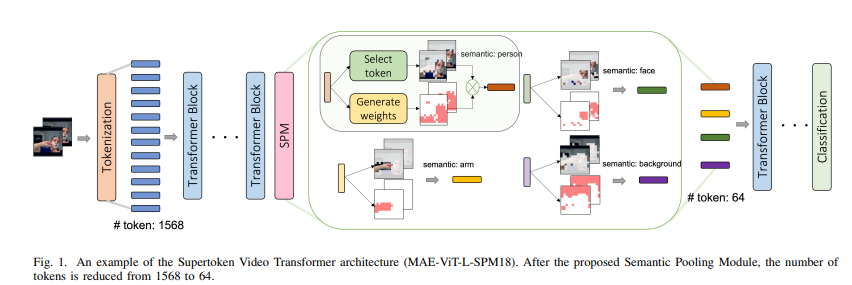

【推荐理由】文章提出了一个 Supertoken Video Transformer大模型结构用于视频理解,提高了MAE预训练的ViT-B和ViT-L的准确性,同时需要更少的计算。

SVT: Supertoken Video Transformer for Efficient Video Understanding

Chenbin Pan, Rui Hou, Hanchao Yu, Qifan Wang, Senem Velipasalar, Madian Khabsa

[Syracuse University & Meta AI]

【论文链接】https://arxiv.org/pdf/2304.00325.pdf

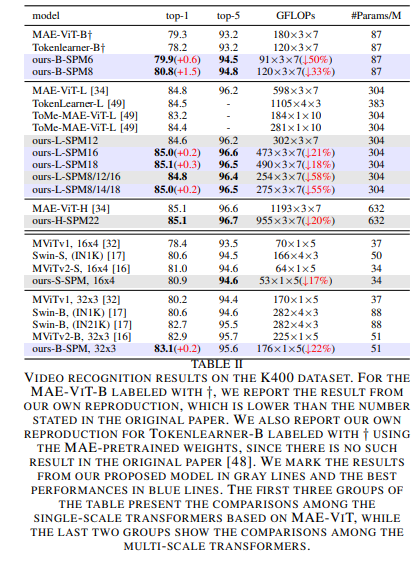

【摘要】现有的视频转换器通过从开始到结束处理具有固定分辨率的视频或将池化和降采样策略纳入其中,通过整个网络处理整个视频内容而没有特别处理大量冗余信息。在本文中,作者提出了一个超级令牌视频转换器(SVT),它包括一个语义池化模块(SPM),以根据它们的语义沿着视觉变换器的深度聚合潜在表示,从而减少视频输入中固有的冗余。定性结果表明,该方法可以通过合并具有相似语义的潜在表示来有效减少冗余,并因此增加下游任务的显著信息比例。定量上,该方法在Kinectics和SomethingSomething-V2基准测试中显著减少计算量的同时,提高了ViT和MViT的性能。具体而言,通过SPM,在Kinectics-400基准测试中,作者将MAE预训练的ViT-B和ViT-L的准确性分别提高了1.5%和0.2%,同时GFLOPs减少了33%和55%,在Kinectics-400和Something-Something-V2上,作者将MViTv2-B的准确性分别提高了0.2%和0.3%,同时GFLOPs减少了22%。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง