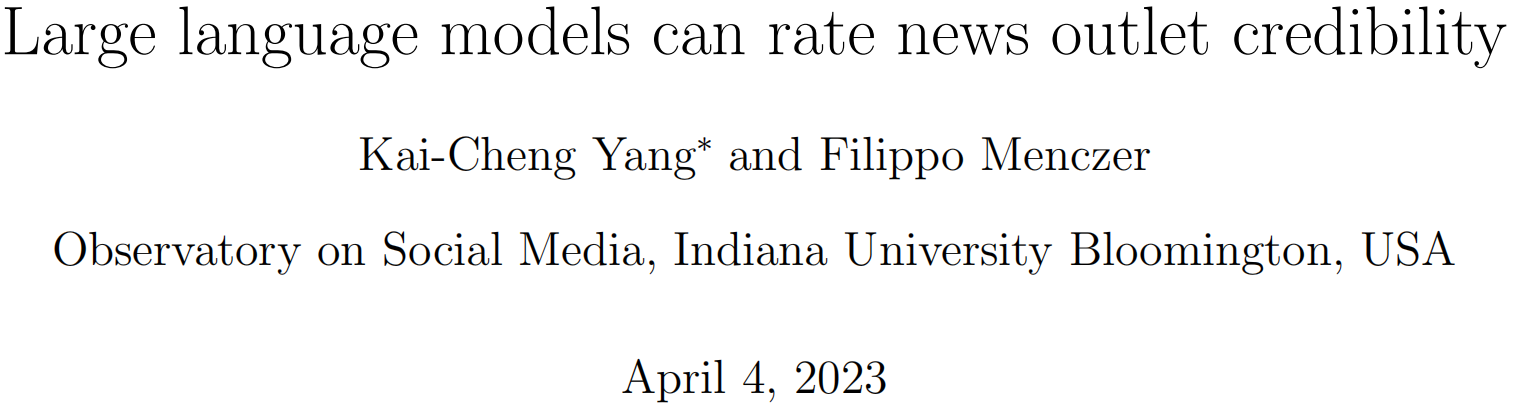

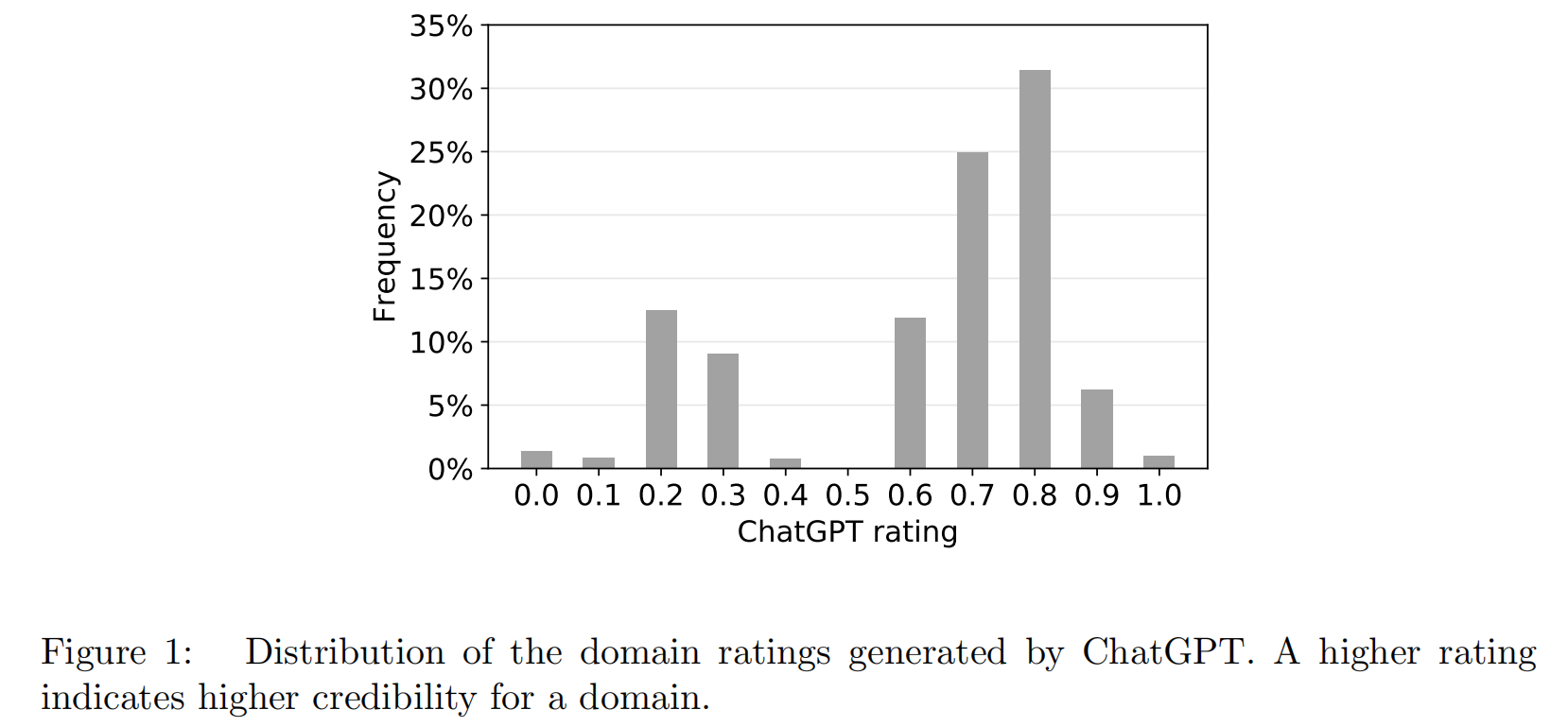

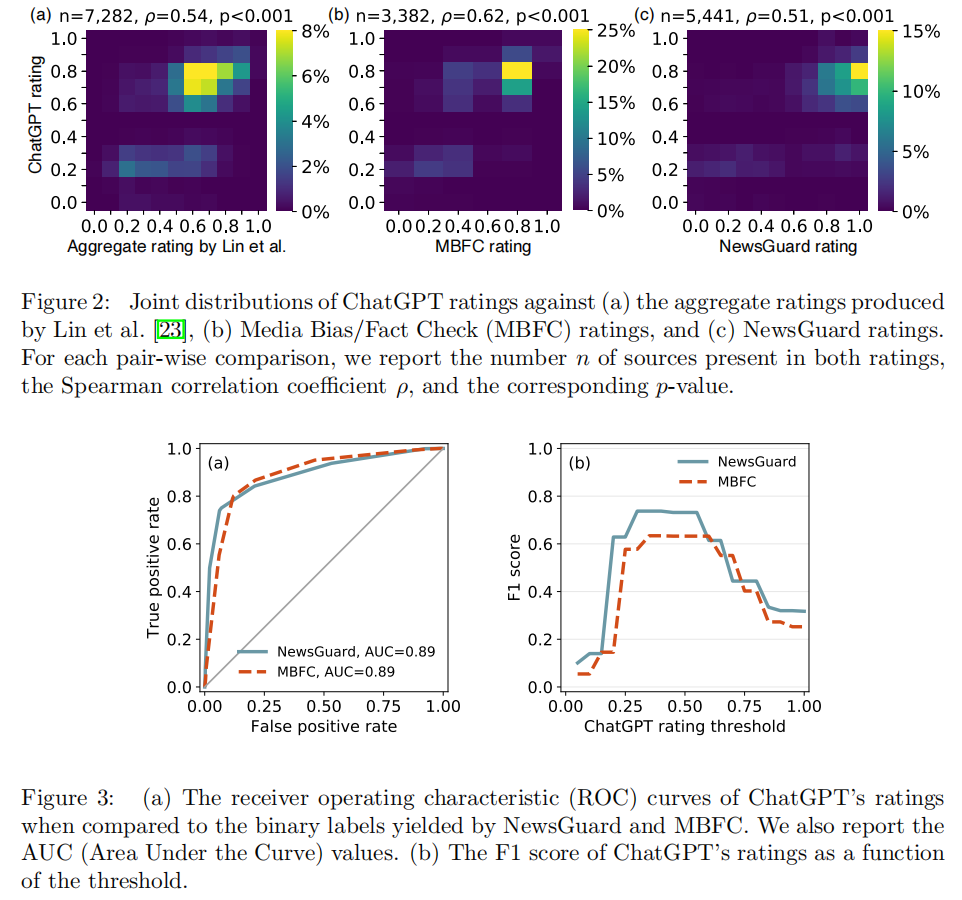

尽管大型语言模型(LLM)在各种自然语言处理任务中表现出了出色的性能,但它们容易出现幻觉。最新的聊天机器人(如新版必应)试图通过直接从互联网收集信息来解决这个问题,以确定它们的答案。在这种环境下,区分可信的来源对于向用户提供恰当的准确性上下文是至关重要的。这里我们评估了著名的LLM ChatGPT是否能够评估新闻媒体的可信度。通过适当的说明,ChatGPT可以为多种新闻媒体提供评级,包括非英语语言和讽刺性来源,并提供上下文解释。我们的结果表明,这些评级与人类专家的评级相关(Spearmam’s $rho=0.54, p<0.001$)。这些发现表明,LLM可以是事实核查应用程序中可信度评分的经济参考。未来的LLM应增强其与人类专家判断来源可信度的一致性,以提高信息准确性。

总结:

大型语言模型可以评估新闻媒体的可信度。研究发现,通过适当的说明,ChatGPT可以为多种新闻媒体提供评级,并提供上下文解释。这些评级与人类专家评级相关,表明LLM可以成为事实核查应用程序中可信度评分的经济参考。未来,LLM需要提高与人类专家判断来源可信度的一致性,以提高信息准确性。

标题:Large language models can rate news outlet credibility

作者:Kai-Cheng Yang, Filippo Menczer

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง