微软亚洲研究院和浙江大学的研究团队近日发布的一篇论文——《HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in HuggingFace》介绍了一个大模型协作系统。

论文地址:https://arxiv.org/abs/2303.17580

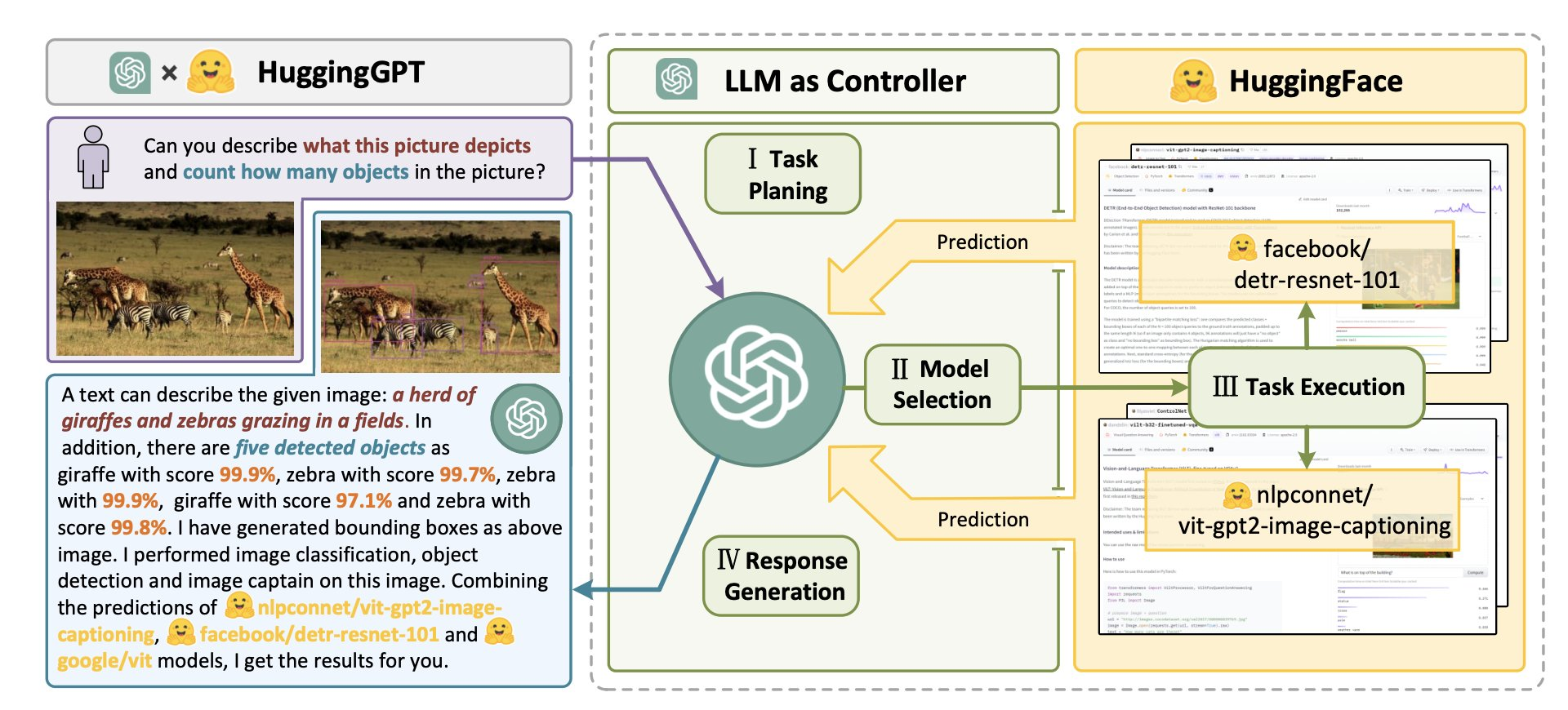

该系统提出了一种让 LLM 充当控制器的新方法,让 LLM 来管理现有的 AI 模型,来完成多模态的复杂 AI 任务,并且使用语言作为通用接口。该研究提出的 HuggingGPT 是一个利用 LLM 连接机器学习社区(例如 HuggingFace)中各种 AI 模型以解决复杂 AI 任务的系统。

研究者指出解决大型语言模型 (LLM) 当前的问题可能是迈向 AGI(通用人工智能)的第一步,也是关键的一步。

因为当前大型语言模型的技术仍然存在着一些缺陷,因此在构建 AGI 系统的道路上面临着一些紧迫的挑战。

- 受限于文本生成的输入和输出形式,当前 LLM 缺乏处理复杂信息(如视觉和语音)的能力

- 在实际应用场景中,一些复杂任务通常由多个子任务组成,因此需要多个模型的调度和协作,这也超出了语言模型的能力范围

- 对于一些具有挑战性的任务,LLM 在零样本或少样本设置下表现出优异的结果,但它们仍然比一些专家弱(如微调模型)

为了处理复杂的人工智能任务,LLM 应该能够与外部模型协调,以利用它们的能力。因此,关键点在于如何选择合适的中间件来桥接 LLM 和 AI 模型。

研究者发现,每个 AI 模型都可以通过总结其模型功能表示为一种语言形式。由此便引入了一个概念:「语言是 LLM 连接 AI 模型的通用接口」。通过将 AI 模型描述纳入提示中,ChatGPT 可以被视为管理人工智能模型的大脑。因此,这一方法可以让 ChatGPT 能够调用外部模型,来解决实际任务。

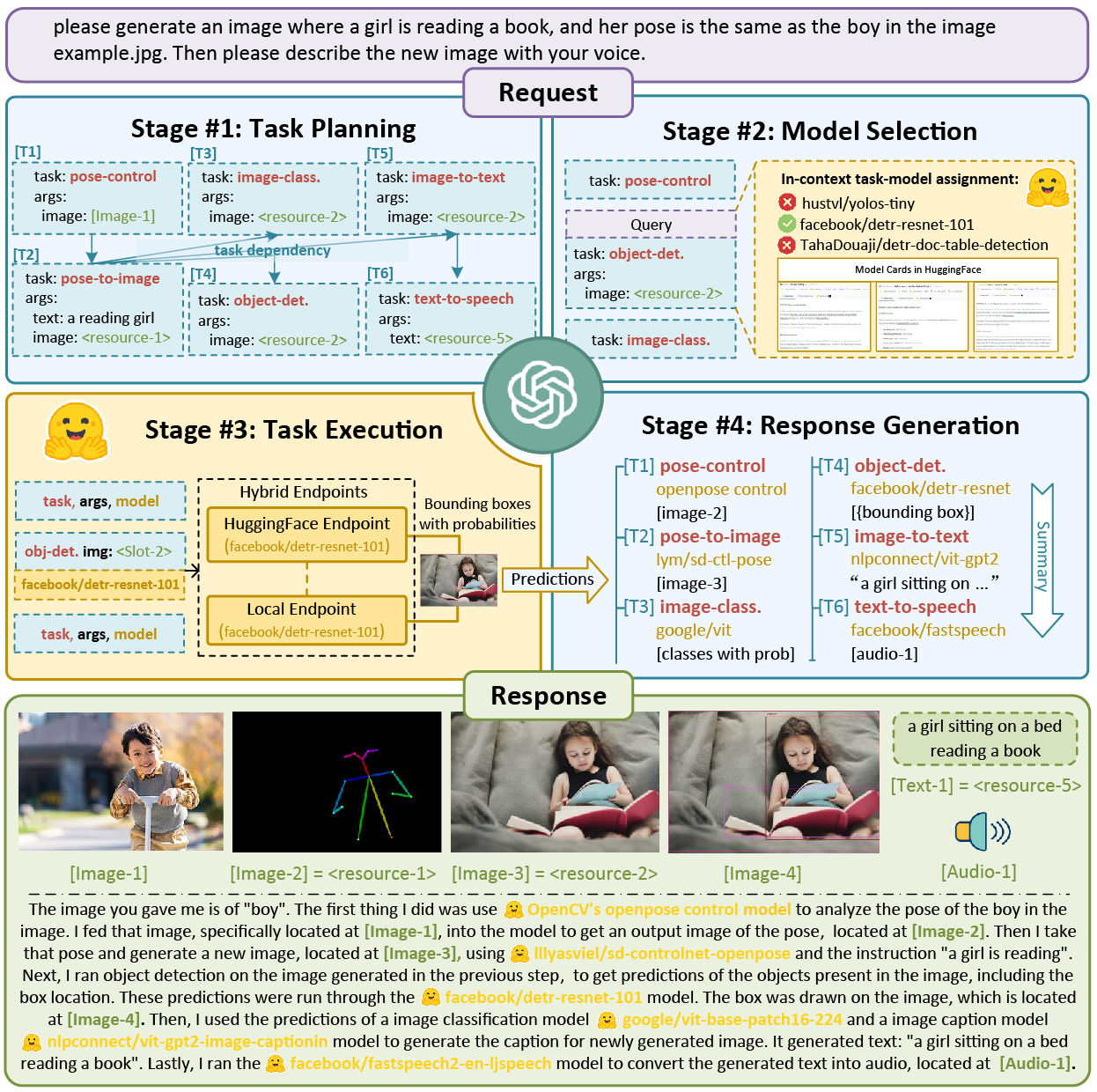

于是 HuggingGPT 就诞生了,该系统的工作流程包括四个阶段:

- 任务规划:使用 ChatGPT 分析用户的请求,了解他们的意图,并将其拆解成可解决的任务。

- 模型选择:为了解决计划的任务,ChatGPT 根据描述选择托管在 Hugging Face 上的 AI 模型。

- 任务执行:调用并执行每个选定的模型,并将结果返回给 ChatGPT。

- 生成响应: 最后使用 ChatGPT 整合所有模型的预测,生成 Response。

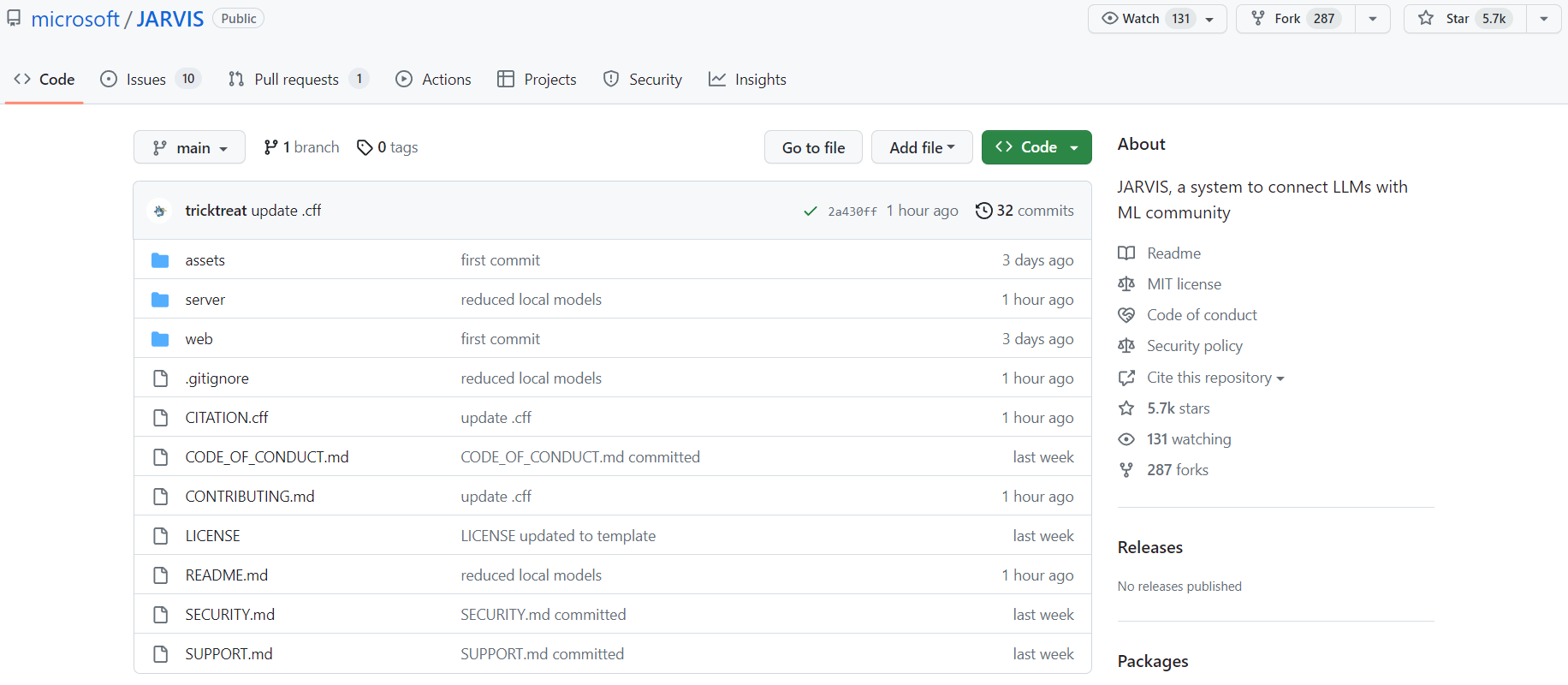

论文发布后不久,微软就在 GitHub 开源了基于论文实现的项目——JARVIS,项目地址:https://github.com/microsoft/JARVIS。其自我描述是用于连接 LLM 和 AI 模型的协作系统。该系统由 LLM(大语言模型)作为控制器和许多 AI 模型作为协作执行者(来自 HuggingFace Hub)组成。

目前该项目正在建设中,微软表示很快就会准备好所有的代码。

运行 JARVIS 的系统要求:

- Ubuntu 16.04 LTS

- NVIDIA GeForce RTX 3090 * 1

- RAM > 12GB (minimal), 16GB (standard), 42GB (full)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง