【推荐理由】本文介绍了REFINER用于微调大规模语言模型,使得能够在提供自动反馈的评论模型交互时明确生成中间推理步骤。

REFINER: Reasoning Feedback on Intermediate Representations

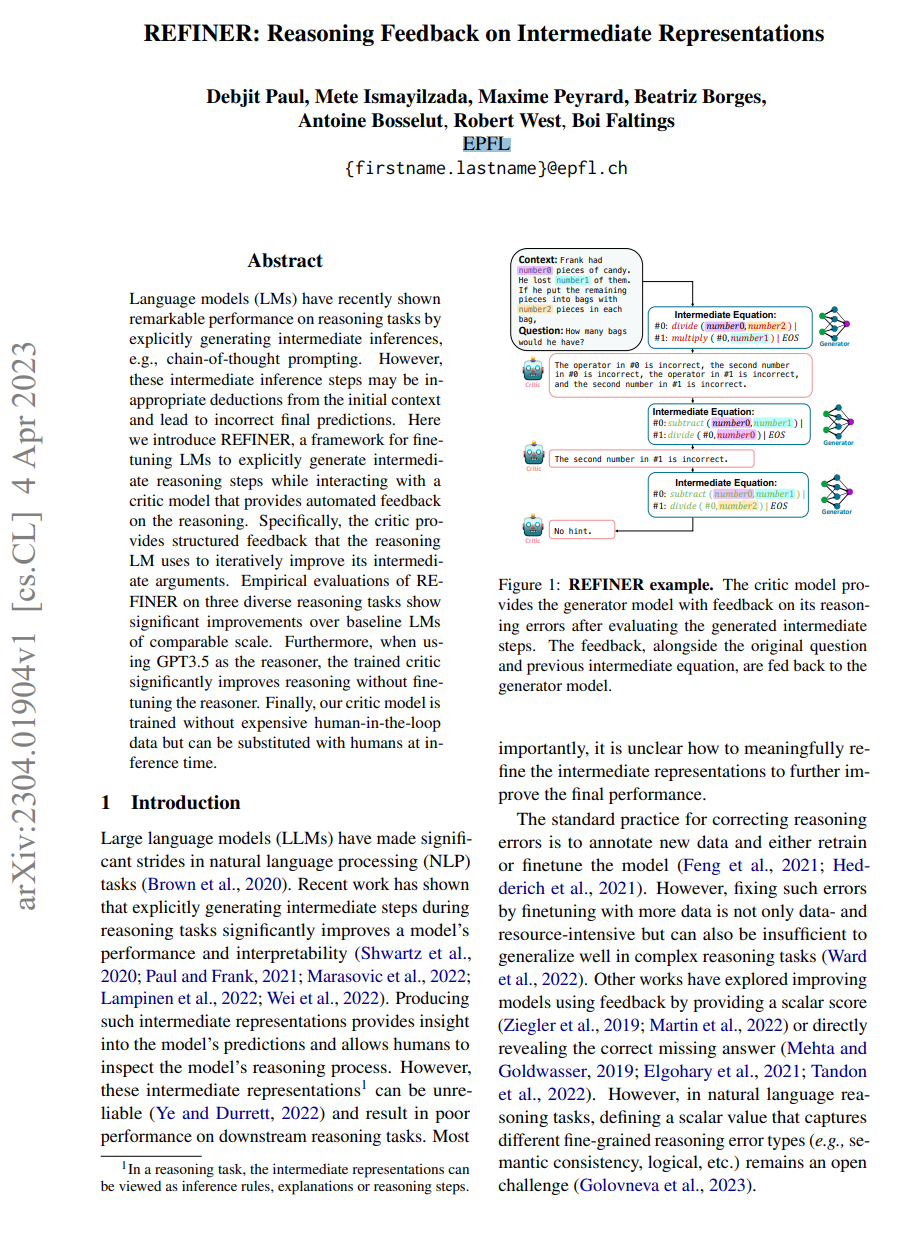

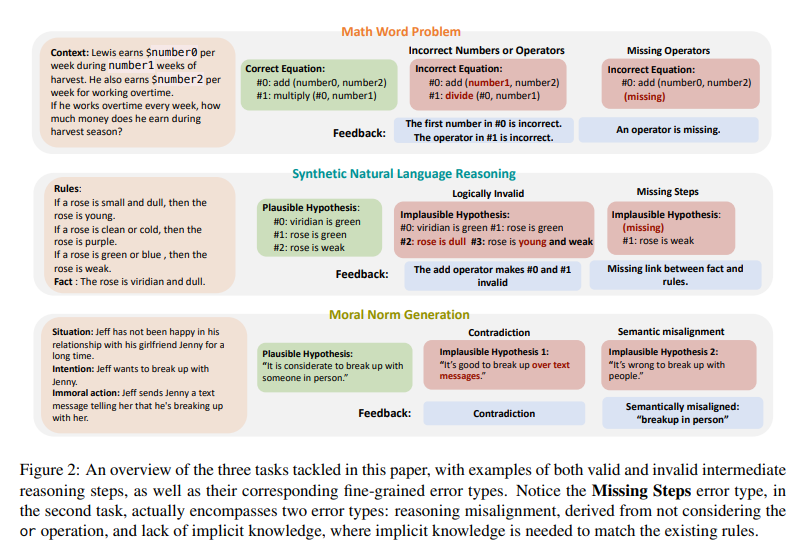

【摘要】语言模型(LMs)最近在推理任务上表现出了卓越的性能,通过明确生成中间推理,例如思考链提示。然而,这些中间推理步骤可能是从初始上下文中不恰当的推断,从而导致不正确的最终预测。在这里,我们介绍了REFINER,一个框架,用于微调LM以在与提供自动反馈的评论模型交互时明确生成中间推理步骤。具体而言,评论家提供结构化反馈,推理LM使用它来迭代改进其中间参数。对三个不同的推理任务的REFINER的实证评估显示出与基线LM相当规模的显着改进。此外,当使用GPT3.5作为推理器时,经过训练的评论家显着提高了推理能力,而无需微调推理器。最后,我们的评论模型是在不需要昂贵的人类参与数据的情况下进行训练的,但可以在推理时用人类替代。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง