标题:DATID-3D: Diversity-Preserved Domain Adaptation Using Text-to-Image Diffusion for 3D Generative Model (CVPR 2023)

作者:Gwanghyun Kim,Se Young Chun

论文:https://arxiv.org/pdf/2211.16374.pdf

代码:https://github.com/gwang-kim/DATID-3D

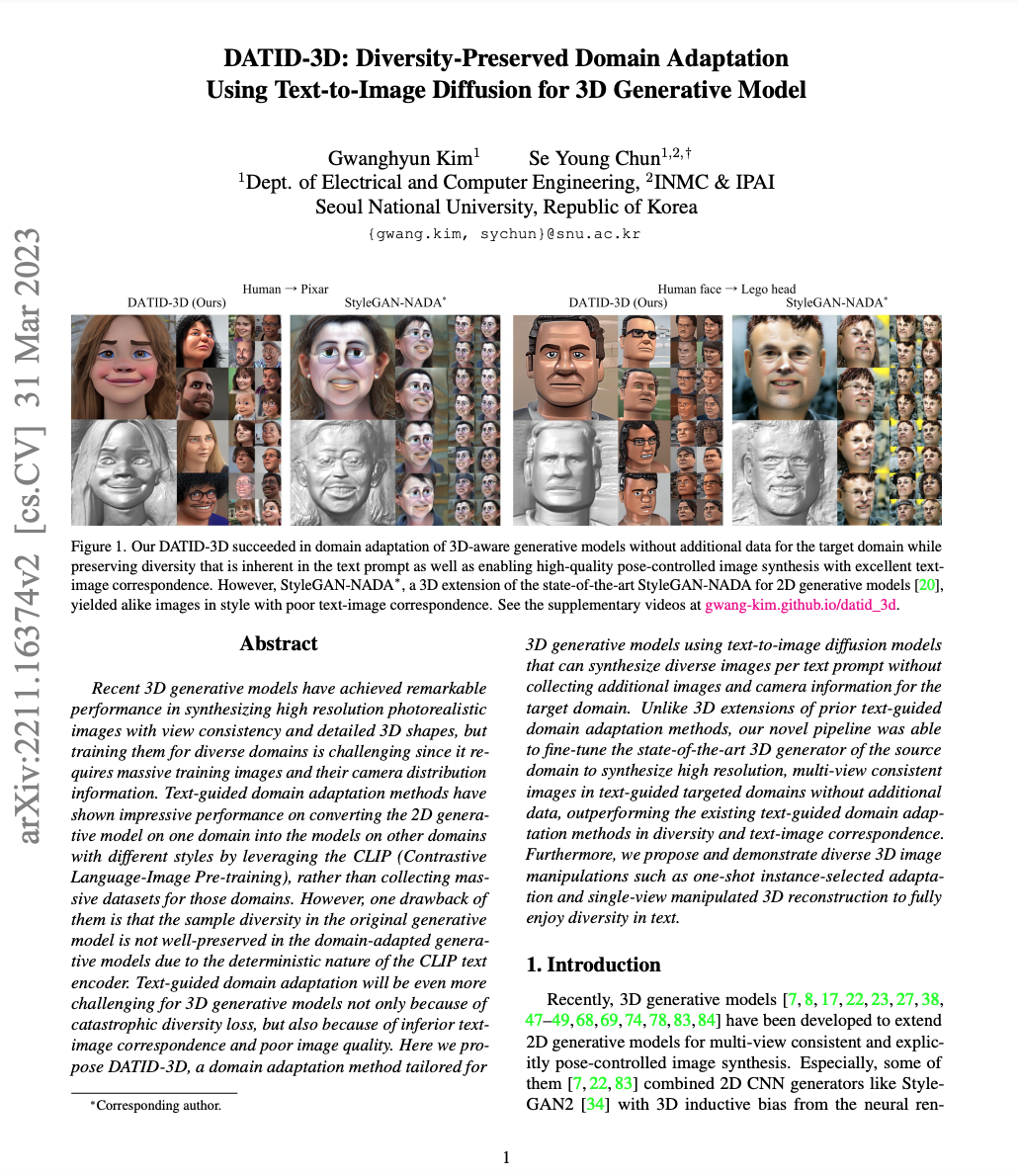

摘要:最近的三维生成模型在合成具有视图一致性和详细三维形状的高分辨率逼真图像方面取得了显著的性能,但为不同领域训练它们是具有挑战性的,因为它需要大量的训练图像及其相机分布信息。文本指导的领域适应方法通过利用CLIP(对比性语言-图像预训练)将一个领域的二维生成模型转换为其他领域的不同风格的模型,而不是为这些领域收集大量的数据集,显示出令人印象深刻的性能。然而,它们的一个缺点是,由于CLIP文本编码器的确定性,原始生成模型中的样本多样性在领域适应的生成模型中没有得到很好的保留。文本指导的领域适应对于三维生成模型来说将更具挑战性,不仅因为灾难性的多样性损失,而且还因为低劣的文本-图像对应关系和糟糕的图像质量。在这里,本文提出了DATID-3D,一种为三维生成模型量身定做的领域适应方法,使用文本到图像的扩散模型,可以在不收集目标领域的额外图像和相机信息的情况下,为每个文本提示合成多样化的图像。与先前的文本指导领域适应方法的三维扩展不同,本文的新型管道能够对源域的最先进的三维生成器进行微调,以在文本指导的目标域中合成高分辨率、多视角的一致图像,在多样性和文本-图像对应性方面优于现有文本指导领域适应方法。此外,我们提出并演示了多样化的三维图像操作,如一次性实例选择的适应和单视图操作的三维重建,以充分享受文本的多样性。

总结:本文提出了DATID-3D,一种为三维生成模型量身定做的领域适应方法。为三维生成模型量身定做的领域适应方法,利用文本到图像的扩散模型,可以为每个文本提示合成不同的图像、。我们的新型管道与3D生成器使得在文本指导领域的多视图一致的图像合成有了出色的质量,在文本指导的领域中实现了卓越的多视图一致的图像合成,保留了文本中的多样性,并在质量和数量上超过了基线的表现。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง