标题:LLM-Adapters: An Adapter Family for Parameter-Efficient Fine-Tuning of Large Language Models

作者:Zhiqiang Hu, Yihuai Lan, Lei Wang, Wanyu Xu, Ee-Peng Lim, Roy Ka-Wei Lee, Lidong Bing, Soujanya Poria

[Singapore University of Technology and Design & Singapore Management University & 3Southwest Jiaotong University &DAMO Academy, Alibaba Group &University of Electronic Science and Technology of China]

简介:

大型语言模型(LLMs),如GPT-3和ChatGPT的成功,导致了许多具有成本效益和可获得性的替代品的发展,这些替代品是通过用特定任务的数据(如ChatDoctor)或指令数据(如Alpaca)对开放的LLMs进行微调而创建的。在各种微调方法中,基于适配器的参数高效微调(PEFT)无疑是最有吸引力的课题之一,因为它只需要微调几个外部参数,而不是整个LLMs,同时获得相当甚至更好的性能。

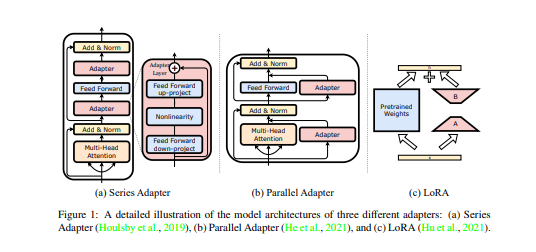

为了能够进一步研究LLM的PEFT方法,本文提出了LLM-Adapters,这是一个易于使用的框架,它将各种适配器集成到LLM中,并可以针对不同的任务执行这些基于适配器的LLM的PEFT方法。该框架包括最先进的开放性LLM,如LaMA、BLOOM、OPT和GPT-J,以及广泛使用的适配器,如系列适配器、并行适配器和LoRA。该框架被设计成对研究友好、高效、模块化和可扩展的,允许整合新的适配器,并对它们与新的和更大规模的LLM进行评估。

此外,为了评估LLMs-Adapters中适配器的有效性,我们对六个数学推理数据集进行了实验。结果表明,在较小规模的LLMs(7B)中使用基于适配器的PEFT,在简单的数学推理数据集的零次推理中,产生了与强大的LLMs(175B)相当的性能,在某些情况下甚至更优。总的来说,我们提供了一个很有前途的框架,用于在下游任务中对大型LLM进行微调。我们相信,所提出的LLMs-Adapters将推动基于适配器的PEFT研究,促进研究管道的部署,并实现对现实世界系统的实际应用。

https://arxiv.org/pdf/2304.01933.pdf】

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง