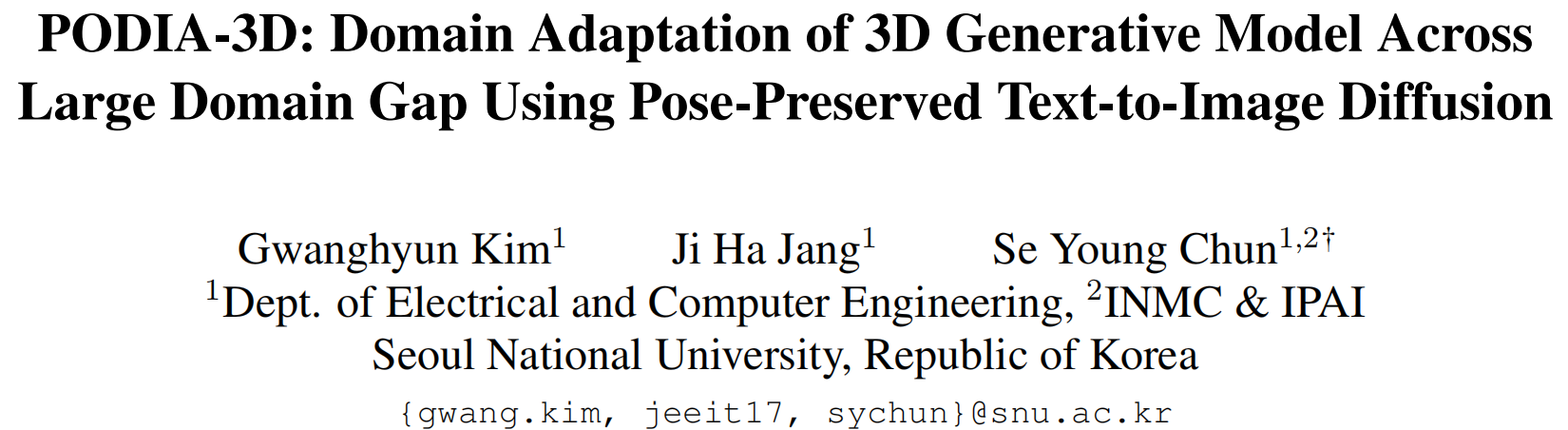

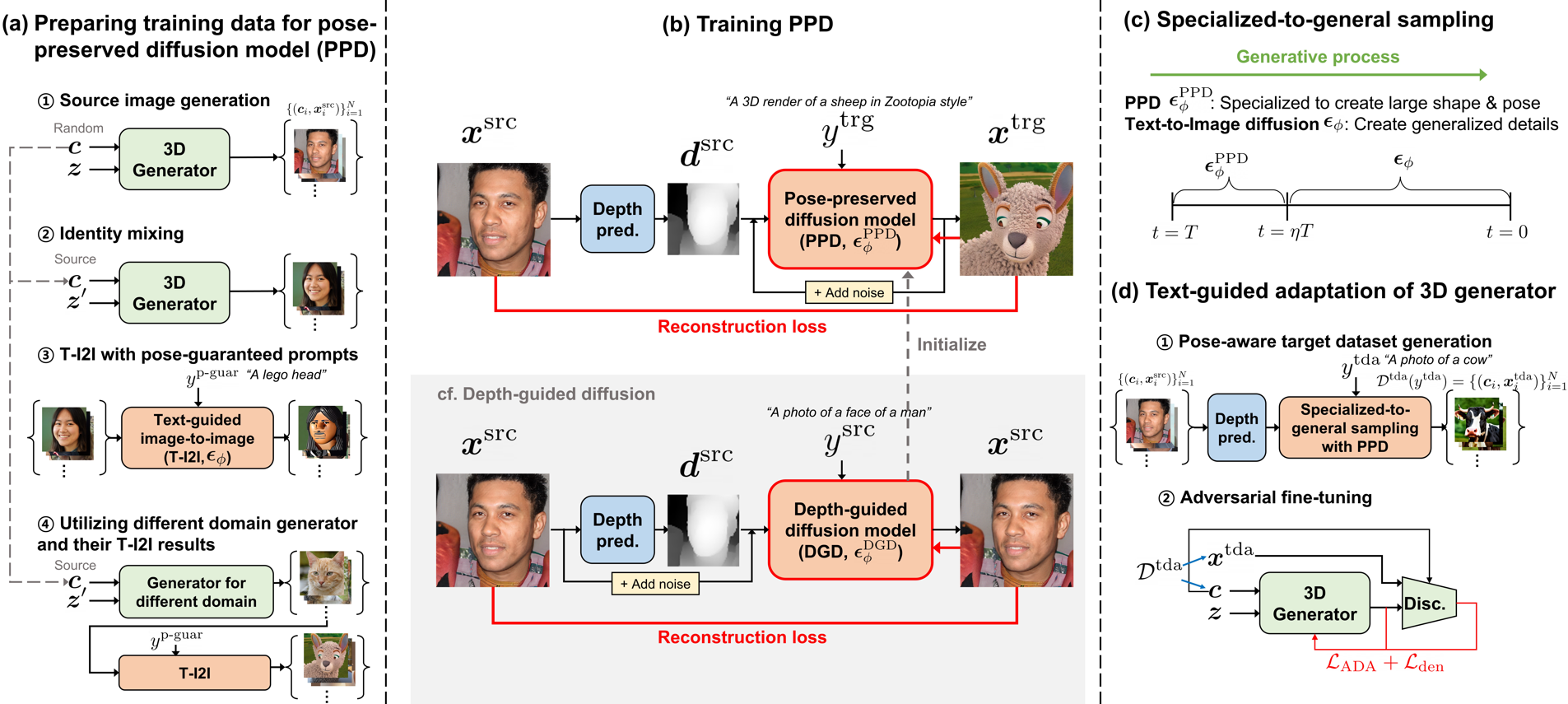

最近,3D生成模型取得了重大进展,但跨越不同领域的训练是具有挑战性的。需要大量的训练数据和对姿态分布的了解。文本导向的域自适应方法允许生成器通过文本提示适应目标领域,从而避免了收集大量数据的需要。最近,DATID-3D通过利用文本到图像扩散技术,在文本导向的领域中保留了文本的多样性,并展现了令人印象深刻的样本质量。然而,将3D生成器适应于与原始领域有显著差异的领域仍然具有挑战性,因为现有的文本到图像扩散模型存在以下问题:1)以扩散为基础的翻译中存在形状姿势平衡问题,2)姿态偏差,以及3)目标领域中存在的实例偏差,导致生成的样本中3D形状、低文本-图像对应以及低领域内部多样性的质量较低。为了解决这些问题,本文提出了一种名为PODIA-3D的新方法,它使用基于保留姿态的文本到图像扩散的域自适应方法用于3D生成模型。本文构建了一个保留姿态的文本到图像扩散模型,允许使用极高级别的噪声来适应显著的领域变化。本文还提出了专门到一般的采样策略来提高生成样本的细节。此外,为了克服实例偏差,本文引入了一种文本导向的去偏差方法,提高了领域内部的多样性。因此,本文的方法成功地跨越显著的领域差距来适应3D生成器。本文的定性结果和用户研究表明,本文的方法在文本-图像对应、逼真度、渲染图像的多样性以及生成样本中3D形状的深度感方面优于现有的3D文本导向域自适应方法。

总结:

本文作者提出了一种名为PODIA-3D的方法,用于解决3D生成模型跨越大领域差距的域自适应问题。PODIA-3D利用文本到图像扩散技术来保留模型姿态,并在弱监督条件下学习并调整模型隐空间以适应新领域数据。实验表明,与当前最先进的方法相比,PODIA-3D在艺术品、自然图像等大领域差距场景下都取得了更好的生成结果,展示了其在3D生成领域的成功应用。

作者:

平台:https://gwang-kim.github.io/podia_3d/

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง