【推荐理由】本文引入了轻量级视频扩散模型,利用低维的三维潜在空间,在有限的计算资源下显著优于之前的像素空间视频扩散模型。该方法比之前的方法生成了更真实和更长的视频。

Latent Video Diffusion Models for High-Fidelity Long Video Generation

Yingqing He, Tianyu Yang, Yong Zhang, Ying Shan, Qifeng Chen

[The Hong Kong University of Science and Technology & Tencent AI Lab]

【论文链接】https://arxiv.org/pdf/2211.13221.pdf

【项目链接】https://github.com/VideoCrafter/VideoCrafter

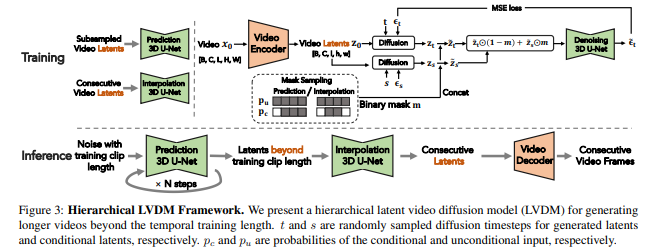

【摘要】AI生成的内容近来受到了很多关注,但是逼真的视频合成仍然具有挑战性。虽然已经尝试使用GAN和自回归模型在这个领域进行了很多尝试,但是生成的视频视觉质量和长度都远远不够令人满意。最近,扩散模型表现出了非凡的结果,但需要大量的计算资源。为了解决这个问题,文章介绍了轻量级视频扩散模型,利用低维3D潜空间,在有限的计算预算下显著优于以前的像素空间视频扩散模型。此外,文章提出了在潜空间中的分层扩散,以便生成超过一千帧的更长的视频。为了进一步克服长视频生成的性能下降问题,本文提出了条件潜空间扰动和无条件指导,有效地减轻了在扩展视频长度过程中累积的误差。对不同类别的小域数据集进行的广泛实验表明,该框架比以前的强基线生成更逼真和更长的视频。作者还提供了一个大规模的文本到视频生成的扩展,以展示该方法的优越性。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง