【推荐理由】本文提出一种使用知识蒸馏的数据增强框架来改善预训练代码语言模型。该框架利用预训练和微调阶段获得的知识来生成伪数据,然后将其用作下一步的训练数据。实验结果表明,该框架显著提高了代码大模型在序列生成任务中的性能。

Better Language Models of Code through Self-Improvement

Hung Quoc To, Nghi D. Q. Bui, Jin Guo, Tien N. Nguyen

[Fulbright University & McGill University]

【论文链接】https://arxiv.org/pdf/2304.01228.pdf

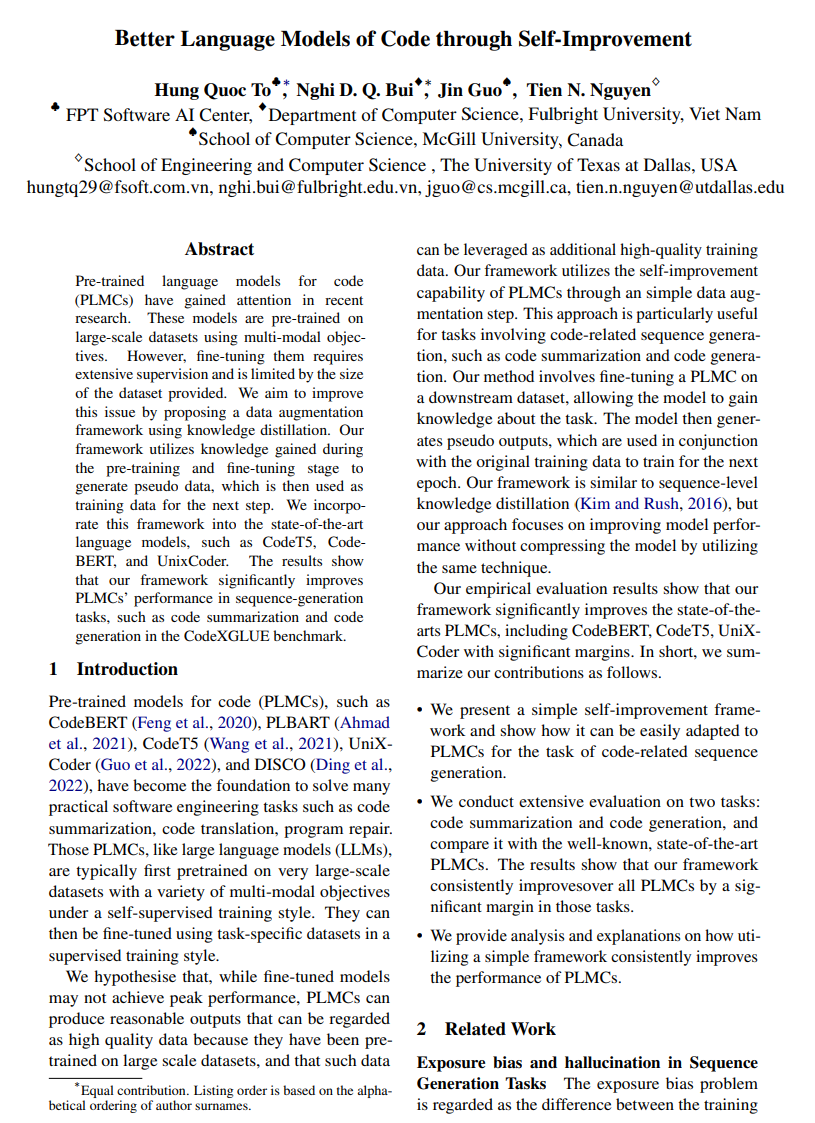

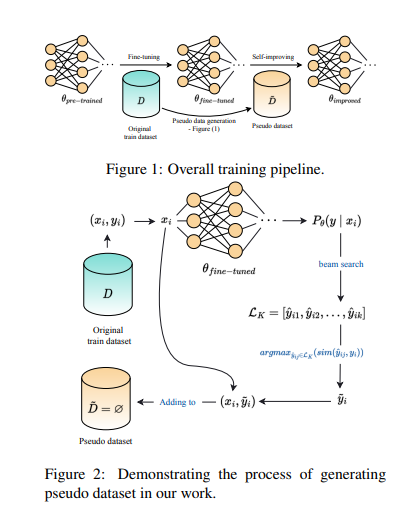

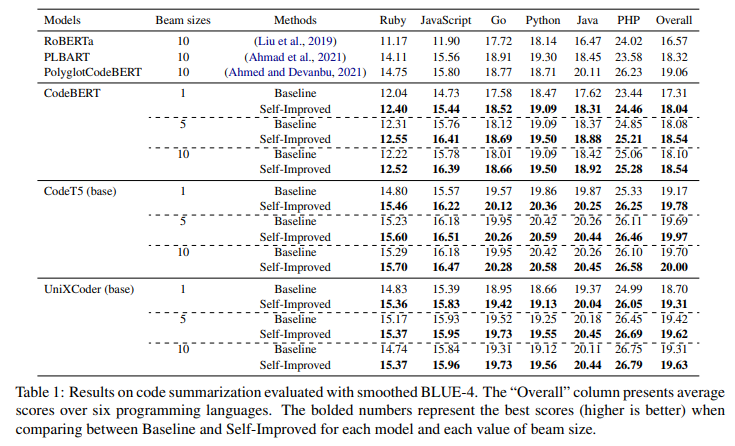

【摘要】预训练代码语言模型(PLMCs)近年来引起了研究人员的关注。这些模型使用多模式目标在大规模数据集上进行预训练。然而,对它们进行微调需要大量的监督,并且受到提供的数据集大小的限制。本文旨在通过提出一种使用知识蒸馏的数据增强框架来改善这个问题。该框架利用预训练和微调阶段获得的知识来生成伪数据,然后将其用作下一步的训练数据。文章将这个框架整合到最先进的语言模型中,例如CodeT5、CodeBERT和UnixCoder。结果表明,该框架显著提高了PLMC在序列生成任务中的性能,例如在CodeXGLUE基准测试中的代码摘要和代码生成任务中。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง