【推荐理由】本文是第一篇比较基于计算优化的模型缩放和基于固定数据集大小训练的模型的开放和可复制的工作。

Cerebras-GPT: Open Compute-Optimal Language Models Trained on the Cerebras Wafer-Scale Cluster

Nolan Dey, Gurpreet Gosal, Zhiming, Chen, Hemant Khachane, William Marshall, Ribhu Pathria, Marvin Tom, Joel Hestness

[Cerebras Systems]

【论文链接】https://arxiv.org/pdf/2304.03208.pdf

【项目链接】https://huggingface.co/cerebras

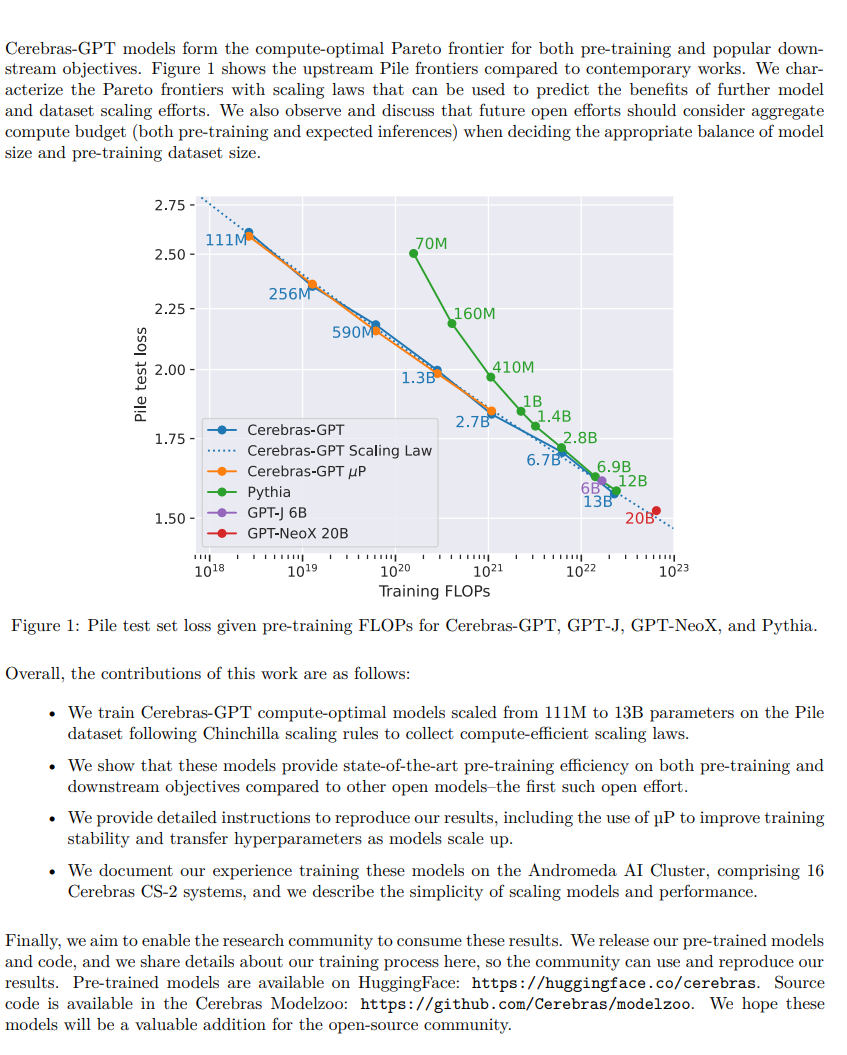

【摘要】本文研究了最近的研究进展,通过高效的预训练和扩展以及开放式数据集和工具来改进大型语言模型。文章将这些先进技术结合起来,介绍一种名为Cerebras-GPT的开放计算优化语言模型系列,其参数规模从111M到13B不等。作者使用Eleuther Pile数据集对Cerebras-GPT模型进行训练,遵循DeepMind Chinchilla缩放规则进行高效预训练(在给定计算预算下实现最高精度)。文章表征了可预测的幂律缩放,并将Cerebras-GPT与其他公开可用的模型进行比较,以展示所有Cerebras-GPT模型在预训练和下游目标上均具有最先进的训练效率。作者描述了自己的学习过程,包括最大更新参数化(µP)如何进一步改善大型模型的扩展性,在规模上提高准确性和超参数可预测性。文章发布了我们的预训练模型和代码,使得这篇论文成为第一篇比较基于计算优化的模型缩放和基于固定数据集大小训练的模型的开放和可复制的工作。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง