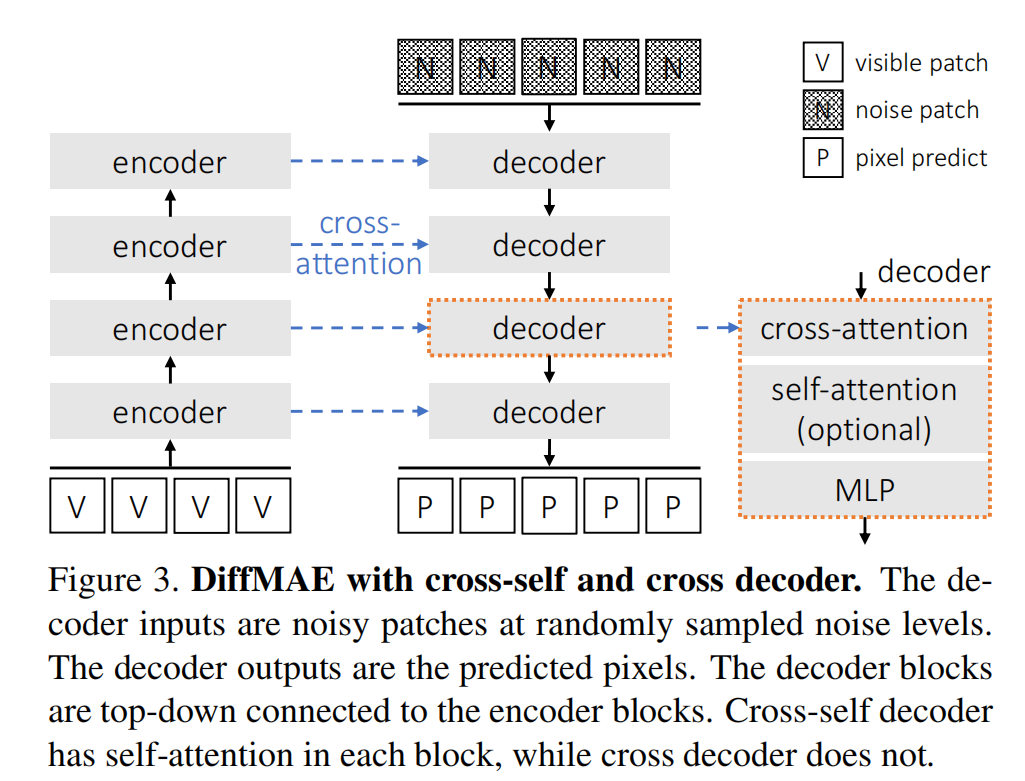

长期以来一直存在一种信念,即生成可以促进对视觉数据的真正理解。为了符合这一观点,本文重新审视了在最近对去噪扩散模型产生了兴趣的情况下,针对生成式预训练视觉表示的方法。虽然直接使用扩散模型进行预训练并不能产生强大的表示,但本文将扩散模型作为掩蔽输入的条件,并将扩散模型形式化为掩蔽自编码器(DiffMAE)。本文的方法能够(i) 作为下游识别任务的强大初始化,(ii) 进行高质量的图像修复,(iii) 轻松扩展到视频并产生最先进的分类准确性。本文进一步对设计选择的优缺点进行了全面研究,并在扩散模型和掩蔽自编码器之间建立了联系。

总结:

本文中提出了一种新的方法,将扩散模型作为掩蔽自编码器(DiffMAE),以实现对视觉数据的生成式预训练表示。通过对掩蔽输入的条件,该方法能够产生强大的表示,不仅能作为下游识别任务的强大初始化,还能进行高质量的图像修复,并轻松扩展到视频,并产生最先进的分类准确性。本文进一步对设计选择的优缺点进行了全面研究,并在扩散模型和掩蔽自编码器之间建立了联系。

标题:Diffusion Models as Masked Autoencoders

作者:

平台:https://weichen582.github.io/diffmae.html

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง