【推荐理由】本文旨在建立一个通用的多模态基础大模型用于广泛的电子商务应用。

Learning Instance-Level Representation for Large-Scale Multi-Modal Pretraining in E-commerce

Yang Jin, Yongzhi Li , Zehuan Yuan, Yadong Mu

[Peking University & ByteDance Inc.]

【论文链接】https://arxiv.org/pdf/2304.02853.pdf

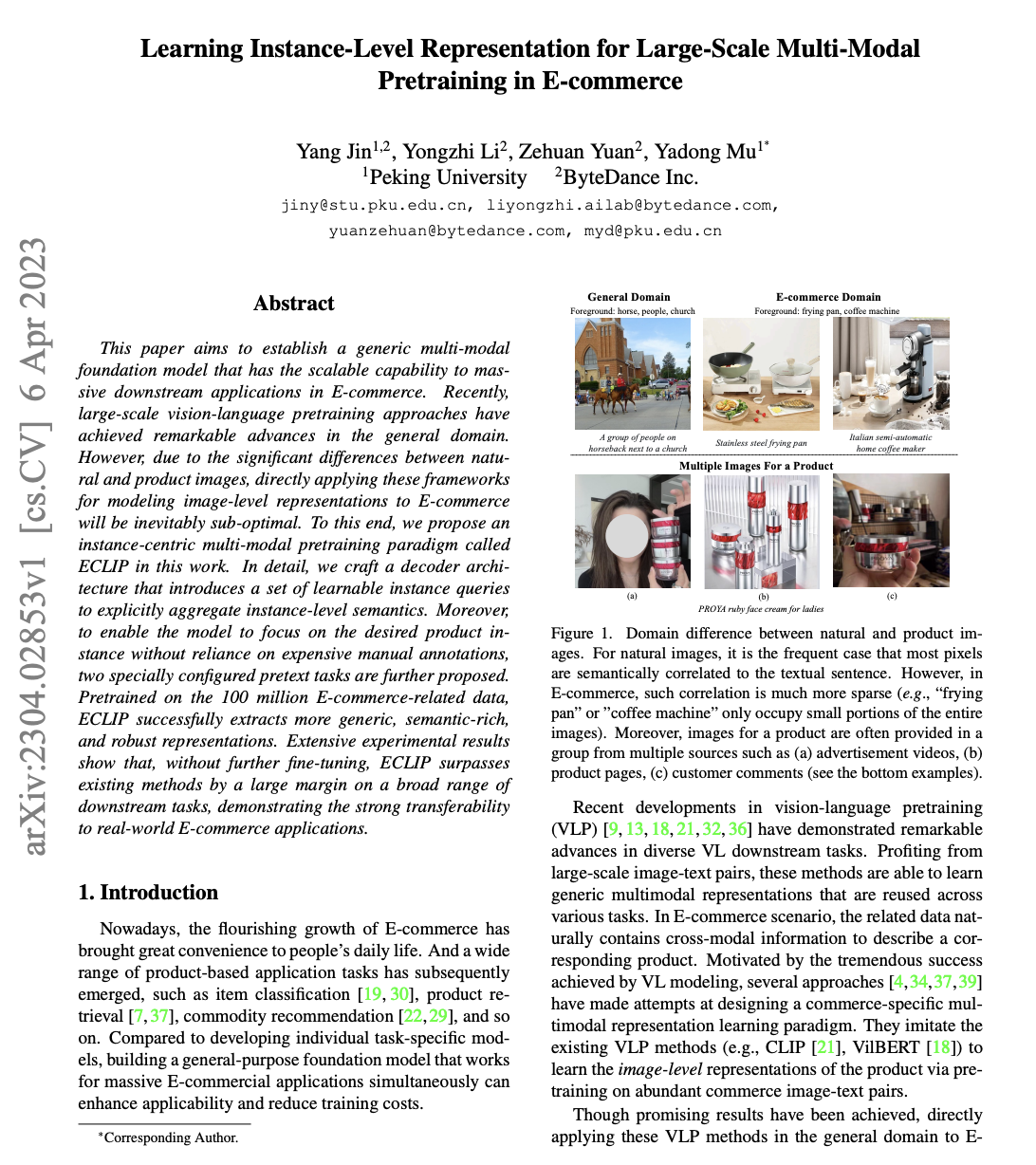

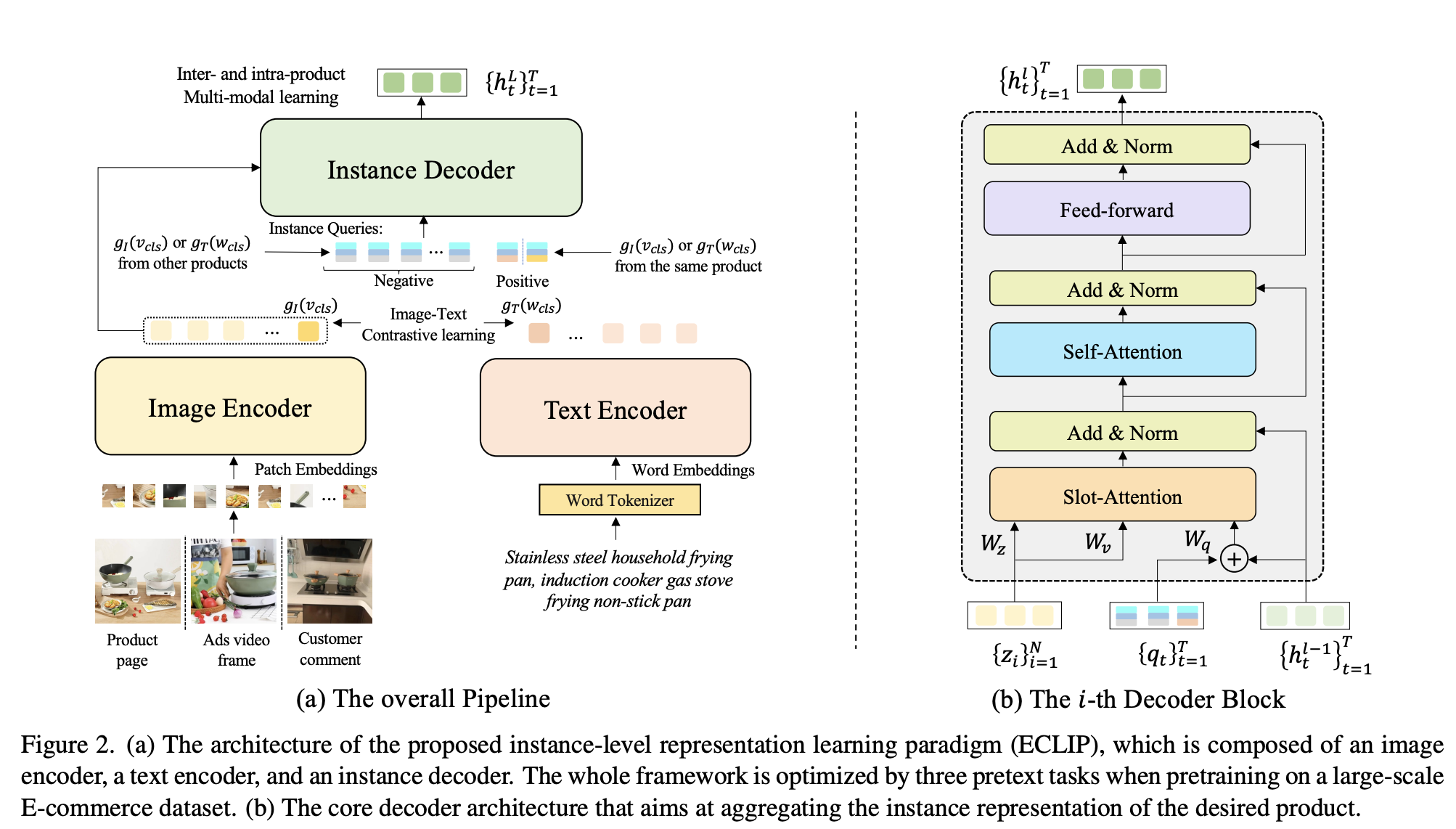

【摘要】本文旨在建立一个通用的多模态基础模型,具有在电子商务中大规模应用的可扩展能力。最近,在通用领域中,大规模视觉语言预训练方法取得了显著进展。然而,由于自然图像和产品图像之间存在显著差异,直接将这些框架应用于电子商务中的图像级表示建模将不可避免地会产生亚优化结果。因此,作者在本文中提出了一种以实例为中心的多模态预训练范式,称为ECLIP。具体而言,文章设计了一个解码器架构,引入一组可学习的实例查询,以明确地聚合实例级语义。此外,为了使模型能够专注于所需的产品实例,而不依赖于昂贵的手动注释,进一步提出了两个特别配置的预文本任务。在对1亿条与电子商务相关的数据进行预训练后,ECLIP成功提取了更通用、语义丰富和鲁棒的表示。广泛的实验结果表明,无需进一步微调,ECLIP在各种下游任务上都大幅度超过了现有方法,展示了对真实世界电子商务应用的强大可迁移性。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง