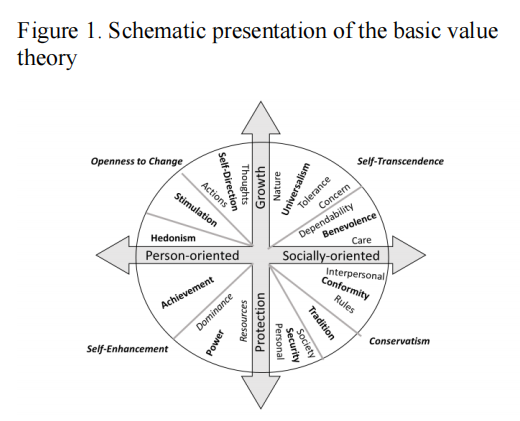

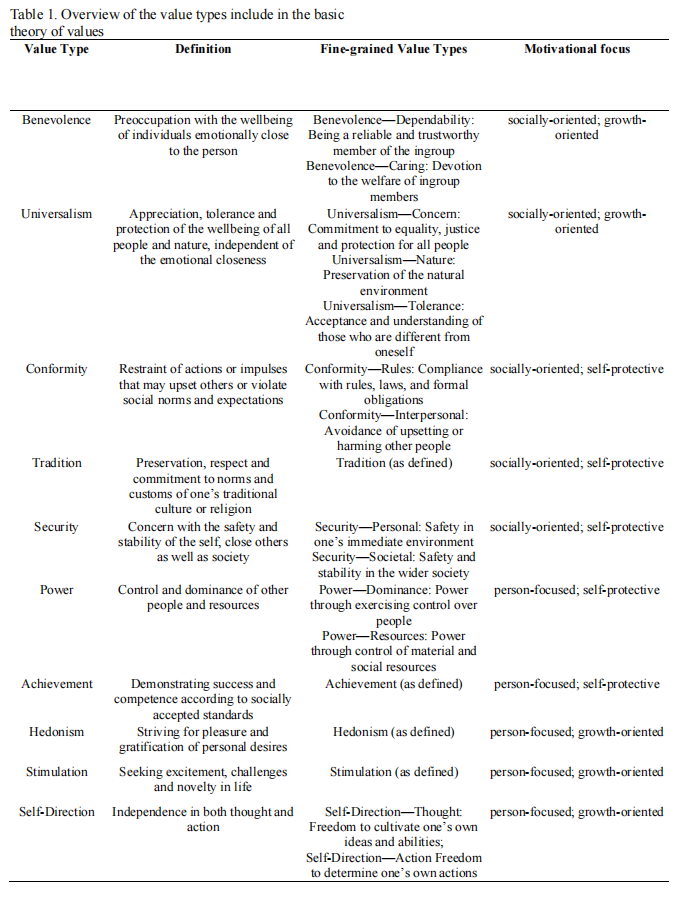

近期,人们一直关注大型语言模型(LLMs)生成的文本是否存在意识形态基础和可能的歧视。本文使用心理学的价值理论来测试ChatGPT中可能存在的价值偏见。本文设计了一项简单的实验,使用从Schwartz基本价值理论中派生的多个探针(来自修订后的《肖像价值问卷》的项目,价值类型定义,价值名称)触发OpenAI API反复生成文本,然后使用基于理论的价值词典和词袋方法分析所生成的语料库的价值内容。总的来说,本文发现没有明显的显性价值偏见证据。结果显示,此生成文本具有足够的构造和鉴别效度,符合心理模型的理论预测,这表明价值内容被高度忠实地体现在输出中。本文看到了一些社会导向价值的融合,这可能表明这些价值在语言水平上的区分不够清晰,或者这种混合可能反映了潜在的普遍的人类动机。本文概述了这些发现的一些可能的应用领域,包括企业使用和政策制定,以及未来的研究方向。本文还强调了使用语言模型相对高度忠实的基于动机的内容复制对于人类价值理论的推理的可能影响。

总结:

这篇文章探讨了使用描述性价值理论探索ChatGPT中的价值偏见。ChatGPT返回有关人类价值观的信息,但这些价值观是否具有偏见仍有待研究。作者使用描述性价值理论来研究ChatGPT生成的对话中的价值偏见。结果表明,ChatGPT的对话可能存在一定程度的价值偏见,这可能会对其应用产生影响。该研究提供了一个为今后的ChatGPT研究提供指导和思路的基础。

作者:Ronald Fischer, Markus Luczak-Roesch, Johannes A Karl

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง