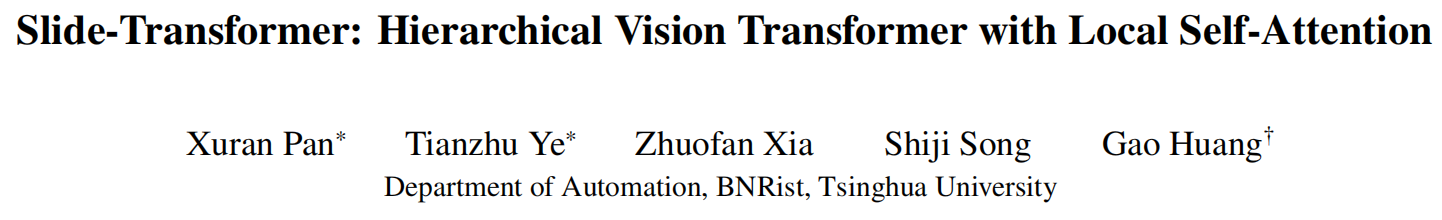

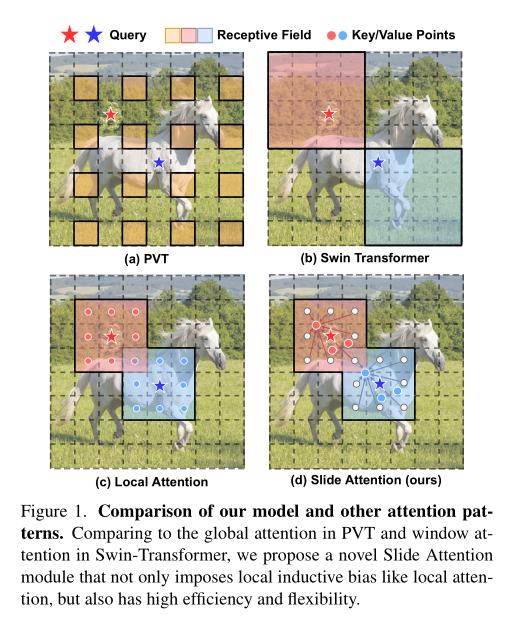

自注意机制是视觉Transformer(ViT)取得近期进展的关键因素,它使得从全局上下文中进行自适应特征提取成为可能。然而,现有的自注意方法要么采用稀疏的全局注意力,要么采用窗口注意力来降低计算复杂度,这可能会损害局部特征学习或受制于一些手工设计。相比之下,局部注意力将每个查询的接收场限制在其自身的相邻像素中,拥有卷积和自注意力的优点,即本地归纳偏好和动态特征选择。然而,当前的局部注意力模块要么使用低效的Im2Col函数,要么依赖于特定的CUDA内核,难以推广到不支持CUDA的设备。本文提出了一种新颖的局部注意力模块Slide Attention,它利用常见的卷积操作实现高效、灵活和泛化性强的注意力机制。具体而言,我们首先从一种新的基于行的角度重新解释了基于列的Im2Col函数,并使用深度卷积作为有效替代。在此基础上,我们提出了一种基于重新参数化技术的变形平移模块,进一步将固定的键/值位置松弛到局部区域的变形特征上。通过这种方式,我们的模块以高效和灵活的方式实现了局部注意力范式。大量实验证明,我们的滑动注意力模块适用于各种先进的视觉Transformer模型,并兼容各种硬件设备,在全面的基准测试中取得了持续改进的性能。代码可在https://github.com/LeapLabTHU/Slide-Transformer获得。

总结:

本文提出了一种层次化的视觉Transformer模型Slide-Transformer,它基于可分层的多尺度结构,在局部区域使用自注意力机制处理图像块,同时在全局范围内使用全连接的Transformer层来融合不同分辨率的特征。Slide-Transformer在多个视觉任务上与现有的SOTA方法进行了比较,结果表明,它可以有效地提高图像分类、分割和检测的性能,并且在显存占用方面具有较小的开销。

标题:Slide-Transformer: Hierarchical Vision Transformer with Local Self-Attention

作者:Xuran Pan, Tianzhu Ye, Zhuofan Xia, Shiji Song, Gao Huang

代码:https://github.com/LeapLabTHU/Slide-Transformer

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง