【推荐理由】文提出了一种新的文本到图像算法,用于解决当前生成的图像与文本描述之间的低保真度。实验表明,该方法生成的图像比没有对扩散模型进行微调的基线具有更高的保真度。

Harnessing the Spatial-Temporal Attention of Diffusion Models for High-Fidelity Text-to-Image Synthesis

Qiucheng Wu, Yujian Liu, Handong Zhao, Trung Bui, Zhe Lin, Yang Zhang, Shiyu Chang

[UC Santa Barbara & Adobe Research & MIT-IBM Watson AI Lab]

【论文链接】https://arxiv.org/pdf/2304.03869.pdf

【项目地址】https://github.com/UCSB-NLP-Chang/Diffusion-SpaceTime-Attn

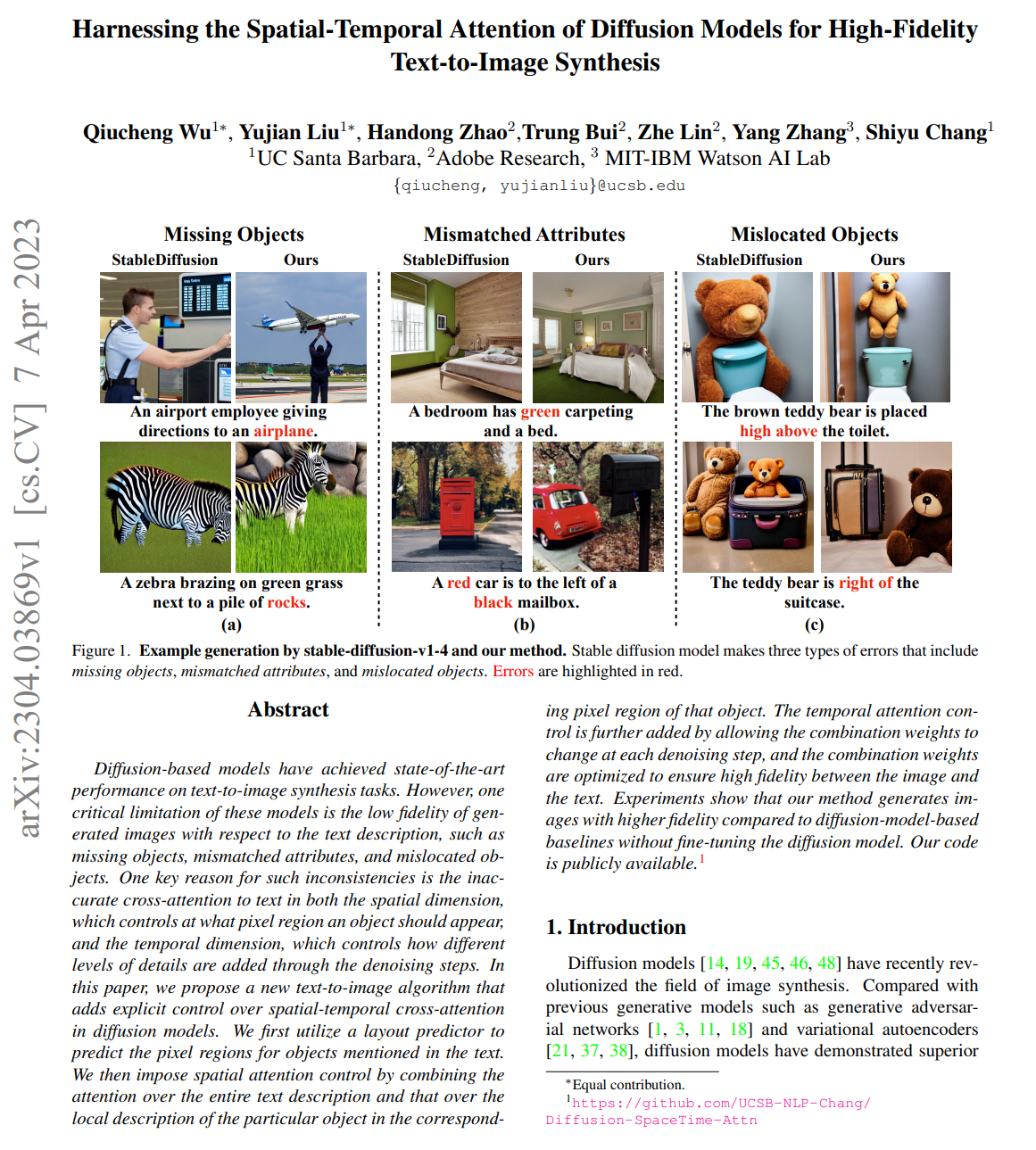

【摘要】扩散模型在文本到图像生成任务中取得了最先进的性能。然而,这些模型的一个关键限制是生成的图像与文本描述之间的低保真度,例如缺失对象、不匹配的属性和错误定位的对象。造成这种不一致性的一个重要原因是跨空间维度和时间维度对文本的交叉注意力不准确,空间维度控制对象应出现在哪个像素区域,而时间维度控制通过去噪步骤添加不同级别的细节。在本文中,作者提出了一种新的文本到图像算法,它在扩散模型中增加了显式的空时交叉注意力控制。首先,文章利用布局预测器来预测文本中提到的对象的像素区域。然后,通过将整个文本描述的注意力和相应对象像素区域的局部描述的注意力相结合,实现空间注意力控制。通过允许组合权重在每个去噪步骤中发生变化,并优化组合权重以确保图像与文本之间的高保真度,进一步添加了时间注意力控制。实验表明,该方法生成的图像比没有对扩散模型进行微调的基线具有更高的保真度。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง