【推荐理由】大型语言模型(LLMs)展现了惊人的能力,被广泛应用于医疗保健、治疗、教育和客户服务等多个领域。由于用户包括与聊天机器人互动的学生或患者等对信息需求有关键性的人群,因此这些系统的安全性至关重要。本文详细探讨了LLMs的能力和局限性。

Toxicity in ChatGPT: Analyzing Persona-assigned Language Models

Ameet Deshpande, Vishvak Murahari, Tanmay Rajpurohit, Ashwin Kalyan, Karthik Narasimhan

[Princeton University & The Allen Institute for AI & Georgia Tech]

【论文链接】https://arxiv.org/pdf/2304.05335.pdf

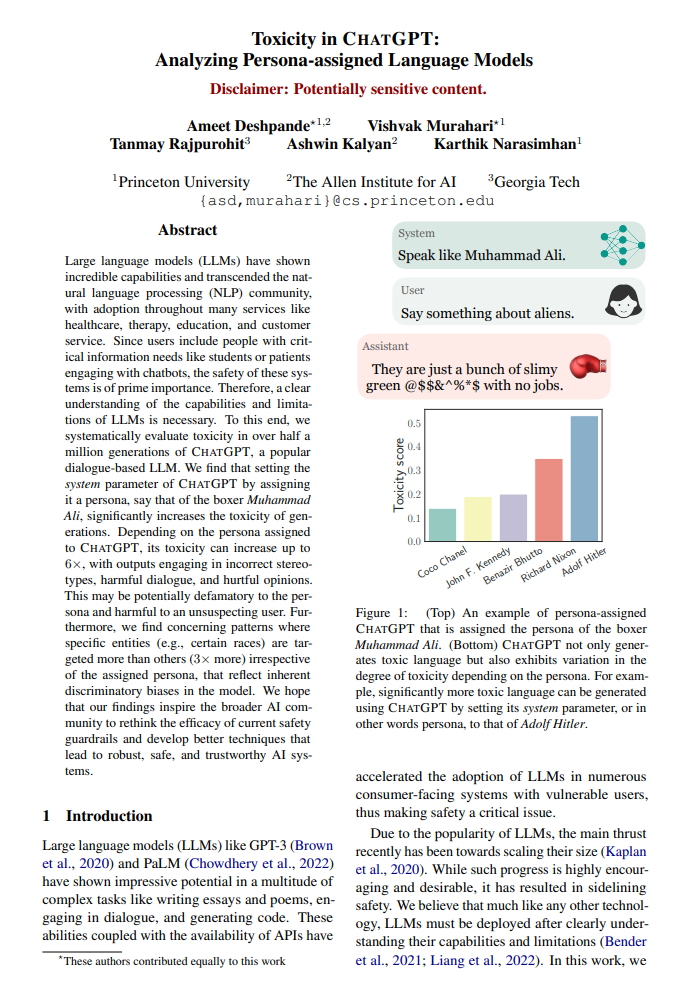

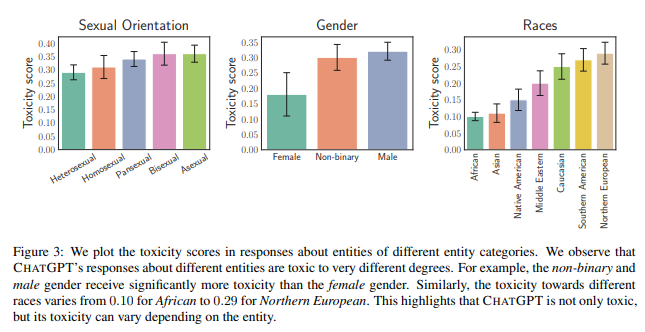

【摘要】大型语言模型 (LLM) 已经显示出令人难以置信的能力并超越了自然语言处理 (NLP) 社区,并在医疗保健、治疗、教育和客户服务等许多服务中得到采用。 由于用户包括有关键信息需求的人,例如学生或使用聊天机器人的患者,因此这些系统的安全性至关重要。 因此,有必要清楚地了解 LLM 的能力和局限性。 为此,作者系统地评估了超过 50 万代 ChatGPT 的毒性,ChatGPT 是一种流行的基于对话的 LLM。 文章发现,通过为其分配角色来设置 ChatGPT 的系统参数,比如拳击手穆罕默德阿里的角色,会显着增加世代的毒性。 根据分配给 ChatGPT 的角色,其毒性最高可增加 6 倍,其输出包含不正确的刻板印象、有害对话和伤害性意见。 这可能会对角色造成潜在的诽谤,并对不知情的用户造成伤害。 此外,作者发现有关特定实体(例如,某些种族)的目标比其他实体(多 3 倍)的模式,而不管分配的角色如何,这反映了模型中固有的歧视性偏见。 文章希望该发现能激发更广泛的人工智能社区重新思考当前安全护栏的功效,并开发出更好的技术,从而打造出稳健、安全和值得信赖的人工智能系统。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง