标题:Teaching Large Language Models to Self-Debug

作者:Xinyun C++hen, Maxwell Lin, Nathanael Schärli, Denny Zhou

[Google Research & UC Berkeley]

简介:

大型语言模型(LLMs)在代码生成方面取得了令人印象深刻的性能。然而,对于复杂的编程任务,一次性生成正确的解决方案变得很有挑战性,因此一些先前的工作设计了程序修复方法来提高代码生成性能。

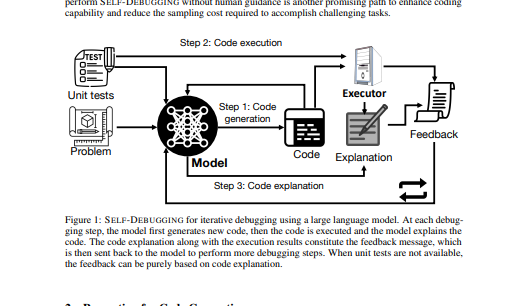

在这项工作中,我们提出了Self-Debugging,它教导一个大型语言模型通过少量的演示来调试其预测的程序。特别是,我们证明Self-Debugging可以教大型语言模型进行橡皮鸭调试;也就是说,在没有任何关于代码正确性或错误信息的反馈的情况下,该模型能够通过用自然语言解释生成的代码来识别其错误。

自我调试在几个代码生成基准上实现了最先进的性能,包括文本到SQL生成的Spider数据集,C++到Python翻译的TransCoder,以及文本到Python生成的MBPP。在没有单元测试来验证预测正确性的Spider基准上,带有代码解释的Self-Debugging一直将基准线提高了2-3%,并将最难的标签问题的预测准确率提高了9%。在有单元测试的TransCoder和MBPP上,Self-Debugging将基线准确性提高了12%。同时,通过利用反馈信息和重用失败的预测,Self-Debugging明显提高了采样效率,并且可以匹配或超过生成10倍以上候选程序的基线模型。

https://arxiv.org/pdf/2304.05128.pdf

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง