总结:

亚马逊发布了“Pick and Place”机器人培训的数据集“视觉和物理推理”(VIPr),包含128个背景、超过40万张图像和多个摄像头视角的数据。这个数据集是当前公开领先的,可以用于训练机器人精细动作,例如进行搬运、堆叠和装载等任务。VIPr数据集潜在的应用包括仓库自动化、制造业及多样化的器械操作。

为了改进在仓库中捡选、分类和包装产品的机器人性能,亚马逊公开发布了这个领域中最大的产品分类场景图像数据集。之前公开的数据集中最大的仅包含大约100个物体,而亚马逊的数据集名为ARMBench,包含了超过190,000个物体。因此,这个数据集可以用于训练“拾取和放置”机器人,使其更能够适应新的产品和环境。

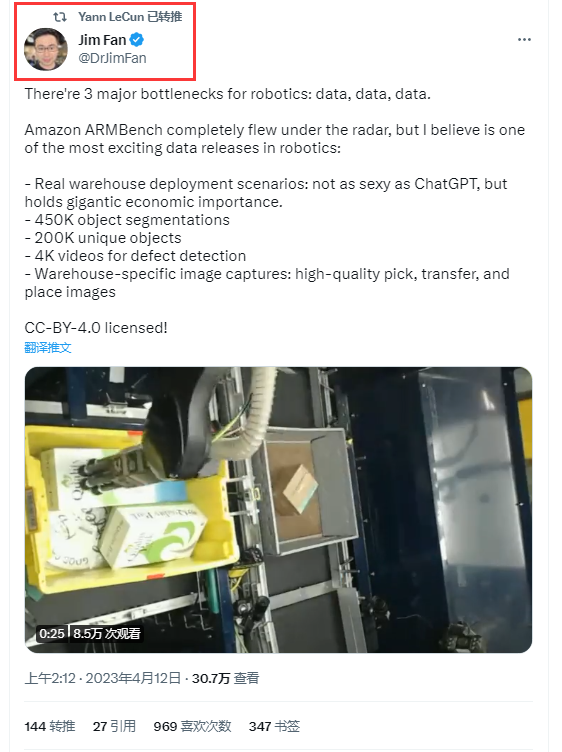

我们将在今年春季的国际机器人和自动化会议(ICRA)上介绍ARMBench。ARMBench的场景是机器人手臂必须从一个装满了物品的箱子里取出一个物品并将其转移到传送带上的托盘上。物品的种类、配置和与机器人系统的相互作用使得这个任务异常具有挑战性。

ARMBench包含三个不同任务的图像集:(1)物品分割,即在同一个箱子中识别不同产品的边界;(2)物品识别,即确定参考数据库中哪个产品图像对应于图像中突出显示的产品;(3)缺陷检测,即确定机器人是否犯了错误,例如取多个物品而不是一个或在转移过程中损坏物品。

数据集中的图像分为三个不同的类别:

- 拾取图像是填满物品的箱子的俯视图,在机器人处理之前;

- 转移图像是机器人将物品转移到托盘时从多个视角捕获的;

- 放置图像是选定物品放置在其中的托盘的俯视图。

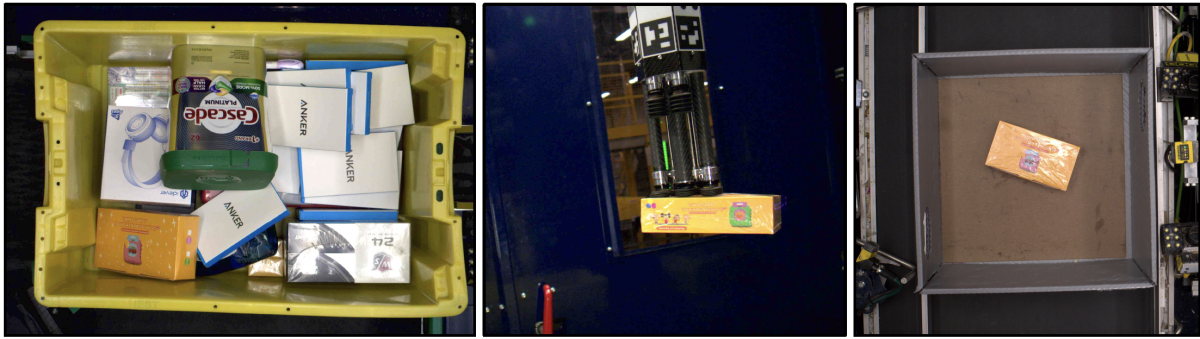

物品分割数据集包含超过50,000个图像,每个图像中有从一个到50个手动物品分割,平均约为10.5个。高度混杂的背景与各种不同的物品——其中一些甚至是透明或反射的——使得这是一个具有挑战性且独特的基准测试。

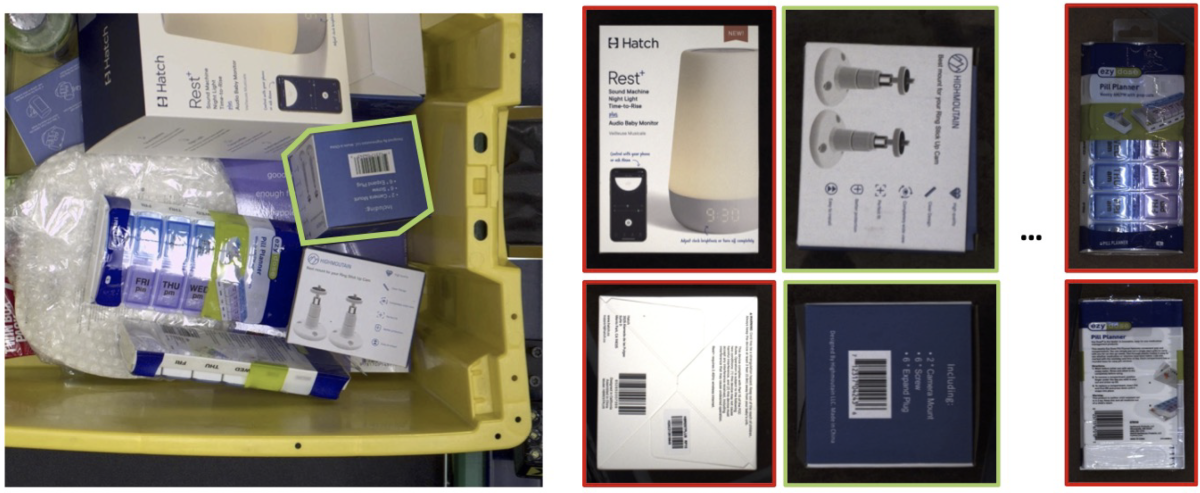

物品识别数据集包含超过235,000个标记的“拾取活动”; 每个拾取活动包括一个拾取图像和三个转移图像。此外还有超过190,000个产品的参考图像和文本描述;在物品识别任务中,模型必须学习将其中一个参考产品与在拾取和转移图像中突出显示的物品匹配。

这项任务面临的一些挑战包括区分外观相似的产品、匹配跨越大范围视角变化的产品和融合多模态信息(例如图像和文本)以作出预测。

缺陷检测数据集包括静态图像和视频。这些静态图像——超过19,000张——是在转移阶段拍摄的,旨在训练缺陷检测模型,这些模型能够确定机器人手臂是否意外损坏了物体或者拾起了多个物体。

在仓库环境中进行缺陷检测需要探索和改进一些关键的计算机视觉技术,如图像分类、异常检测和视频中缺陷事件的检测。

在我们的论文中,我们描述了几种我们采用了的方法来构建ARMBench任务的模型,并报告了我们的模型在这些任务中的表现,以提供其他研究人员性能基准。

- 博客文章链接:https://amazon.science/blog/amazon-releases-largest-dataset-for-training-pick-and-place-robots

- 项目网站和下载地址:http://armbench.s3-website-us-east-1.amazonaws.com

- ARMBench 论文链接:https://arxiv.org/abs/2303.16382,作者为 Chaitanya Mitash、Fan Wang、Shiyang Lu、Vikedo Terhuja、Tyler Garaas、Felipe Polido、Manikantan Nambi。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง