【推荐理由】本文通过潜在意图从被动数据中进行强化学习,从理论和实证上看,这种方案可以学习适用于下游任务的价值预测特征,并且实验表明可以从多种形式的被动数据中学习,包括跨体视频数据和YouTube视频。

Reinforcement Learning from Passive Data via Latent Intentions

Dibya Ghosh, Chethan Bhateja, Sergey Levine

[UC Berkeley]

【论文链接】https://arxiv.org/pdf/2304.04782.pdf

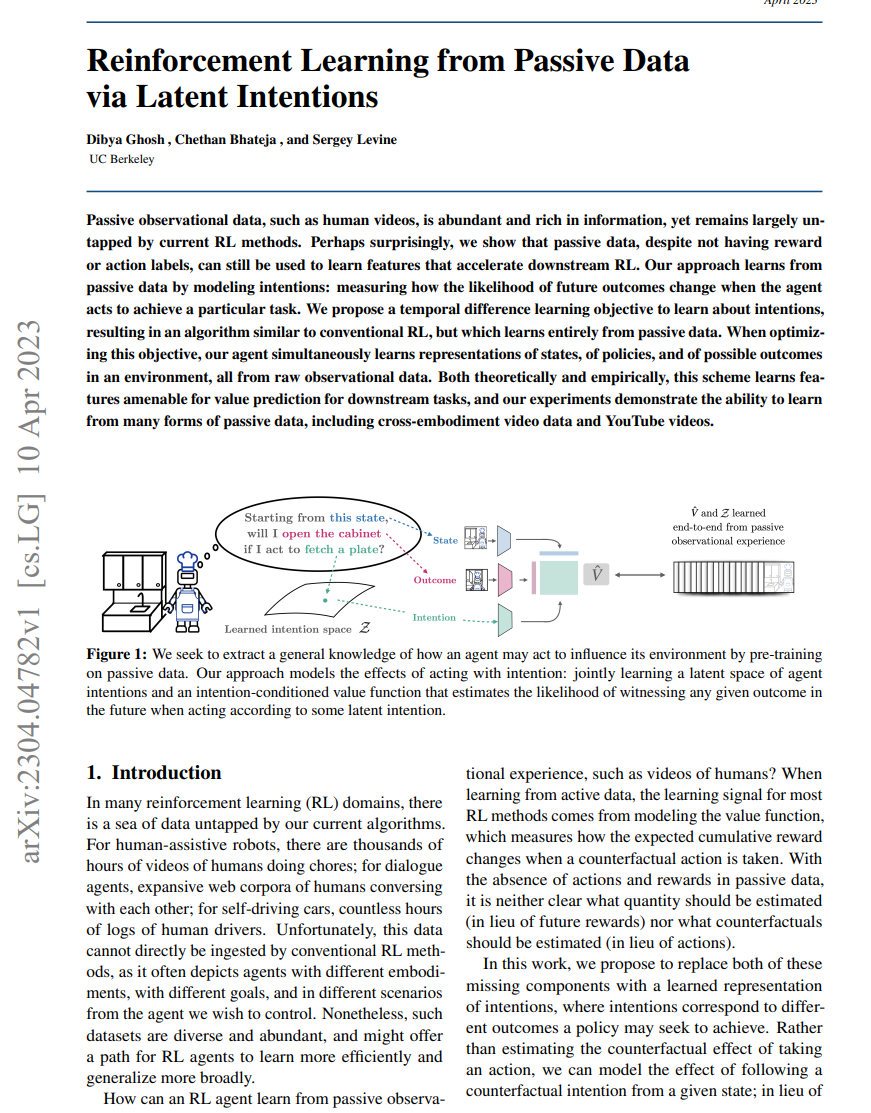

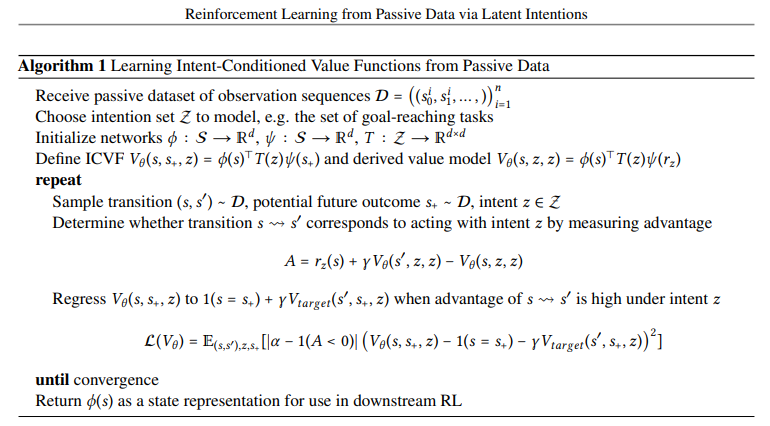

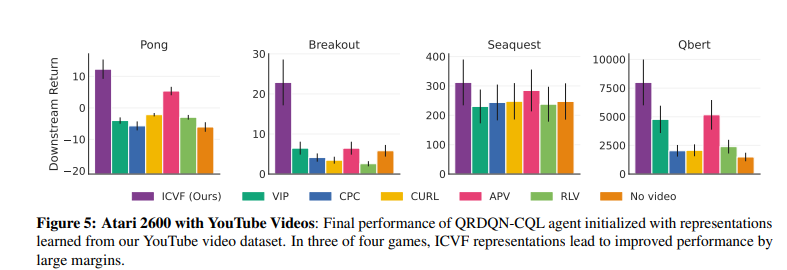

【摘要】被动观察数据(例如人类视频)丰富且信息丰富,但目前的 RL 方法在很大程度上仍未开发。 也许令人惊讶的是,文章表明尽管没有奖励或动作标签,被动数据仍可用于学习加速下游 RL 的功能。 本文的方法通过对意图建模来从被动数据中学习:衡量当代理人采取行动完成特定任务时未来结果的可能性如何变化。 作者提出了一个时间差异学习目标来了解意图,从而产生一种类似于传统 RL 的算法,但它完全从被动数据中学习。 在优化这个目标时,本文的代理同时学习状态、策略和环境中可能结果的表示,所有这些都来自原始观察数据。 在理论上和经验上,该方案都学习了适合下游任务价值预测的特征,该实验证明了从多种形式的被动数据中学习的能力,包括跨实例视频数据和 YouTube 视频。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง