LoRA 是 Low-Rank Adaptation of Large Language Models 的简写,即大型语言模型的低秩适应。它冻结了预训练模型的权重,并将可训练的秩分解矩阵注入到 Transformer 架构的每一层中,大大减少了下游任务的可训练参数数量。

与使用 Adam 微调的 GPT-3 175B 相比,LoRA 可以减少 10,000 倍的可训练参数数量和 3 倍的 GPU 内存需求。LoRA 在 RoBERTa、DeBERTa、GPT-2 和 GPT-3 上的模型质量表现与微调相当或更好,尽管可训练参数更少,训练吞吐量更高,而且与适配器不同,没有额外的推理延迟。

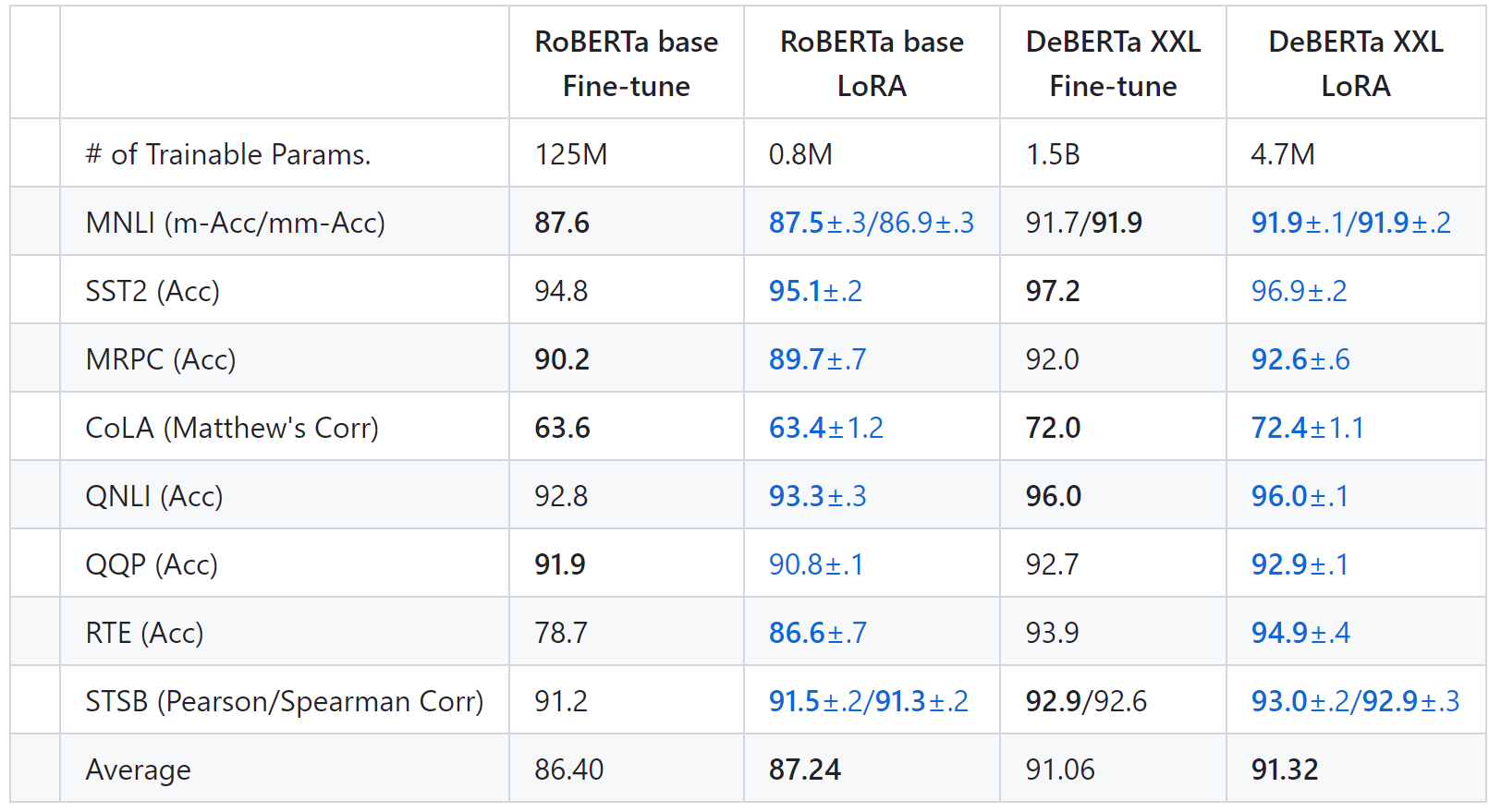

使用 RoBERTa (Liu et al., 2019) base and large 和 DeBERTa (He et al., 2020) XXL 1.5B 在 GLUE 基准上获得了与完全微调相当或优于完全微调的结果,同时只训练和存储了一小部分参数。

单击下面的数字下载 RoBERTa 和 DeBERTa LoRA 检查点

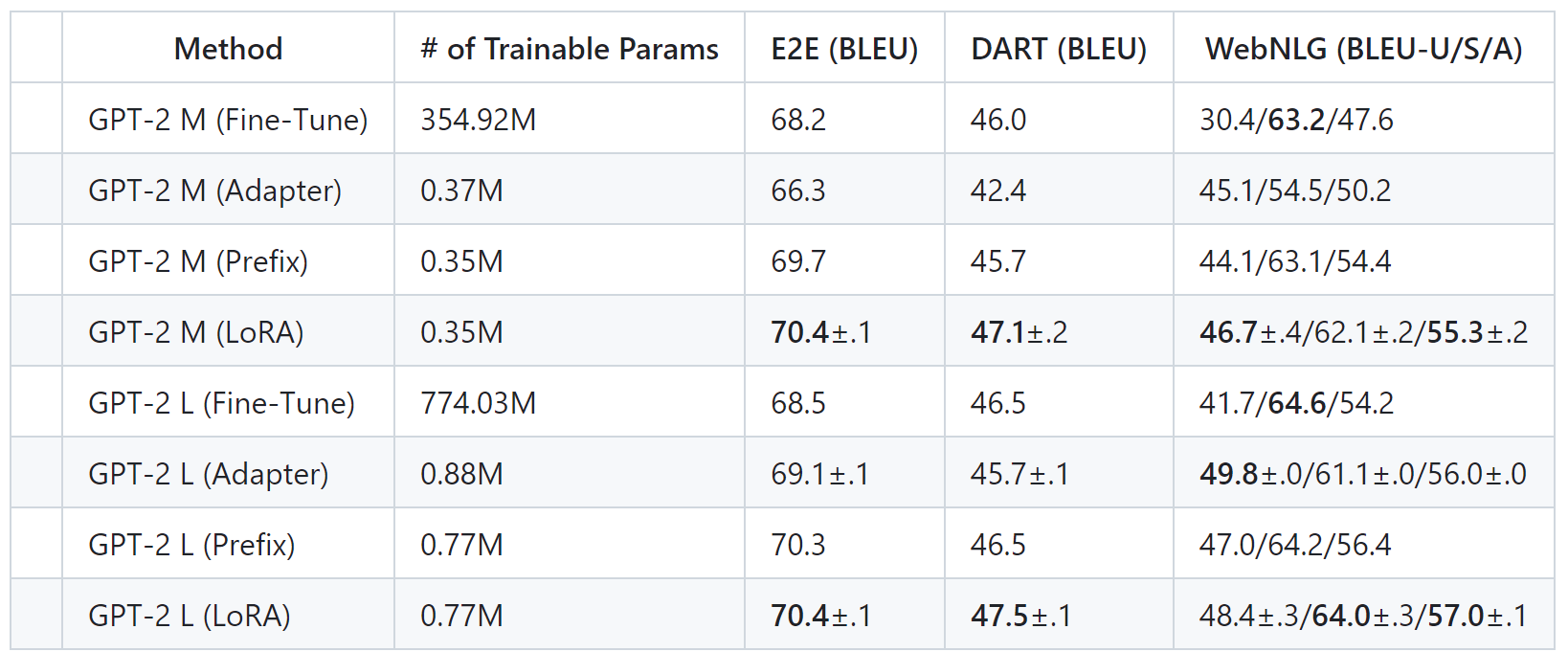

在 GPT-2 上,LoRA 优于完全微调和其他高效调优方法,例如适配器(Houlsby 等人,2019 年)和前缀调优(Li 和 Liang,2021 年)。下面是 E2E NLG Challenge、DART 和 WebNLG 的评估:

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง