Align your Latents: High-Resolution Video Synthesis with Latent Diffusion Models

Andreas Blattmann, Robin Rombach, Huan Ling, Tim Dockhorn, Seung Wook Kim, Sanja Fidler, Karsten Kreis

[NVIDIA & LMU Munich]

潜空间对齐: 基于潜扩散模型的高分辨率视频合成

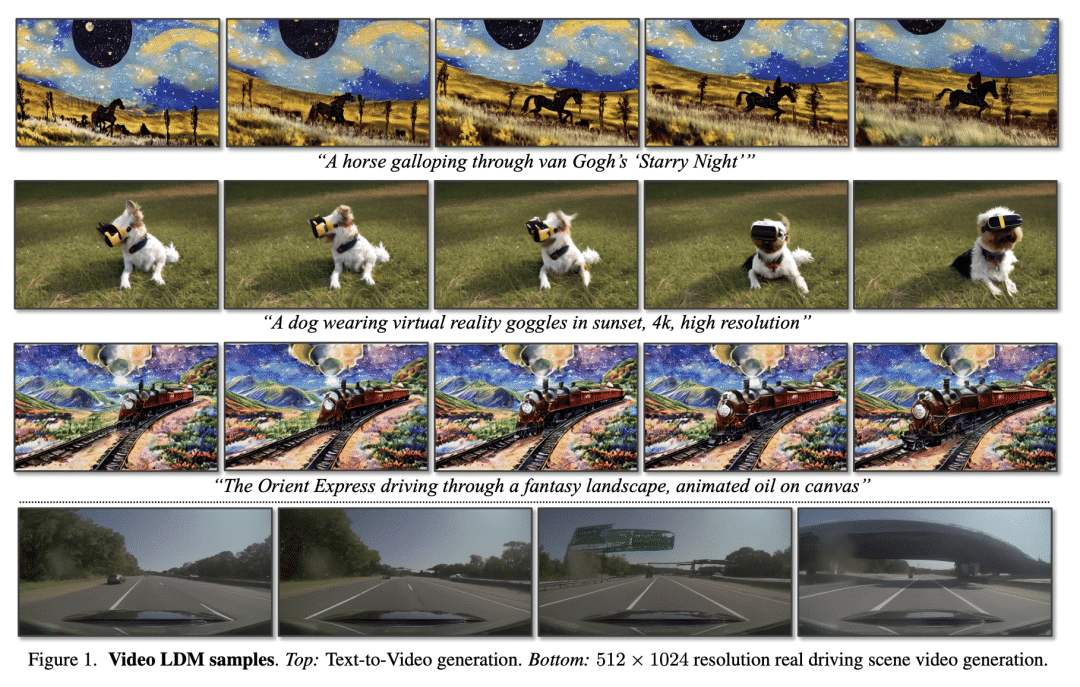

提出一种基于“潜扩散模型”的高分辨率视频合成方法,通过在压缩的低维潜空间训练扩散模型,实现高质量图像合成并避免过多的计算需求,可用于生成高分辨率且时间连贯的驾驶场景视频,并能够将文本转化为视频进行创意内容创作。

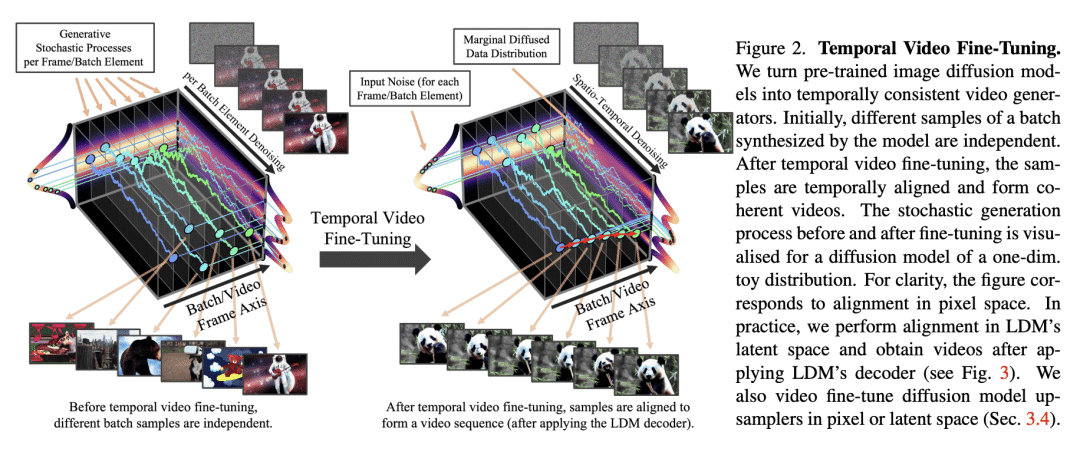

- 动机:要实现高分辨率视频合成是一项资源密集型任务,该论文提出了一种基于“潜在扩散模型”的合成方法,可以在避免过多计算需求的同时实现高质量图像合成和时间连贯的驾驶场景视频生成。

- 方法:首先在图像上预训练“潜扩散模型”,通过将时间维度引入潜在空间扩散模型并在编码的图像序列上微调,将图像生成器变成视频生成器。同时,该方法还将扩散模型升采样器进行时间对齐,将其转换为时间连贯的视频超分辨率模型。

- 优势:该方法在两个实际应用场景中取得了优秀的性能表现,并且可以将公开的、先进的文本到图像LDM Stable Diffusion转化为具有高分辨率视频生成能力的文本到视频LDM。

https://arxiv.org/abs/2304.08818

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง