Scaling Transformer to 1M tokens and beyond with RMT

Aydar Bulatov, Yuri Kuratov, Mikhail S. Burtsev

[DeepPavlov]

https://arxiv.org/abs/2304.11062

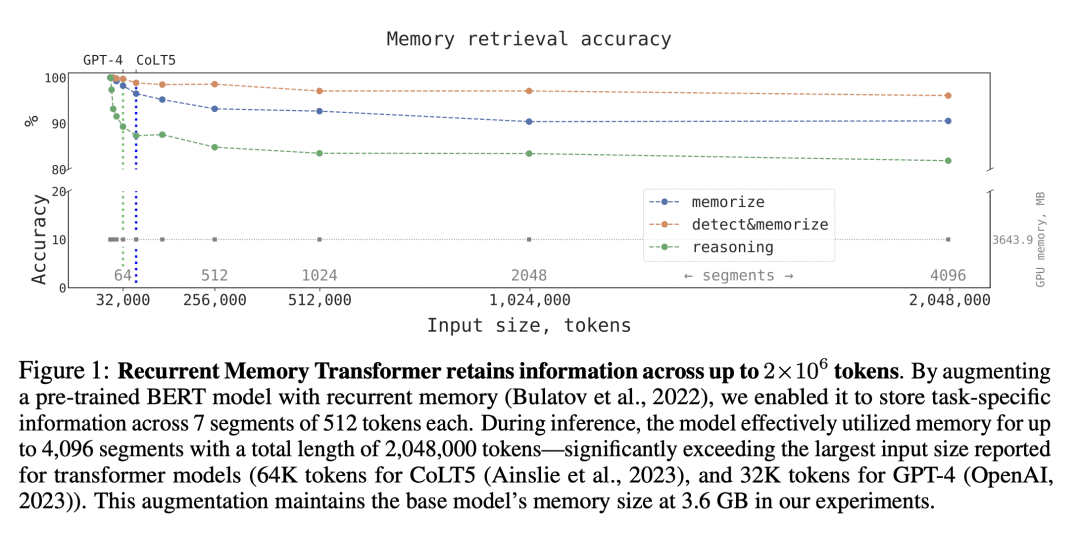

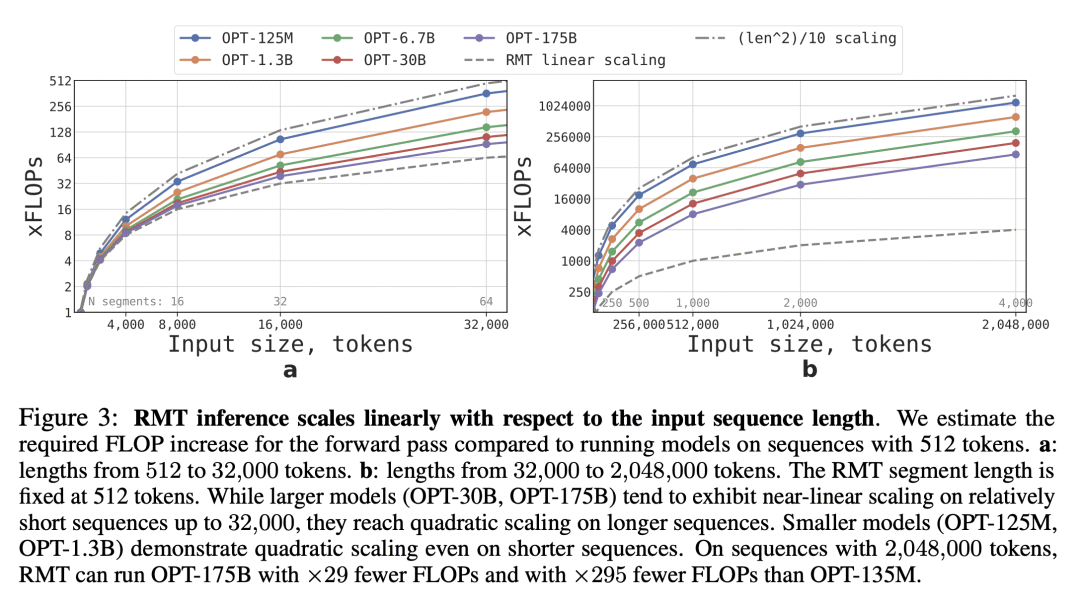

介绍了一种利用循环记忆扩展BERT上下文长度的方法。通过使用循环记忆Transformer(RMT)结构,成功地将模型的有效上下文长度增加到前所未有的200万Token,同时保持高记忆检索精度。允许存储和处理局部和全局信息,并通过使用循环使输入序列的不同段之间实现信息流动。

要点:

- 动机:解决Transformer模型在处理长文本时的记忆限制。

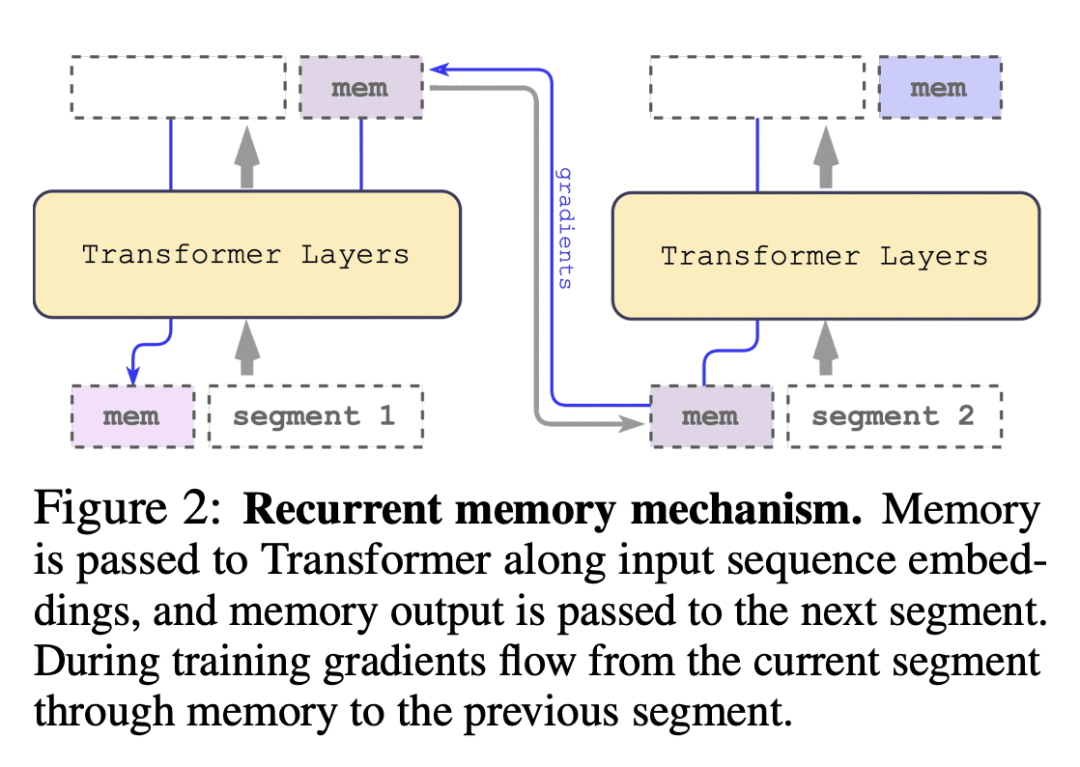

- 方法:用循环记忆Transformer(RMT)结构扩展BERT的上下文长度,实现存储和处理局部和全局信息,并通过使用循环使输入序列的不同段之间实现信息流动。

- 优势:成功将模型的有效上下文长度增加到前所未有的200万Token,同时保持高记忆检索精度。具有显著增强自然语言理解和生成任务中的长期依赖处理以及启用记忆密集型应用大规模上下文处理的潜力。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง