CLaMP: Contrastive Language-Music Pre-training for Cross-Modal Symbolic Music Information Retrieval

Shangda Wu, Dingyao Yu, Xu Tan, Maosong Sun

[Central Conservatory of Music & Microsoft Research Asia]

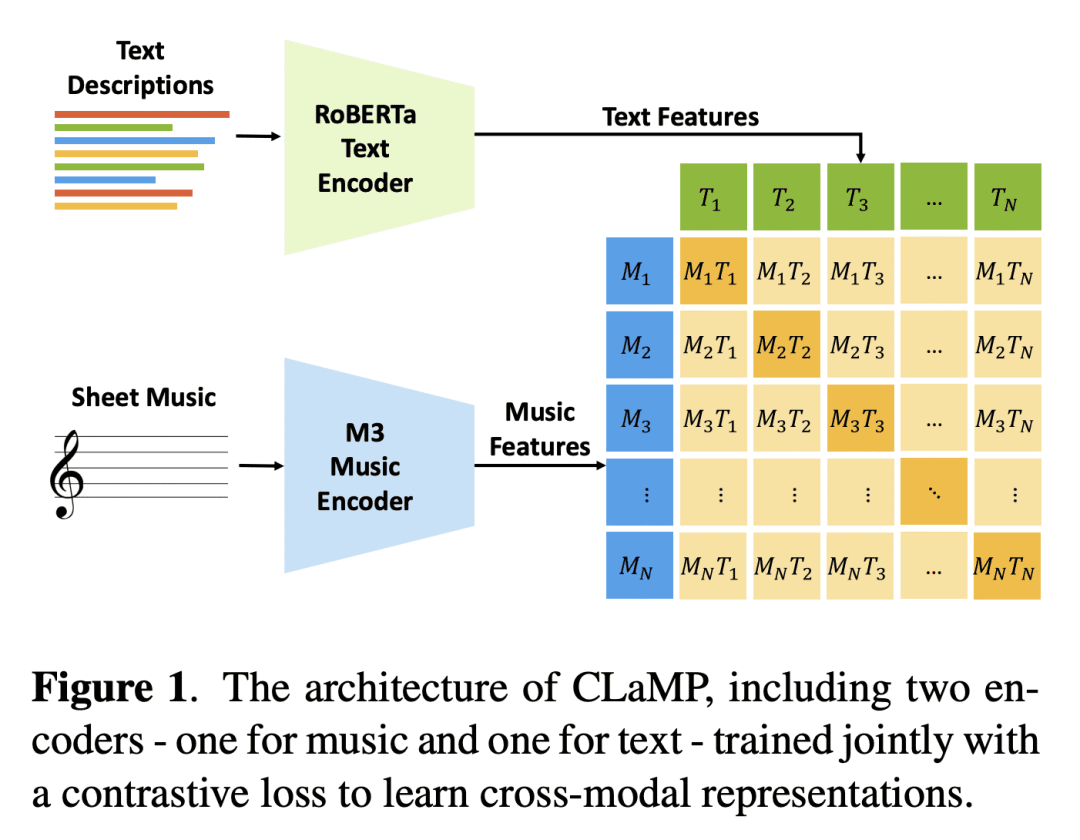

介绍了一个名为 CLaMP 的模型,用对比损失函数对音乐编码器和文本编码器进行联合训练,实现了自然语言和符号音乐之间的跨模态表示学习。采用多种技术来改进对比语言-音乐预训练,如应用文本dropout技术和bar patching技术,以及实现掩码式音乐模型预训练目标等。

面向跨模态符号音乐信息检索的对比语言-音乐预训练

要点:

- 动机:为了实现自然语言和符号音乐之间的跨模态表示学习。

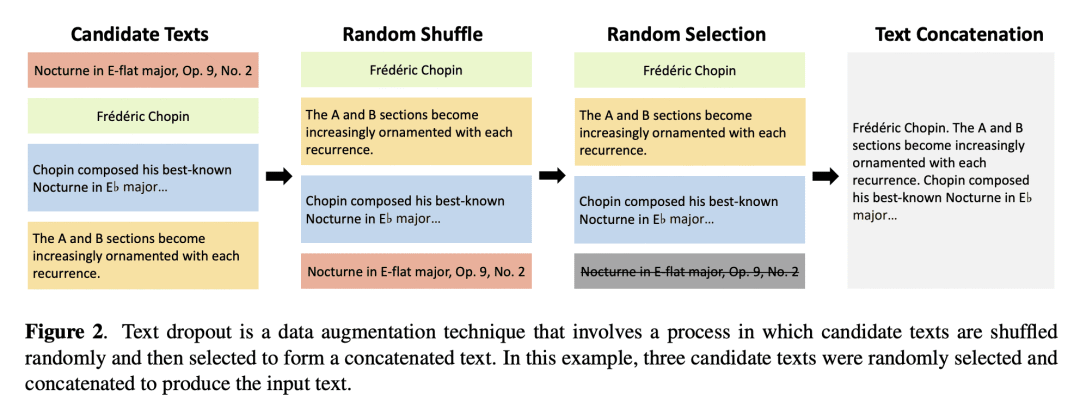

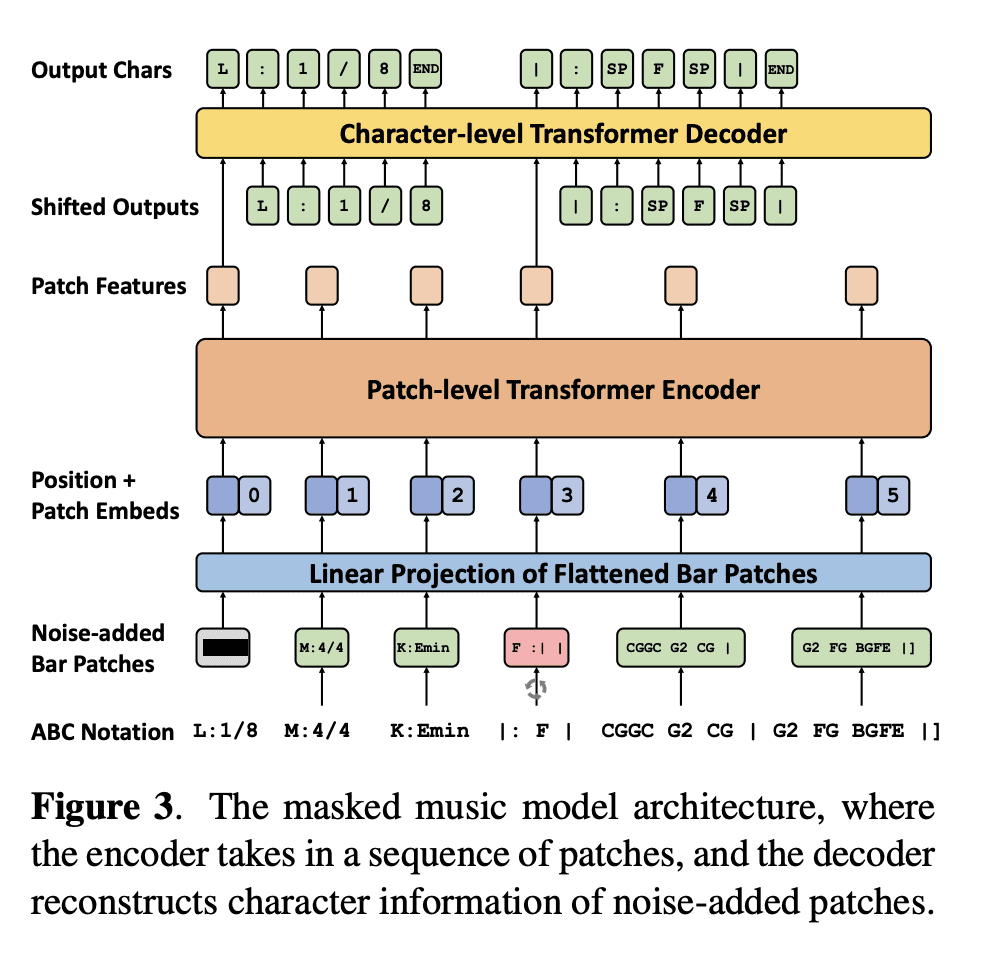

- 方法:使用对比损失函数对音乐编码器和文本编码器进行联合训练,并使用多种技术来改进对比语言-音乐预训练,如应用文本dropout技术和bar patching技术,以及实现掩码式音乐模型预训练目标等。还公开了一个名为 WikiMusicText 的数据集,用于评估语义搜索和音乐分类的性能。

- 优势:CLaMP 跨模态表示学习使其可以执行超越单模态模型的任务,如使用开放域文本查询进行语义搜索和进行新音乐的零样本分类。与需要微调的现有模型相比,无需任何训练的零样本CLaMP在得分导向的音乐分类任务中展现出可比或更高的性能。

https://arxiv.org/abs/2304.11029

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง