初创公司 WhyLabs 宣布推出 LangKi,一个大语言模型 (LLM) 的可观察性和安全标准。LangKit 能够检测开源和专有 LLM 中的风险和安全问题,包括有毒语言、越狱、敏感数据泄露和幻觉。

根据介绍,LangKit 的一个核心卖点是它能够检测所谓的 AI 幻觉;还可以检测有毒的 AI 输出,以及发现模型可能不小心从其训练数据集中泄漏敏感业务信息的情况。LangKit 中的另一组监控功能侧重于帮助公司跟踪模型的可用性。WhyLabs 方面称,该工具包可以监控 AI 响应与用户问题的相关性,并且可以评估这些响应的可读性。

LangKit 使组织能够:

- 验证和保护个别提示和响应:检测提示或回应是否符合政策,并采取纠正措施。

- 评估 LLM 行为是否符合政策:根据一组黄金提示跟踪 LLM 的性能,以检测行为变化或违反政策的情况

- 监控 LLM 驱动的应用程序内的用户交互:监控提示、响应和用户交互,以便对整体用户体验的下降发出警报

- 跨不同的 LLM 和提示版本进行比较和 A/B 测试:确保对 LLM API 的更改不会导致客户体验下降

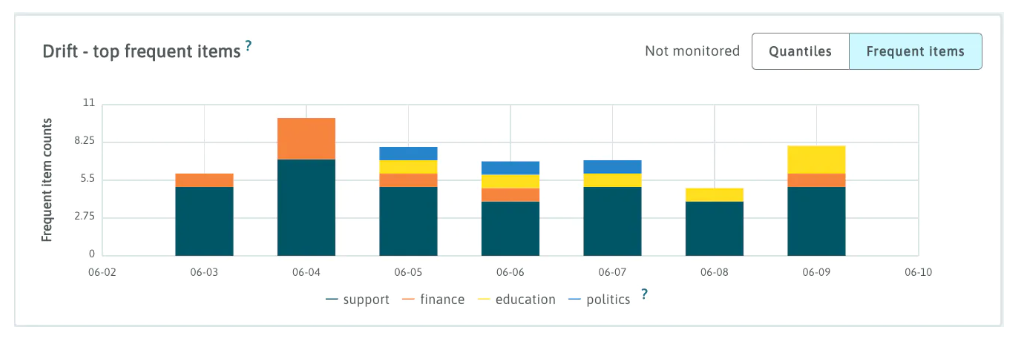

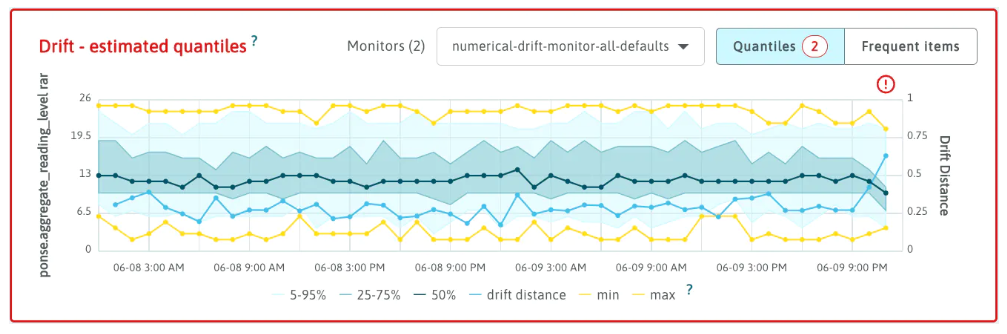

具体来说,由于 LangKit 是开源的,有高级需求的用户可以通过添加自定义监控指标来扩展它。用户可以将 LangKit 配置为在出现某些类型的技术问题时生成警报。该软件还将其收集的错误信息以图表的形式可视化,管理员可以查阅图表以确定语言模型的准确性是否会随着时间的推移而下降,这种现象称为 AI drift。

使用该工具包,软件团队可以在代码更改之前和之后立即将一组测试提示输入到模型中。通过比较 AI 生成的响应,开发人员可以确定更新是提高了还是无意中降低了响应质量。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง