近日,X(原 Twitter)用户@Dylan Patel 展示了一份来自牛津大学的研究:通过对 GPT-4 和大多数其他常见 LLM 的语言进行研究,研究发现 LLM(大语言模型)推理的成本差异很大。

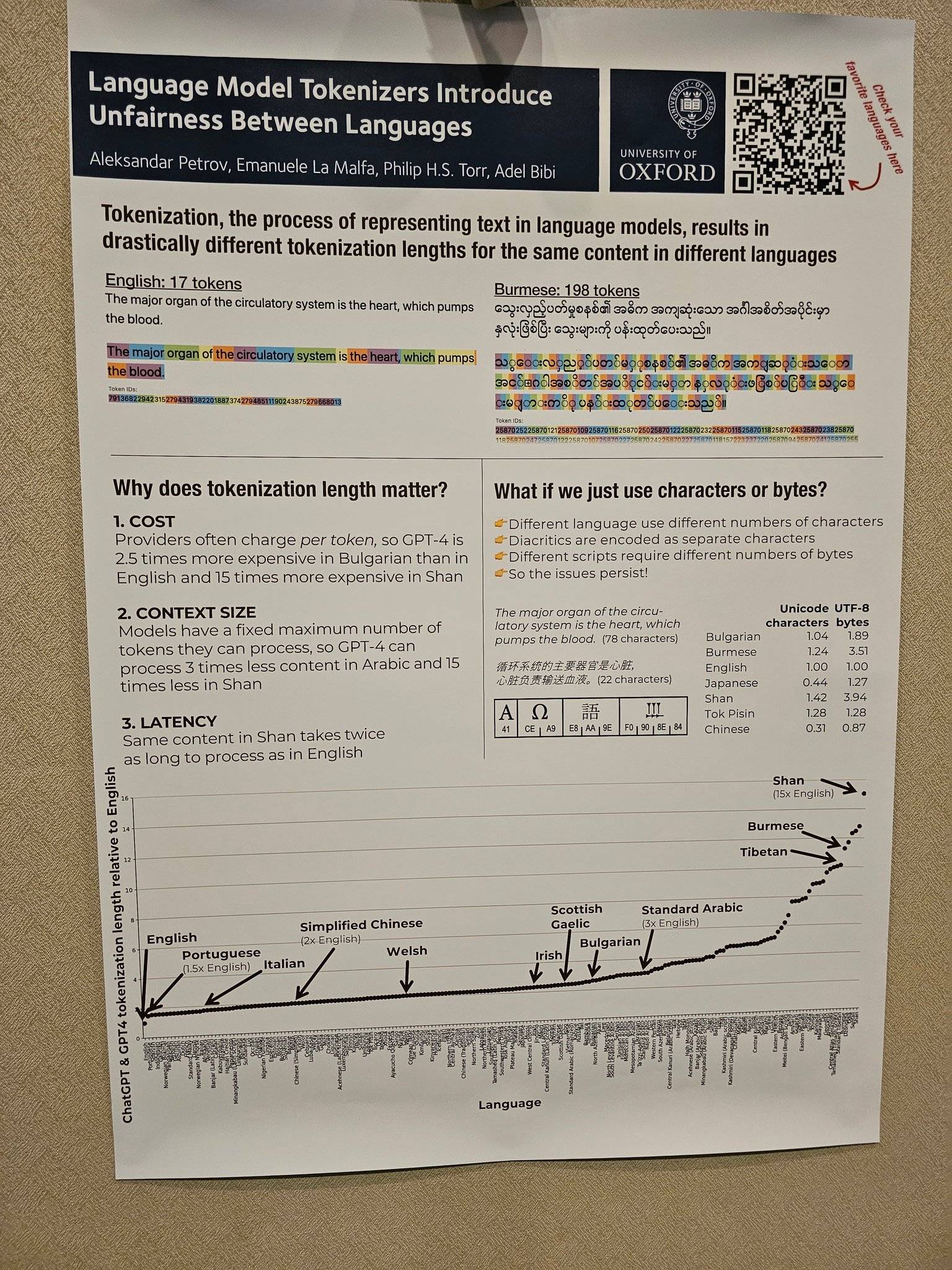

其中英语输入和输出要比其他语言便宜得多,简体中文的成本大约是英语的 2 倍,西班牙语的成本是英语的 1.5 倍,而缅甸掸语则是英语的 15 倍。

究其原理,可以追溯到今年 5 月份牛津大学在 arXiv 上刊印的一篇的论文。

词元是将自然语言文本转换成词元(token)序列的过程,是语言模型处理文本的第一步。在 LLM 计算力成本的核算中,词元越多,耗费计算力的成本越高。

毫无疑问,在生成式 AI 商业化的趋势下,计算力的耗费成本也会嫁接给用户,当下许多 AI 服务也正是按照需要处理的词元数量来计费。

论文显示,研究者通过分析 17 种词元化方法后,发现同一文本被转换成不同语言词元序列时长度差异巨大,即使是宣称支持多语言的词元化方法,也无法做到词元序列长度完全公平。

例如,根据 OpenAI 的 GPT3 tokenizer,倘若给「你的爱意」词元化,英语只需两个词元,而在简体中文中则需要八个词元。即使简体中文文本只有 4 个字符,而英文文本有 14 个字符。

从 X 用户 @Dylan Patel 曝光的图片也可以直观看到,让 LLM 处理一句英语需要 17 个词元(tokens),而让 LLM 处理同样意思的一句缅语,则需要 198 个词元(tokens)。这意味着缅语的处理成本将达到英语的 11 倍。

类似的情况也有很多,Aleksandar Petrov 的网站中提供了许多相关的图标和数据,感兴趣的朋友不妨点击「https://aleksandarpetrov.github.io/tokenization-fairness/」进去查看语言之间的差异。

在 OpenAI 的官网上也有着类似的页面,解释了 API 是如何对一段文本进行词元化,以及显示该文本的词元总数。官网也提到,一个词元通常对应英语文本的约 4 个字符,100 个词元约等于 75 个单词。

得益于英语词元序列长度短的优势,在生成式人工智能预训练的成本效益方面,英语可谓是最大赢家,将其他语言使用者远远地甩在身后,间接产生了一种不公平的局面。

除此之外,这种词元序列长度的差异也会导致处理延迟不公平(某些语言处理同样内容需要更多时间)和长序列依赖性建模不公平(部分语言只能处理更短的文本)。

简单点理解,就是某些语言的用户需要支付更高的成本,承受更大的延迟,获得更差的性能,从而降低了他们公平地访问语言技术的机会,也就间接导致了英语使用者和世界其他语言使用之间形成了 AI 鸿沟。

仅从输出的成本来看,简体中文的成本是英语的两倍。伴随着 AI 领域的深层次发展,总是「差一步」的简体中文显然并不友好。在成本等各方面叠加因素的权衡下,非英语母语的国家也纷纷尝试开发自己的母语语言大模型。

以中国为例,作为国内最早一批探索 AI 的巨头,2023 年 3 月 20 日,百度正式上线生成式 AI 文心一言。

随后阿里巴巴的通义千问大模型、华为的盘古大模型等一批批优秀大模型也陆续涌现出来。

在这当中,华为盘古大模型中的 NLP 大模型更是行业内首个千亿参数中文大模型,拥有 1100 亿密集参数,经过 40TB 的海量数据训练而成。

正如联合国常务副秘书长阿米娜·穆罕默德曾经在联合国大会上警告说,如果国际社会不采取果断行动,数字鸿沟将成为「不平等的新面孔」。

同理,伴随着生成式 AI 的狂飙突进,AI 鸿沟也很有可能成为新一轮值得关注的「不平等的新面孔」。

所幸的是,平时「惨遭嫌弃」的国内的科技巨头已然采取了行动。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง